文献阅读课14-DIAG-NRE: A Neural Pattern Diagnosis Framework for远程监督关系抽取,模式标注去噪自动化,FN,FP,RL

文章目录

- abstract

- 1. Introduction

- 2.相关工作

- 3.方法

- 3.1 NRE Models

- 3.2 Pattern Extraction

- 3.3 Pattern Refinement

- 3.4 Weak Label Fusion(WLF)

- 4 Experiments

- 4.1 Experimental Setup

- 4.2 Performance Comparisons

- 4.3 Pattern-based Diagnostic Results

- 4.4 Incremental Diagnosis

- 4.5案例研究

- 参考文献

Zheng, S., et al. (2019). DIAG-NRE A Neural Pattern Diagnosis Framework for Distantly Supervised Neural Relation Extraction. Proceedings ofthe 57th Annual Meeting ofthe Association for Computational Linguistics.

code+data

abstract

基于模式的标记方法在减轻远距离监督神经关系提取中不可避免的标记噪声方面取得了可喜的成果。但是,这些方法需要大量的专家工作来编写关系特定的模式,这使得它们过于复杂而无法快速推广。为了减轻模式编写的劳动密集型工作量并快速将其推广到新的关系类型,我们提出了一种神经模式诊断框架DIAG-NRE,该框架可以与专家在回路中自动从噪声数据中总结和改进高质量的关系模式。 。为了证明DIAG-NRE的有效性,我们将其应用于两个真实世界的数据集,并提出了对现有技术方法的重大和可解释的改进。

- 远程监督神经网络关系抽取

- 基于模式的标注方法

- 去噪好

- 缺点

- 需要大量专家手动编写关系的特定模式

- 难以推广

- 本文:DIAG-NRE

- 目标:减轻模式编写的人工工作量

- 效果:可以和专家协同从噪声数据中总结和改进来得到高质量的关系模式(去噪)

- 基于模式的标注方法

1. Introduction

关系提取旨在从纯文本中提取关系事实,并可以为下游的知识驱动型应用带来好处。关系事实被定义为头部实体和尾部实体之间的关系,例如(Letizia Moratti,Birthplace,Milan)。传统方法通常将关系提取视为有监督的分类任务,该任务可预测句子中提到的两个检测到的实体之间的关系类型,包括统计模型(Zelenko等,2003; Zhou等,2005)和神经模型(Zeng等人,2014年; dos Santos等人,2015年)。

这些受监督的模型需要训练大量的人工注释数据,这些数据收集起来既昂贵又费时。因此,Craven等。 (1999); Mintz等。 (2009年)提出了远程监督(DS),该方法可以通过将知识库(KB)的相关事实与纯文本对齐,并假设提到两个实体的每个句子都可以在关系图中描述它们的关系,从而自动生成用于关系提取的大规模培训数据。 KB由于DS可以在无需人工注释的情况下获取大规模数据,因此已被最近的神经关系提取(NRE)模型广泛采用(Zeng等,2015; Lin等,2016)。

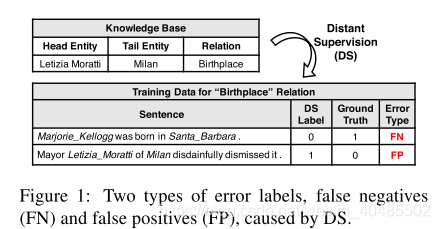

尽管DS在许多情况下既简单又有效,但不可避免地会引入无法忍受的标记噪音。如图1所示,错误标签有两种类型,误报和误报。否定否定的原因是,句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖。对于误报,这是因为并非所有提及实体对的句子实际上都在KB中表达了它们之间的关系。当KB和文本不匹配时,噪声标记问题可能会变得更加严重,从而严重削弱模型的性能(Riedel等,2010)。

- 关系抽取

- 有监督分类任务

- 统计模型

- 神经模型

- 远程监督

- 文本与知识库中事实对齐

- 假设两个实体提及的每个句子都可以在关系图中描述他们的关系

- 问题:噪声

- 两种:

- FN:句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖

- FP:并非所有提及实体对在句子中的关系是在KB中的关系。

- 当KB和句子不匹配的时候噪声更大

- 两种:

- 解决:适当采取人工措施

- 人标注的数据与DS的数据混合

- Zhang et al. (2012); Pershina et al. (2014); Angeli et al. (2014); Liu et al. (2016)

- 需要足够大的人工标注数据,才有用,因为DS数据要大得多

- 基于模式的标注

- 特定于关系的模式

- Ratner et al. (2016); Liu et al. (2017a)

- 关键思想:

- 弱监督源(DS+基于模式的启发式方法)

- 弱标签融合(WLF)模型

- –>生成去噪标签

- 缺点:

- 一个关系一个模式,来新的了需要重新编写

- 编写:高技能且劳动密集–需要专家(很复杂)

- 神经模式诊断框架DIAG-NRE

- 为常见的NRE模型在DS和WLF之间构建了桥梁

- 目标:减轻模式编写的人工工作量

- 效果:可以和专家协同从噪声数据中总结和改进来得到高质量的关系模式(去噪)

- 减少人类专家的工作量和难度

- 需要的人类注释也少

- 还给噪声的行为提炼出了模式

- 工作流:

- 模式提取:用强化学习从NRE模型中提取潜在的模式

- 模式提炼:人类专家注释一部分主动选择的示例(主动学习,会向人要吗?)

- DIAG-NRE->WLF->NRE Model

- 贡献:

- 通过自动生成模式来简化人类专家的模式编写工作;

- 通过只需要少量的人工注释就可以快速将其归纳为新的关系类型;

- 提出显着和可解释的性能改进以及直观的诊断分析。

- 对大量FN的噪声数据集处理效果好

- 与其他的关系模式挖掘的区别:

- 1)仅基于RL,

- 2)不依赖任何词法或句法注释

- 3)通过预测NRE模型可以了解模式的重要性

- 人标注的数据与DS的数据混合

- 有监督分类任务

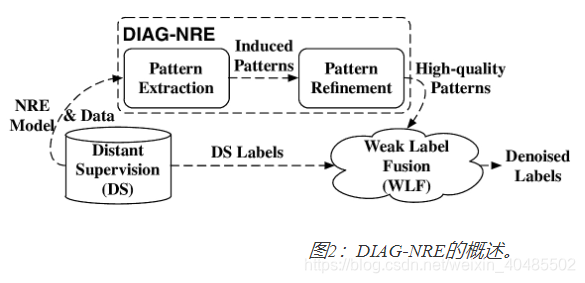

为了简化人类专家的模式编写工作并实现对新关系类型的快速概括,我们提出了一种神经模式诊断框架DIAG-NRE,它为常见的NRE模型在DS和WLF之间建立了桥梁。如图2所示,DIAG-NRE的一般工作流包含两个关键阶段:1)模式提取,通过采用强化学习(RL)从NRE模型中提取潜在模式,以及2)模式提炼,要求人类专家注释一小部分一组主动选择的示例。按照这些步骤,我们不仅可以通过自动生成模式来最大程度地减少人类专家的工作量和难度,而且还只需要少量的人类注释就可以实现快速概括。经过DIAG-NRE处理后,我们获得了具有高概率的支持或不支持目标关系的高质量模式,并且可以将它们馈入WLF阶段以获取去噪标签并重新训练更好的模型。为了证明DIAG-NRE的有效性,我们在两个真实的数据集上进行了广泛的实验,其中DIAG-NRE不仅在现有技术上取得了显着改善,而且还通过提炼为不同的噪声行为提供了深刻的诊断结果模式。

尽管DS在许多情况下既简单又有效,但不可避免地会引入无法忍受的标记噪音。如图1所示,错误标签有两种类型,FP和FN。FN的原因是,句子确实描述了有关目标关系的两个实体,但事实尚未被知识库所涵盖。对于FP,这是因为并非所有提及实体对的句子实际上都在KB中表达了它们之间的关系。当KB和文本不匹配时,噪声标记问题可能会变得更加严重,从而严重削弱模型的性能(Riedel等,2010)。

最近的研究已经认识到,采取适当的人工措施对于减少此类标签噪音至关重要。例如,Zhang等。 (2012); Pershina等。 (2014); Angeli等。 (2014);刘等。 (2016年)将一小部分人群注释标签与纯DS生成的噪声标签混合在一起。但是,他们发现只有足够大和高质量的人类标签才能带来显着的改进,因为噪声标签的数量大得多。

为了扩大人类努力的影响,Ratner等人。 (2016);刘等。 (2017a)建议纳入基于模式的标签,其关键思想是将DS和基于模式的启发式方法都视为弱监督源,并开发弱标签融合(WLF)模型以生成去噪标签。但是,WLF范式的主要局限性在于要求人类专家编写特定于关系的模式。不幸的是,编写好的模式既是一项高技能又是一项劳动密集型的任务,需要专家学习详细的模式编写说明,检查适当的示例,针对不同的极端情况调整模式等。例如,Ratner等人的配偶关系示例。 (2016年)使用11个函数以及20多个特定于关系的关键字1。更糟糕的是,当归纳为新的关系类型时,我们需要再次重复上述艰难的手动操作。

2.相关工作

为了减少DS的标签噪声,早期的工作尝试设计能够更好地容忍标签噪声的特定模型架构,例如多实例学习范式(Riedel等,2010; Hoffmann等,2011; Surdeanu等, 2012; Zeng等,2015; Lin等,2016; Wu等,2017)。这些模型通过将多个提及同一实体对的句子组合在一起作为一个包,然后假设该包中至少有一个句子表达了这种关系,从而放宽了DS的原始假设。这个较弱的假设可以在一定程度上缓解噪声标签问题,但是这个问题仍然存在于包装袋层面,Feng等人。 (2018)发现袋级模型难以进行句子级的预测。

后来的工作试图设计用于训练的动态标签调整策略(Liu等人,2017b; Luo等人,2017)。特别是,最近的工作(Feng等人,2018; Qin等人,2018)采用RL来训练与NRE模型进行交互的代理,以学习如何去除或更改噪声标签。通过利用DS生成的标签与模型预测的标签之间的一致性和差异,这些方法无需人工干预即可工作。但是,这样的方法既不能发现与模型预测一致的噪声标签,也不能解释去除或更改标签的原因。正如引言中所讨论的那样,引入人类的努力是一个有希望的方向,既可以做出重大的又可以解释的改进,这也是本文的重点。

- 远程监督-去噪

- MIL多实例学习

- (Riedel et al., 2010; Hoffmann et al., 2011; Surdeanu et al., 2012; Zeng et al., 2015; Lin et al., 2016; Wu et al., 2017)

- 句子包:同一实体对(可能有多个提及)的句子组合在一起–>包

- 假设:包中至少有一个句子表达了这种假设,放宽了DS的假设

- 效果:可以一定程度上缓解噪声问题

- 缺点:缓解,但在包级仍存在

- 难以进行句子级预测:Feng et al. (2018)发现

- 动态标签调整策略-用以训练

- (Liu et al., 2017b; Luo et al., 2017).

- RL强化学习

- 目标:训练一个与NRE模型交互的代理,以学习如何去除或更改噪声标签

- 通过利用DS的标签与模型预测标签的一致性和差异(RL会学到这个)

- 可自动化

- 缺点:发现不了与模型预测一致的噪声标签;不可解释性

- 补充:自动化去噪的研究

- ACL2018:DSGAN

- 以对抗网络,发现FP和TP的区别,从而剔除FP

- 是个单独的去噪处理器(DS)

- 句子级别

- ACL2018:DSGAN

- (人工+半自动化最好)

- 关系模式挖掘

- (Califf and Mooney, 1999; Carlson et al., 2010; Nakashole et al., 2012; Jiang et al., 2017).

- 反语义模式

- Takamatsu et al. (2012)

- 通过example-pattern-relation共存推断否定句法模式,并相应地删除了假阳性FP标签

- 本文与其他的区别:

- 1)仅基于RL,

- 2)不依赖任何词法或句法注释

- 3)通过预测NRE模型可以了解模式的重要性

- 与Takamatsu相反:

- 减少消极模式以减轻FP

- 增强了积极模式以解决FP

- 关系模式挖掘

- MIL多实例学习

- 模式提取(都是RL)

- vanilla LSTM(Hochreiter and Schmidhuber, 1997) :

- 利用RL发现结构化表示

- Zhang et al. (2018)

- 情感预测

- 使用RL来发现改变决策的短语(情感词吧?)

- Li et al. (2016)

- NRE模型

- NRE只关心句子中提到的实体的关系的语义–唯一的

- 本文是第一个用RL提取模式的(在NRE领域中)

- vanilla LSTM(Hochreiter and Schmidhuber, 1997) :

模式提取部分,我们注意到有些方法具有相似的见解,但目的不同。例如,Zhang等。 Li等(2018)通过利用RL发现结构化表示来改善了香草LSTM的性能(Hochreiter和Schmidhuber,1997)。 (2016)通过使用RL来发现决策改变的短语来解释神经模型的情感预测。但是,NRE模型是唯一的,因为我们只关心句子中提到的语义实体关系。据我们所知,我们是第一个通过RL从NRE模型中提取模式的公司。

我们还注意到关系模式挖掘已经得到了广泛的研究(Califf and Mooney,1999; Carlson等,2010; Nakashole等,2012; Jiang等,2017)。与那些研究不同,我们的模式提取方法1)仅基于RL,2)不依赖任何词法或句法注释,并且3)通过预测NRE模型可以了解模式的重要性。此外,高松等。 (2012)通过example-pattern-relation共存推断否定句法模式,并相应地删除了假阳性标签。相反,在现代神经模型的基础上,我们的方法不仅减少了消极模式以减轻误报,而且还增强了积极模式以同时解决误报。

3.方法

通过提供DS生成的数据和经过训练的NRE模型,DIAG-NRE可以为WLF台生成高质量的模式,以产生去噪的标签。如图2所示,DIAG-NRE通常包含两个关键阶段:模式提取(第3.2节)和模式优化(第3.3节)。此外,为了完整起见,我们在第3.4节中简要介绍了WLF范例。接下来,我们首先回顾一下现代NRE模型的通用输入输出模式。

- DIAG-NRE:

- DS生成的数据,经过训练的NRE模型(在DS上)–>产生去噪的标签

3.1 NRE Models

- 输入:一个实例(句子,实体对)–>x=[word embedding;position embedding]

- 概率

3.2 Pattern Extraction

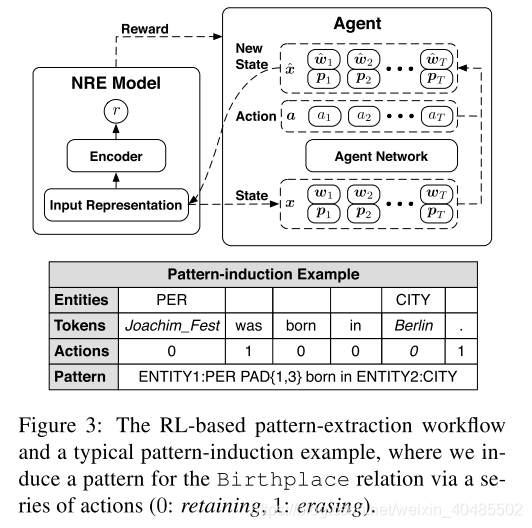

在这个阶段,我们构建一个模式提取代理,从具有上述输入输出模式的NRE模型中提取关系特定的模式。基本思想是擦除不相关的令牌并同时保留原始目标预测,可以将其建模为令牌擦除决策过程并由RL优化。图3以一般方式显示了这种基于RL的工作流以及一个直观的模式归纳示例。接下来,我们详细介绍此工作流程。

- 模式提取

- 构建一个模式提取代理

- 从上述的NRE模型–>提取特定于关系的模式

- 思想:在保证原始目标预测的前提下,擦除无关的token

- 建模:token擦除决策过程,以RL优化(如图3)

- 实例s,第i列(第i个嵌入)

- Action:对每个xi采取行动ai:

- 行动:0:retaining,1:erasing

- 擦除的i:–删除语义

- 行动序列:–保留下来的token数量为

- Reward:

- 目标:找到保留原始预测一致性的最简单序列(预测不变的前提下删除更多的token)

- State:

- 要求:独立于NRE;应需要合并当前实例的完整信息

- 输入表示x用作状态

- Agent:

- 用基于策略的RL来训练基于神经网络的代理

- 并行计算

- 行动序列:

- 网络:可在决策时丰富上下文信息,双向LSTM:x->h

- Attention:将h聚合为c

- 最终表示:

- 每个行动的概率:

- 优化

- 强化学习算法+策略梯度方法来优化参数

- 关键:梯度公式+BP

- 目标函数:

- 梯度:

- 平衡:利用ϵ贪婪技巧来平衡勘探和开发

- 模式归纳

- 给定实体和ai:

- 用相应实体类型替换原始实体对

- 评估代理–>保留了相对距离的保留token(如图3)

- 擦除的替换为PAD

- 为了启用通用位置只是,将两个保留token之间的相对距离分为四类

- 0距离

- 短距离(1-3)

- 中距离(4-9)

- 长距离(>10

- 这种格式,可以包含多种信息:(实体类型,关键token,相对距离)

- 给定实体和ai:

- 构建一个模式提取代理

奖励。我们的目的是找到保留原始预测一致性的最简单的序列。因此,给定原始输入表示形式x和相应的动作向量a,我们将奖励定义如下:

其中,总奖励由两部分组成:一个是追求高预测置信度的对数似然项,另一个是稀疏比率项,用于根据保留的令牌诱导稀疏性。我们通过超参数η平衡这两部分。

state:通常,提供给代理的状态应独立于NRE体系结构。此外,状态需要合并当前实例的完整信息。因此,在我们的设计中,代理直接将输入表示x用作状态。

优化:我们采用REINFORCE算法(Williams,1992)和策略梯度方法(Sutton等,2000)来优化代理网络的参数,关键步骤是重写梯度公式,然后应用反向传播算法(Rumelhart)。等人,1986)更新网络参数。具体来说,我们将目标定义为:

模式归纳。给定实例和相应的代理动作,我们采取以下步骤来生成紧凑模式。首先,一般来说,我们用相应的实体类型替换原始实体对。然后,我们评估代理以获取保留了相对距离的保留令牌。为了启用通用位置指示,我们将两个相邻保留令牌之间的相对距离分为四类:零(它们之间没有令牌),短(1-3个令牌),中(4-9个令牌)和长(10个或更多)令牌)距离。例如,图3显示了一个典型的模式归纳示例。具有这种格式的模式可以包含多种关键信息,例如实体类型,关键令牌以及它们之间的相对距离。

3.3 Pattern Refinement

- 模式优化

-

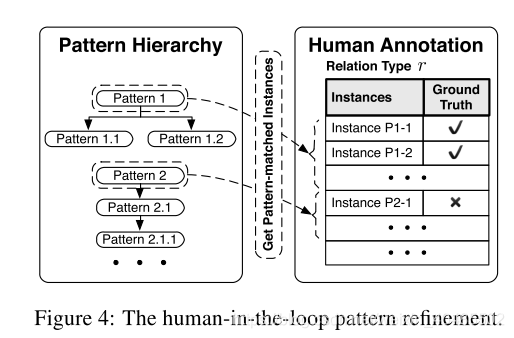

人类在循环之中,系统会向人类求助(主动学习)

-

模式层次结构Pattern Hierarchy.

- 模式提取:实例级别

- 数据集级别:聚合后存在冗余

- 使用模式层次结构合并冗余模式

- 层次结构:父模式涵盖了子模式匹配的所有实例

- 若父已经有了足够的关系支持信号,则可不用人工标注子模式

-

Human Annotation.

- 通过人类专家注释少量主动选择的实例

- 为了定量评估模式的质量

- 系统请求个模式的人类标注

- 代表性越高,模式涵盖的实例数越多–按模式的实例数选择最具代表性的个模式

- 一个关系个模式

- 每个模式,随机选出个实例进行人类标注

- 代表性越高,模式涵盖的实例数越多–按模式的实例数选择最具代表性的个模式

- 质量分类

- 正模式集合:精度

- 负模式集合:(和实例匹配不好的模式)

- 划分是为了WLF

- 超参数:

-

上述模式提取阶段通过为每个评估实例生成一个模式来在实例级别上进行操作。但是,在数据集级别聚合可用模式之后,不可避免地会存在冗余模式。因此,我们设计了一个模式层次结构来合并冗余模式。之后,我们可以通过要求人类专家注释少量主动选择的示例来将人类专家引入工作流程。图4显示了此阶段的一般工作流程。

模式层次结构。为了识别冗余模式,我们将具有相同模式的多个实例分组,并通过匹配的统计信息构建模式层次结构。在此层次结构中,父模式应涵盖与子模式匹配的所有实例。由于父模式已经具有足够的关系支持信号,因此我们可以省略子模式进行人工注释。此外,可以从中诱发出模式的实例数量与模式代表性密切相关。因此,我们按照该数字的降序选择用于人类注释的顶级最有代表性的模式。

3.4 Weak Label Fusion(WLF)

- 弱标签融合

- 目标:融合来自多个标签来源(包括DS和模式)的弱标签,以产生去噪标签。

- 本文WLF中采用data programing(DP)(Ratner et al。,2016)

- DP输入单元:标签函数

- 输入实例

- 输出标签:(+1:正,-1:负或0:未知)

- 本文中

- DS:+1,-1,0

- 正模式集合:+1,0

- 负模式集合:-1,0

- 训练:在少量人类标注的标签上训练

- 由此获得了去噪标签

WLF模型旨在融合来自多个标签来源(包括DS和图案)的弱标签,以产生去噪标签。在本文中,我们在WLF模型中采用数据编程(DP)(Ratner et al。,2016)。DP的输入单元称为标签功能(LF),它具有一个实例并发出标签(+1:正,-1:负或0:未知)。在我们的情况下,DS的LF生成+1或-1,正模式的LF生成+1或0,负模式的LF生成-1或0。我们用封闭形式的解决方案估算了一小组带有人类注释的标签上的DP参数(有关详细配方,请参见附录)。借助DP,我们获得了去噪标签,以重新训练更好的模型。请注意,设计更好的通用WLF模型仍然是一个热门的研究主题(Varma等,2016; Bach等,2017; Liu等,2017a),但超出了这项工作的范围,它会自动生成模式以缓解人类的工作。

4 Experiments

- 目标:证明其有效性

4.1 Experimental Setup

- 评估

- 不用Precision,Recall和F1分数–关系类型分类不平衡

- 微观平均评估–会忽略噪声标签问题

- 仅使用人类注释的测试数据来聘雇在噪声标签上训练的模型

- Ratner et al. (2016); Liu et al. (2016) did

- 原因:许多关系类型的严重标记噪音削弱了基于DS的held-out评估(Mintz等,2009)的可靠性

评估。为了清楚地显示各种关系类型的不同噪声行为,我们将每个关系预测任务视为单个二进制分类问题,即针对给定实例预测该关系的存在与否。与以前的研究不同,我们在数据集级别报告特定于关系的度量(Precision,Recall和F1分数,均采用百分比格式)和宏观平均的度量,因为关系类型的分布极不平衡,而微观平均评估不可避免地会忽略许多关系类型的嘈杂标签问题。此外,正如Ratner等人所述,我们仅利用人工注释的测试数据来评估在噪声标签上训练的模型。 (2016);刘等。 (2016)做到了。原因是许多关系类型的严重标记噪音严重削弱了基于DS的保持性评估的可靠性(Mintz等,2009),这无法准确地判断性能。

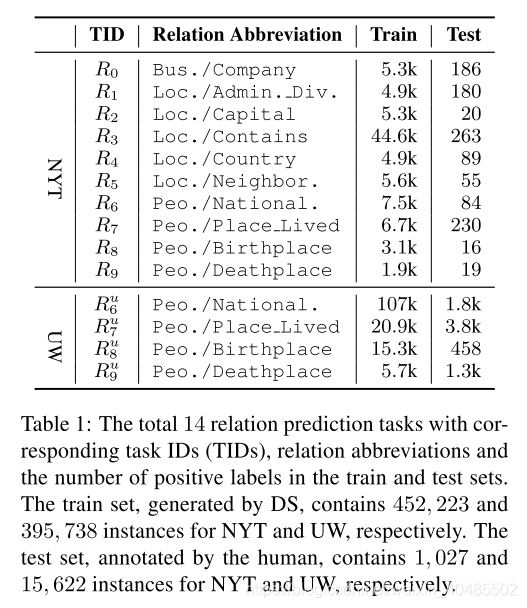

数据和任务。我们从NYT数据集(Riedel et al。,2010)3中选择了十个具有足够覆盖率(超过1,000个实例)的关系类型,并从UW数据集(Liu et al。,2016)4中选择所有四种关系类型。最初,NYT数据集包含一个训练集和一个测试集,它们都由DS分别使用522、611和172、448个实例生成; UW数据集包含由DS生成的火车集,带有人群注释的集和分别具有676、882、18、128和164个实例的最小人类注释测试集。为了实现基于人工注释的可靠评估,对于NYT数据集,我们从测试集中为每个关系(包括特殊的未知关系NA)随机选择了多达100个实例,并对其进行手动注释。而对于UW数据集,我们直接使用具有广泛覆盖范围和非常高质量的人群注释集(与火车集不相交)作为基本事实。表1总结了这14个任务的详细统计信息。

-

超参数

- pytorch

- LSTM(zhou,2016)

- agent网络

- lstm hidden size=200

- adam

- lr=0.001

- batch size=5

- epoch=10

- 模式提取阶段使用

- 加速:使用过滤后的实例(他预测概率高的前10000个)

- 模式优化:

- 对于每个任务只需要200个标注,并且WLF阶段最多可以有20个模式

- pytorch

-

数据集

- NYT

- UW

4.2 Performance Comparisons

- baseline

- 1)远程监督,Mintz等人描述的vanilla DS。 (2009),

- 2)Gold Label Mix(Liu等人,2016),

- 将带有人类注释的高质量标签与DS生成的噪声标签混合在一起

- 在模式优化阶段获得的200个标签与高质量标签相同

- 3)RLRE(Feng等人,2018)

- 对比试验

- 超参数一样

- 每种情况使用具有5个随机种子的NRE模型(范围从0到4)运行NRE模型,并给出平均分数。

基线。我们采用以下基准:1)远程监督,Mintz等人描述的香草DS。 (2009),2)Gold Label Mix(Liu等人,2016),将带有人类注释的高质量标签与DS生成的噪声标签混合在一起,以及3)RLRE(Feng等人,2018),构建实例选择代理进行选择通过仅与在噪声标签上训练的NRE模型进行交互来正确标记标签。具体来说,对于金标混合,我们使用在图案修饰阶段获得的200个标签与高质量标签相同。为了专注于使用不同方法生成的训练标签的影响,除了要使所有超参数完全相同之外,我们针对每种情况使用具有5个随机种子的NRE模型(范围从0到4)运行NRE模型,并给出平均分数。

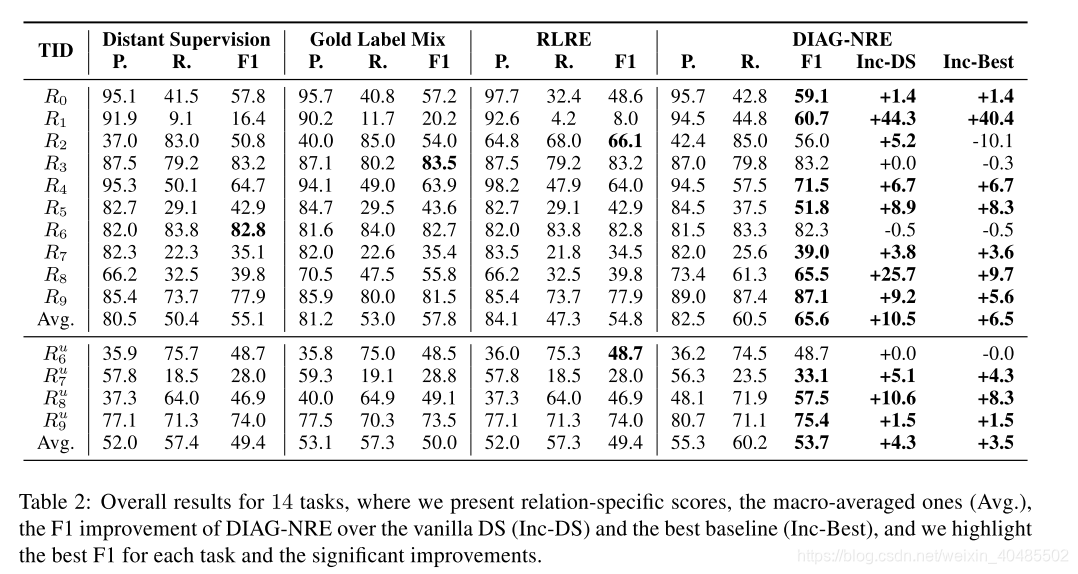

- 对比实验结果(提高性能方面)

- 在噪声大的数据集上使用DIAG-NRE提升大

- 在噪声小的任务上,也有一些小的改进

- 对于使用DS就足够了的任务,融合若标签会产生负面影响,但这个副作用小。

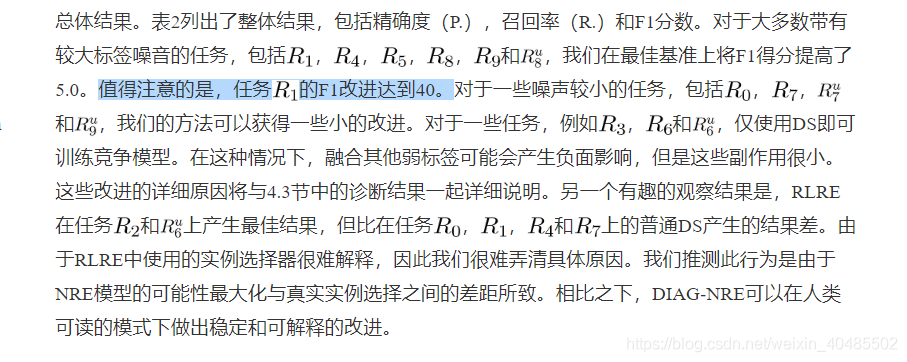

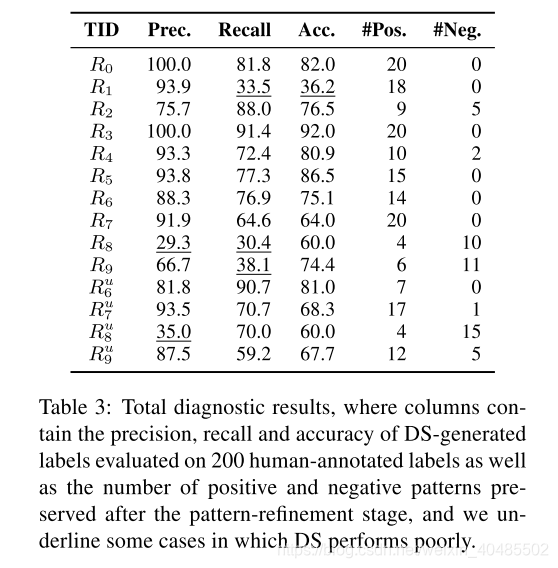

4.3 Pattern-based Diagnostic Results

除了提高提取性能外,DIAG-NRE还可以通过改进的模式来解释DS引起的不同噪声影响。接下来,我们从两个角度阐述这些诊断结果以及NRE模型的相应性能下降:假阴性(FN)和假阳性(FP)。

- 诊断效果

- 解释是FN还是FP造成的噪声影响

- FN

- R1,R8,R9

- 原因:语料中有,而KB中不存在此关系

- 精度高,召回率低

- 召回率低的问题引入了太多带有常见关系支持模式的否定实例,从而使NRE模型在捕获正确的特征时感到困惑。

- DIAG-NRE提升了其召回率

- 正模式可以修正FN错误

- FP:

- R8和

- 原因:不是所有的出现这两个实体对的句子都表现出他俩在KB中的关系

- 造成精度低:导致NRE模型吸收了一些不相关的模式

- –DIAG-NRE获得了负面模式–以此减少了FP,实现了精度的提高

- 负模式可以修正FP错误

FN。 FN的一个典型示例是任务R1(管理部门),其中DS生成的标签的精度相当好,但召回率却很低。根本原因是,存储在知识库中的关系事实几乎覆盖了语料库实际包含的真实事实。这个召回率较低的问题引入了太多带有常见关系支持模式的否定实例,从而使NRE模型在捕获正确的特征时感到困惑。此问题还解释了表2中的结果,即基于DS生成的数据训练的NRE模型实现了高精度,但召回率较低,而具有增强的正模式的DIAG-NRE由于具有更高的召回率,因此可以获得显着的改进。对于任务R8(出生地)和R9(死亡地),我们观察到类似的低召回率问题。

FP。 FP错误主要由引言中介绍的DS假设引起。例如,DS为任务和生成的标签的精度太低。这种低精度意味着DS生成的阳性标签的大部分没有指示目标关系。因此,此问题不可避免地导致NRE模型吸收一些不相关的模式。这种解释还对应于我们获得了一些负面模式的事实。通过通过负图减少带有FP错误的标签,DIAG-NRE可以实现较大的精度提高。

对于其他任务,DS生成的标签相对来说比较好,但是除任务(包含)R3外,噪声问题(主要还是次要)仍然存在,无论该问题是由DS自动生成的标签都非常准确。我们推测这种高质量标签的原因是,对于任务R3,DS假设与书面语言约定一致:当在一个句子中提到两个包含关系的位置时,人们习惯于明确声明该关系。

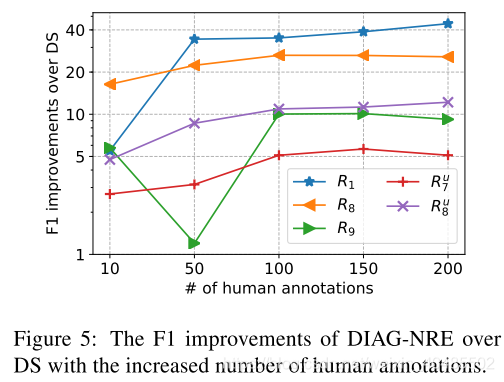

4.4 Incremental Diagnosis

- 人类标注对于DIAG-NRE的提升

- 大多是提升后饱和

- R9:在全自动下产生了个错误的实例,后在人类标注下修复了此错误

除了基于200个人类注释实例的性能比较之外,我们还通过将人类注释的数量从10个逐渐增加到200个,显示了DIAG-NRE的增量诊断能力。如图5所示,在我们选择那些遭受较大标签噪音的任务(来自纽约市的三个任务和来自威斯康星州的两个任务)的情况下,大多数任务在DIAG-NRE自动生成的高质量模式的帮助下经历了快速改进阶段,然后进入饱和状态阶段,其中添加注释的贡献不大。这种饱和度符合直觉,即高质量的关系模式通常受到限制。唯一的例外是任务R9,它先丢失然后又增加,原因是DIAG-NRE的全自动模式修饰意外地产生了一个错误模式,而后来的模式减轻了该错误。实际上,实际上,用户可以进一步管理DIAG-NRE生成的模式以获得更好的结果,这比从头开始编写模式要容易和快捷得多。

4.5案例研究

表4显示了来自三个任务的五个模式示例。对于任务R1,正模式可以纠正由DS引起的极低覆盖率。对于任务R8和R9,除了借助肯定模式以外,否定模式还可以纠正由DS引起的许多FP标签。这些案例直观地说明了DIAG-NRE诊断DS生成的标签并对其去噪的能力。

参考文献

References

Gabor Angeli, Julie Tibshirani, Jean Wu, and Christopher D Manning. 2014. Combining distant and partial supervision for relation extraction. In EMNLP.

Stephen H. Bach, Bryan He, Alexander Ratner, and Christopher R´e. 2017. Learning the structure of generative models withut labeled data. In ICML.

Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. 2015. Neural machine translation by jointly learning to align and translate. In ICLR.

Mary Elaine Califf and Raymond J. Mooney. 1999. Relational learning of pattern-match rules for information extraction. In AAAI.

Andrew Carlson, Justin Betteridge, Bryan Kisiel, Burr Settles, Estevam R Hruschka Jr, and Tom M Mitchell. 2010. Toward an architecture for neverending language learning. In AAAI.

Yubo Chen, Shulin Liu, Xiang Zhang, Kang Liu, and Jun Zhao. 2017. Automatically labeled data generation for large scale event extraction. In ACL.

Mark Craven, Johan Kumlien, et al. 1999. Constructing biological knowledge bases by extracting information from text sources. In ISMB.

Jun Feng, Minlie Huang, Li Zhao, Yang Yang, and Xiaoyan Zhu. 2018. Reinforcement learning for relation classification from noisy data. In AAAI.

Sepp Hochreiter and J¨urgen Schmidhuber. 1997. Long short-term memory. Neural computation.

Raphael Hoffmann, Congle Zhang, Xiao Ling, Luke Zettlemoyer, and Daniel S Weld. 2011. Knowledgebased weak supervision for information extraction of overlapping relations. In ACL.

Meng Jiang, Jingbo Shang, Taylor Cassidy, Xiang Ren, Lance M Kaplan, Timothy P Hanratty, and Jiawei Han. 2017. Metapad: meta pattern discovery from massive text corpora. In KDD.

Diederik P Kingma and Jimmy Ba. 2014. Adam: A method for stochastic optimization. arXiv preprint arXiv:1412.6980.

Jiwei Li, Will Monroe, and Dan Jurafsky. 2016. Understanding neural networks through representation erasure. arXiv preprint arXiv:1612.08220.

Yankai Lin, Haozhe Ji, Zhiyuan Liu, and Maosong Sun. 2018. Denoising distantly supervised open-domain question answering. In ACL.

Yankai Lin, Shiqi Shen, Zhiyuan Liu, Huanbo Luan, and Maosong Sun. 2016. Neural relation extraction with selective attention over instances. In ACL.

Angli Liu, Stephen Soderland, Jonathan Bragg, Christopher H Lin, Xiao Ling, and Daniel S Weld. 2016. Effective crowd annotation for relation extraction. In NAACL-HLT.

Liyuan Liu, Xiang Ren, Qi Zhu, Shi Zhi, Huan Gui, Heng Ji, and Jiawei Han. 2017a. Heterogeneous supervision for relation extraction: a representation learning approach. In EMNLP.

Tianyu Liu, Kexiang Wang, Baobao Chang, and Zhifang Sui. 2017b. A soft-label method for noisetolerant distantly supervised relation extraction. In EMNLP.

Bingfeng Luo, Yansong Feng, Zheng Wang, Zhanxing Zhu, Songfang Huang, Rui Yan, and Dongyan Zhao. 2017. Learning with noise: enhance distantly supervised relation extraction with dynamic transition matrix. In ACL.

Mike Mintz, Steven Bills, Rion Snow, and Dan Jurafsky. 2009. Distant supervision for relation extraction without labeled data. In ACL.

Ndapandula Nakashole, Gerhard Weikum, and Fabian Suchanek. 2012. Patty: a taxonomy of relational patterns with semantic types. In EMNLP.

Jeffrey Pennington, Richard Socher, and Christopher Manning. 2014. Glove: global vectors for word representation. In EMNLP.

Maria Pershina, Bonan Min, Wei Xu, and Ralph Grishman. 2014. Infusion of labeled data into distant

supervision for relation extraction. In ACL.

Pengda Qin, Weiran Xu, and William Yang Wang. 2018. Robust distant supervision relation extraction via deep reinforcement learning. In ACL.

Alexander J Ratner, Christopher M De Sa, Sen Wu, Daniel Selsam, and Christopher R´e. 2016. Data programming: creating large training sets, quickly. In NIPS.

Sebastian Riedel, Limin Yao, and Andrew McCallum. 2010. Modeling relations and their mentions without labeled text. In ECML.

David E Rumelhart, Geoffrey E Hinton, and Ronald J Williams. 1986. Learning representations by backpropagating errors. Nature.

Cicero dos Santos, Bing Xiang, and Bowen Zhou. 2015. Classifying relations by ranking with convolutional neural networks. In ACL.

Mihai Surdeanu, Julie Tibshirani, Ramesh Nallapati, and Christopher D Manning. 2012. Multi-instance multi-label learning for relation extraction. In EMNLP.

Richard S Sutton, David A McAllester, Satinder P Singh, and Yishay Mansour. 2000. Policy gradient methods for reinforcement learning with function approximation. In NIPS.

Shingo Takamatsu, Issei Sato, and Hiroshi Nakagawa. 2012. Reducing wrong labels in distant supervision for relation extraction. In ACL.

Paroma Varma, Bryan He, Dan Iter, Peng Xu, Rose Yu, Christopher De Sa, and Christopher R´e. 2016. Socratic learning: augmenting generative models to incorporate latent subsets in training data. arXiv preprint arXiv:1610.08123.

Ronald J Williams. 1992. Simple statistical gradientfollowing algorithms for connectionist reinforcement learning. Machine learning.

Yi Wu, David Bamman, and Stuart Russell. 2017. Adversarial training for relation extraction. In EMNLP.

Dmitry Zelenko, Chinatsu Aone, and Anthony Richardella. 2003. Kernel methods for relation extraction. JMLR.

Daojian Zeng, Kang Liu, Yubo Chen, and Jun Zhao. 2015. Distant supervision for relation extraction via piecewise convolutional neural networks. In EMNLP.

1428

Daojian Zeng, Kang Liu, Siwei Lai, Guangyou Zhou, Jun Zhao, et al. 2014. Relation classification via convolutional deep neural network. In COLING.

Ce Zhang, Feng Niu, Christopher R´e, and Jude Shavlik. 2012. Big data versus the crowd: looking for relationships in all the right places. In ACL.

Tianyang Zhang, Minlie Huang, and Li Zhao. 2018. Learning structured representation for text classification via reinforcement learning. In AAAI.

Guodong Zhou, Jian Su, Jie Zhang, and Min Zhang. 2005. Exploring various knowledge in relation extraction. In ACL.

Peng Zhou, Wei Shi, Jun Tian, Zhenyu Qi, Bingchen Li, Hongwei Hao, and Bo Xu. 2016. Attentionbased bidirectional long short-term memory networks for relation classification. In ACL.

如若内容造成侵权/违法违规/事实不符,请联系编程学习网邮箱:809451989@qq.com进行投诉反馈,一经查实,立即删除!

相关文章

- 宋词之美艳:《读宋词 学写作》作者姜越谈宋词

原标题:宋词之美艳:《读宋词 学写作》作者姜越谈宋词[导读] 自姜越老师的《读宋词 学写作》上市后受到读者喜爱,掀起了一波读宋词学宋词的小高潮,读者关注写作,也关注宋词。我们有幸请姜越老师书面回答一些读者感兴趣的问题,满满的干货。 记者:姜越老师您好!您的新作《…...

2024/4/17 4:23:17 - Kafka学习笔记

zk启动 bin/zkServer.sh start后台启动kafka bin/kafka-server-start.sh config/server.properties 1>/dev/null 2>&1 &测试生产者消费者 创建主题 bin/kafka-topics.sh --zookeeper localhost:2181 --create --topic calvin --partitions 2 --replication-facto…...

2024/5/1 5:44:55 - 湖边秋景

原标题:湖边秋景叶龢◎文 满湖的残荷,太阳从南到北,从高到低,斜射到湖面上,湖的北岸阳光灿烂,湖边上每间隔约二十米蹲坐着一个垂钓者,专注,纹丝不动,像是艺术学院学生的最新雕塑习作。 湖对岸的水底下汽车在倒立着行驶,虽然是晚秋,湖面上的垂柳依然摇曳着绿丝条。温…...

2024/4/14 16:14:39 - 阎连科:神实主义,对社会进行内部观察,在官方的灰色地带中徘徊

原标题:阎连科:神实主义,对社会进行内部观察,在官方的灰色地带中徘徊一、概要 阎连科,1958年出生于河南洛阳嵩县田湖瑶沟,毕业于河南大学、中国人民解放军艺术学院,中国著名作家,被誉为“荒诞现实主义大师”。现任中国人民大学文学院教授、香港科技大学高等研究院冼为…...

2024/5/1 12:58:25 - 设计模式概览——行为型模式

前面两篇文章分别整理了设计模式三大类中的创建型模式和结构型模式:设计模式概览——创建型模式 设计模式概览——结构型模式今天我们再来整理一下最后一部分,行为型模式。首先,什么是行为型模式?行为型模式(Behavioral Pattern)是指对在不同对象之间划分责任和算法进行抽象…...

2024/4/14 16:14:37 - 免费馅饼

Problem Description 都说天上不会掉馅饼,但有一天gameboy正走在回家的小径上,忽然天上掉下大把大把的馅饼。说来gameboy的人品实在是太好了,这馅饼别处都不掉,就掉落在他身旁的10米范围内。馅饼如果掉在了地上当然就不能吃了,所以gameboy马上卸下身上的背包去接。但由于小…...

2024/4/26 13:11:48 - 如果小玲还活着,她一定还认得我……

原标题:如果小玲还活着,她一定还认得我……小玲 叶龢◎著 小玲如果还活着,现在应该是我这个年纪,她学习那么认真,成绩那么好,后来应该考上了大学吧,离开了荷叶村,离开了资水镇,或到省城,或到外地,甚至到北京去上大学了。如果我们后来在哪儿遇见,比如在王府井大街,…...

2024/5/1 9:40:36 - SSM单元测试报空指针

ssm单元测试报空指针解决 1.数据库数据为空,没有判断 2.数据库有数据,配置文件也正常如下面: 调试时候一直报空指针,查看了配置文件还有web.xml都是正确的,最后才发现忘记了加@RunWith(SpringJUnit4ClassRunner.class) @ContextConfiguration(locations =“classpath:appl…...

2024/5/1 7:52:43 - 《如何吸引顶尖人才》关于企业中的四种人:人物、人才、人手、人渣

原标题:《如何吸引顶尖人才》关于企业中的四种人:人物、人才、人手、人渣林海涛◎文 《如何吸引顶尖人才:最怕竞争对手看到的一本书》,林海涛/著,中国商业出版社2019年8月第1版,定价:68.00元。 这个世界上,有的人可以一天赚一百元,有的人可以一天赚一千元,也有的人…...

2024/5/1 10:27:44 - 后知后觉的信息收集重要性

信息收集 当我意识到信息收集对于渗透测试的重要性的时候,听了一节课 才为自己来整理一下思路,也能可以让我自己发现这么重要的一步我遗漏了什么,每次我对信息收集的新认识会来补充整理的。 分类: * 主动信息收集 * 被动信息收集漏洞挖掘 当我们做web渗透的时候,首先确定…...

2024/4/14 16:14:32 - 《如何吸引顶尖人才》作者林海涛签售会在北京举行

原标题:《如何吸引顶尖人才》作者林海涛签售会在北京举行经管励志图书《如何吸引顶尖人才:最怕竞争对手看到的一本书》近日由中国商业出版社出版,并在全国发行,新书首发式和该书作者林海涛签售会于2019年11月17日在北京图书大厦举行。 《如何吸引顶尖人才》是一部非常实用…...

2024/4/14 16:14:31 - 测试!

下标和指针的关系 先来一段代码: #include<stdio.h> void f(int* j,int len) {int i;for(i=0;i<len;++i)printf("%d ",j[i]); printf("\n"); } int main() {int a[6]={1,2,-3,99,5,6};f(a,6);return 0;} 如果p是个指针变量,则 则p[i] 永远等于…...

2024/4/14 16:14:30 - 哥们儿兄弟的故事多如牛毛,一千零一夜也讲不完

原标题:哥们儿兄弟的故事多如牛毛,一千零一夜也讲不完哥们儿兄弟 叶龢◎作品 (一) 先说说前几天的事儿吧。 前几天一哥们儿兄弟问我: “看了你的文章,怎么觉得你朋友圈全是些不正经的人呢?” 我告诉他: “我朋友圈大部分都是正经的人,你不觉得我在写正经人的不…...

2024/4/27 1:17:13 - msf之使用震网三代来提权

cve_2017_8464_lnk_lpe,他就是震网三代的exploit 上次没有成功将x64的搞定,现在搬来了震网三代 看我来个远程执行漏洞的提权 前面已经拿到shell,但没有system权限我也是稍微找了以下exploit,真是大海捞针偶然发现 use exploit/windows/local/cve_2017_8464_lnk_lpe设置好se…...

2024/4/25 20:13:55 - 《如何吸引顶尖人才》作者林海涛的创业故事

原标题:《如何吸引顶尖人才》作者林海涛的创业故事《如何吸引顶尖人才:最怕竞争对手看到的一本书》,林海涛/著,中国商业出版社2019年8月第1版 林海涛/文 曾经我是一名被学校开除过的学生; 曾经我是一名踩三轮车送菜的送货员; 曾经我是一个创业破产过六次,把所有资产…...

2024/4/20 6:42:05 - Redis学习笔记---Redis Cluster集群(二)

前言 在Redis Cluster集群 (一) 中了解了集群的相关概念,这一节我们将了解集群平台的搭建。 1. 简介 集群中至少应该有奇数个节点,所以搭建集群最少需要3台主机,同时每个节点至少有一个备份节点,所以下面最少要创建6台机器,才能完成Redis Cluster 集群(主节点,备份节点由…...

2024/4/16 14:31:54 - 对话作家齐一民:《小民杂艺秀》及其它“小民系列”

原标题:对话作家齐一民:《小民杂艺秀》及其它“小民系列”[摘要] 我的名字中有一个“民”字,因此以“小民”的名义说故事。 “小民”也是平民百姓的代称,平头百姓看问题角度低,望天,朝上看,因此,反而看得清清楚楚。我盘算着制作“小民系列”的“五六胞胎”——五六部集…...

2024/4/21 4:39:24 - 一个陌生男人的来电

原标题:一个陌生男人的来电一个陌生人的来电:《南方来电》演绎版 叶和/文 固定电话一年多没有动静了,今天晚上突然响了。我拿起电话,电话那头是南方沿海一带男人口音。 电话那头:“老弟,最近还好吧?” 我说:“挺好的!” 电话那头:“弟妺和孩子都好吧?” 我说:…...

2024/4/26 8:01:25 - 斑斓生命,不朽时光

原标题:斑斓生命,不朽时光斑斓生命,不朽时光——读齐一民老师《雕刻不朽时光》系列有感 任玲◎文 俗务缠身,久不执笔评书矣。 然而遇到好书,仍旧情不自禁要读、要品、要细细咂摸、反复玩味,这大抵是自诩文人的我,灵魂深处的本能罢。 上一本读得感慨万分的书,还是村上…...

2024/4/18 17:22:08 - 2019年十大管理图书

原标题:2019年十大管理图书2019年世界经济环境动荡不安,世界经济格局处于剧烈的调整中,贸易战此起彼伏,未来不确定性在加剧,新技术、新业态、新的商业思维和模式层出不穷。企业既要应对外部环境的变化,又要面对企业内部管理的更新和升级。总之,企业处于前所未有的未知和…...

2024/4/29 17:30:22

最新文章

- 学习mysql相关知识记录

执行一条select语句,期间发生了什么? MySQL的执行流程: 连接器 TCP连接 查询缓存 很鸡肋被取消 解析SQL 解析器 语法分析词法分析 执行SQL 预处理器 检查是否存在将 select * 中的 * 符号,扩展为表上的所有列 优化器 优化器主要…...

2024/5/1 13:01:02 - 梯度消失和梯度爆炸的一些处理方法

在这里是记录一下梯度消失或梯度爆炸的一些处理技巧。全当学习总结了如有错误还请留言,在此感激不尽。 权重和梯度的更新公式如下: w w − η ⋅ ∇ w w w - \eta \cdot \nabla w ww−η⋅∇w 个人通俗的理解梯度消失就是网络模型在反向求导的时候出…...

2024/3/20 10:50:27 - Topaz Video AI for Mac v5.0.0激活版 视频画质增强软件

Topaz Video AI for Mac是一款功能强大的视频处理软件,专为Mac用户设计,旨在通过人工智能技术为视频编辑和增强提供卓越的功能。这款软件利用先进的算法和深度学习技术,能够自动识别和分析视频中的各个元素,并进行智能修复和增强&…...

2024/4/30 4:45:36 - C#-实现软删除

文章目录 前言1. 使用布尔字段标记删除状态2. 修改查询以忽略软删除的记录3. 实现软删除的方法4. 考虑使用全局查询过滤器5. 处理关联实体6. 考虑性能和存储软删除的好处:软删除的坏处: 总结 前言 后端中,经常使用软删除来标志删除一些数据。…...

2024/4/30 1:36:16 - 【外汇早评】美通胀数据走低,美元调整

原标题:【外汇早评】美通胀数据走低,美元调整昨日美国方面公布了新一期的核心PCE物价指数数据,同比增长1.6%,低于前值和预期值的1.7%,距离美联储的通胀目标2%继续走低,通胀压力较低,且此前美国一季度GDP初值中的消费部分下滑明显,因此市场对美联储后续更可能降息的政策…...

2024/4/29 23:16:47 - 【原油贵金属周评】原油多头拥挤,价格调整

原标题:【原油贵金属周评】原油多头拥挤,价格调整本周国际劳动节,我们喜迎四天假期,但是整个金融市场确实流动性充沛,大事频发,各个商品波动剧烈。美国方面,在本周四凌晨公布5月份的利率决议和新闻发布会,维持联邦基金利率在2.25%-2.50%不变,符合市场预期。同时美联储…...

2024/4/30 18:14:14 - 【外汇周评】靓丽非农不及疲软通胀影响

原标题:【外汇周评】靓丽非农不及疲软通胀影响在刚结束的周五,美国方面公布了新一期的非农就业数据,大幅好于前值和预期,新增就业重新回到20万以上。具体数据: 美国4月非农就业人口变动 26.3万人,预期 19万人,前值 19.6万人。 美国4月失业率 3.6%,预期 3.8%,前值 3…...

2024/4/29 2:29:43 - 【原油贵金属早评】库存继续增加,油价收跌

原标题:【原油贵金属早评】库存继续增加,油价收跌周三清晨公布美国当周API原油库存数据,上周原油库存增加281万桶至4.692亿桶,增幅超过预期的74.4万桶。且有消息人士称,沙特阿美据悉将于6月向亚洲炼油厂额外出售更多原油,印度炼油商预计将每日获得至多20万桶的额外原油供…...

2024/4/30 18:21:48 - 【外汇早评】日本央行会议纪要不改日元强势

原标题:【外汇早评】日本央行会议纪要不改日元强势近两日日元大幅走强与近期市场风险情绪上升,避险资金回流日元有关,也与前一段时间的美日贸易谈判给日本缓冲期,日本方面对汇率问题也避免继续贬值有关。虽然今日早间日本央行公布的利率会议纪要仍然是支持宽松政策,但这符…...

2024/4/27 17:58:04 - 【原油贵金属早评】欧佩克稳定市场,填补伊朗问题的影响

原标题:【原油贵金属早评】欧佩克稳定市场,填补伊朗问题的影响近日伊朗局势升温,导致市场担忧影响原油供给,油价试图反弹。此时OPEC表态稳定市场。据消息人士透露,沙特6月石油出口料将低于700万桶/日,沙特已经收到石油消费国提出的6月份扩大出口的“适度要求”,沙特将满…...

2024/4/27 14:22:49 - 【外汇早评】美欲与伊朗重谈协议

原标题:【外汇早评】美欲与伊朗重谈协议美国对伊朗的制裁遭到伊朗的抗议,昨日伊朗方面提出将部分退出伊核协议。而此行为又遭到欧洲方面对伊朗的谴责和警告,伊朗外长昨日回应称,欧洲国家履行它们的义务,伊核协议就能保证存续。据传闻伊朗的导弹已经对准了以色列和美国的航…...

2024/4/28 1:28:33 - 【原油贵金属早评】波动率飙升,市场情绪动荡

原标题:【原油贵金属早评】波动率飙升,市场情绪动荡因中美贸易谈判不安情绪影响,金融市场各资产品种出现明显的波动。随着美国与中方开启第十一轮谈判之际,美国按照既定计划向中国2000亿商品征收25%的关税,市场情绪有所平复,已经开始接受这一事实。虽然波动率-恐慌指数VI…...

2024/4/30 9:43:09 - 【原油贵金属周评】伊朗局势升温,黄金多头跃跃欲试

原标题:【原油贵金属周评】伊朗局势升温,黄金多头跃跃欲试美国和伊朗的局势继续升温,市场风险情绪上升,避险黄金有向上突破阻力的迹象。原油方面稍显平稳,近期美国和OPEC加大供给及市场需求回落的影响,伊朗局势并未推升油价走强。近期中美贸易谈判摩擦再度升级,美国对中…...

2024/4/27 17:59:30 - 【原油贵金属早评】市场情绪继续恶化,黄金上破

原标题:【原油贵金属早评】市场情绪继续恶化,黄金上破周初中国针对于美国加征关税的进行的反制措施引发市场情绪的大幅波动,人民币汇率出现大幅的贬值动能,金融市场受到非常明显的冲击。尤其是波动率起来之后,对于股市的表现尤其不安。隔夜美国股市出现明显的下行走势,这…...

2024/4/25 18:39:16 - 【外汇早评】美伊僵持,风险情绪继续升温

原标题:【外汇早评】美伊僵持,风险情绪继续升温昨日沙特两艘油轮再次发生爆炸事件,导致波斯湾局势进一步恶化,市场担忧美伊可能会出现摩擦生火,避险品种获得支撑,黄金和日元大幅走强。美指受中美贸易问题影响而在低位震荡。继5月12日,四艘商船在阿联酋领海附近的阿曼湾、…...

2024/4/28 1:34:08 - 【原油贵金属早评】贸易冲突导致需求低迷,油价弱势

原标题:【原油贵金属早评】贸易冲突导致需求低迷,油价弱势近日虽然伊朗局势升温,中东地区几起油船被袭击事件影响,但油价并未走高,而是出于调整结构中。由于市场预期局势失控的可能性较低,而中美贸易问题导致的全球经济衰退风险更大,需求会持续低迷,因此油价调整压力较…...

2024/4/26 19:03:37 - 氧生福地 玩美北湖(上)——为时光守候两千年

原标题:氧生福地 玩美北湖(上)——为时光守候两千年一次说走就走的旅行,只有一张高铁票的距离~ 所以,湖南郴州,我来了~ 从广州南站出发,一个半小时就到达郴州西站了。在动车上,同时改票的南风兄和我居然被分到了一个车厢,所以一路非常愉快地聊了过来。 挺好,最起…...

2024/4/29 20:46:55 - 氧生福地 玩美北湖(中)——永春梯田里的美与鲜

原标题:氧生福地 玩美北湖(中)——永春梯田里的美与鲜一觉醒来,因为大家太爱“美”照,在柳毅山庄去寻找龙女而错过了早餐时间。近十点,向导坏坏还是带着饥肠辘辘的我们去吃郴州最富有盛名的“鱼头粉”。说这是“十二分推荐”,到郴州必吃的美食之一。 哇塞!那个味美香甜…...

2024/4/30 22:21:04 - 氧生福地 玩美北湖(下)——奔跑吧骚年!

原标题:氧生福地 玩美北湖(下)——奔跑吧骚年!让我们红尘做伴 活得潇潇洒洒 策马奔腾共享人世繁华 对酒当歌唱出心中喜悦 轰轰烈烈把握青春年华 让我们红尘做伴 活得潇潇洒洒 策马奔腾共享人世繁华 对酒当歌唱出心中喜悦 轰轰烈烈把握青春年华 啊……啊……啊 两…...

2024/5/1 4:32:01 - 扒开伪装医用面膜,翻六倍价格宰客,小姐姐注意了!

原标题:扒开伪装医用面膜,翻六倍价格宰客,小姐姐注意了!扒开伪装医用面膜,翻六倍价格宰客!当行业里的某一品项火爆了,就会有很多商家蹭热度,装逼忽悠,最近火爆朋友圈的医用面膜,被沾上了污点,到底怎么回事呢? “比普通面膜安全、效果好!痘痘、痘印、敏感肌都能用…...

2024/4/27 23:24:42 - 「发现」铁皮石斛仙草之神奇功效用于医用面膜

原标题:「发现」铁皮石斛仙草之神奇功效用于医用面膜丽彦妆铁皮石斛医用面膜|石斛多糖无菌修护补水贴19大优势: 1、铁皮石斛:自唐宋以来,一直被列为皇室贡品,铁皮石斛生于海拔1600米的悬崖峭壁之上,繁殖力差,产量极低,所以古代仅供皇室、贵族享用 2、铁皮石斛自古民间…...

2024/4/28 5:48:52 - 丽彦妆\医用面膜\冷敷贴轻奢医学护肤引导者

原标题:丽彦妆\医用面膜\冷敷贴轻奢医学护肤引导者【公司简介】 广州华彬企业隶属香港华彬集团有限公司,专注美业21年,其旗下品牌: 「圣茵美」私密荷尔蒙抗衰,产后修复 「圣仪轩」私密荷尔蒙抗衰,产后修复 「花茵莳」私密荷尔蒙抗衰,产后修复 「丽彦妆」专注医学护…...

2024/4/30 9:42:22 - 广州械字号面膜生产厂家OEM/ODM4项须知!

原标题:广州械字号面膜生产厂家OEM/ODM4项须知!广州械字号面膜生产厂家OEM/ODM流程及注意事项解读: 械字号医用面膜,其实在我国并没有严格的定义,通常我们说的医美面膜指的应该是一种「医用敷料」,也就是说,医用面膜其实算作「医疗器械」的一种,又称「医用冷敷贴」。 …...

2024/4/30 9:43:22 - 械字号医用眼膜缓解用眼过度到底有无作用?

原标题:械字号医用眼膜缓解用眼过度到底有无作用?医用眼膜/械字号眼膜/医用冷敷眼贴 凝胶层为亲水高分子材料,含70%以上的水分。体表皮肤温度传导到本产品的凝胶层,热量被凝胶内水分子吸收,通过水分的蒸发带走大量的热量,可迅速地降低体表皮肤局部温度,减轻局部皮肤的灼…...

2024/4/30 9:42:49 - 配置失败还原请勿关闭计算机,电脑开机屏幕上面显示,配置失败还原更改 请勿关闭计算机 开不了机 这个问题怎么办...

解析如下:1、长按电脑电源键直至关机,然后再按一次电源健重启电脑,按F8健进入安全模式2、安全模式下进入Windows系统桌面后,按住“winR”打开运行窗口,输入“services.msc”打开服务设置3、在服务界面,选中…...

2022/11/19 21:17:18 - 错误使用 reshape要执行 RESHAPE,请勿更改元素数目。

%读入6幅图像(每一幅图像的大小是564*564) f1 imread(WashingtonDC_Band1_564.tif); subplot(3,2,1),imshow(f1); f2 imread(WashingtonDC_Band2_564.tif); subplot(3,2,2),imshow(f2); f3 imread(WashingtonDC_Band3_564.tif); subplot(3,2,3),imsho…...

2022/11/19 21:17:16 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机...

win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”问题的解决方法在win7系统关机时如果有升级系统的或者其他需要会直接进入一个 等待界面,在等待界面中我们需要等待操作结束才能关机,虽然这比较麻烦,但是对系统进行配置和升级…...

2022/11/19 21:17:15 - 台式电脑显示配置100%请勿关闭计算机,“准备配置windows 请勿关闭计算机”的解决方法...

有不少用户在重装Win7系统或更新系统后会遇到“准备配置windows,请勿关闭计算机”的提示,要过很久才能进入系统,有的用户甚至几个小时也无法进入,下面就教大家这个问题的解决方法。第一种方法:我们首先在左下角的“开始…...

2022/11/19 21:17:14 - win7 正在配置 请勿关闭计算机,怎么办Win7开机显示正在配置Windows Update请勿关机...

置信有很多用户都跟小编一样遇到过这样的问题,电脑时发现开机屏幕显现“正在配置Windows Update,请勿关机”(如下图所示),而且还需求等大约5分钟才干进入系统。这是怎样回事呢?一切都是正常操作的,为什么开时机呈现“正…...

2022/11/19 21:17:13 - 准备配置windows 请勿关闭计算机 蓝屏,Win7开机总是出现提示“配置Windows请勿关机”...

Win7系统开机启动时总是出现“配置Windows请勿关机”的提示,没过几秒后电脑自动重启,每次开机都这样无法进入系统,此时碰到这种现象的用户就可以使用以下5种方法解决问题。方法一:开机按下F8,在出现的Windows高级启动选…...

2022/11/19 21:17:12 - 准备windows请勿关闭计算机要多久,windows10系统提示正在准备windows请勿关闭计算机怎么办...

有不少windows10系统用户反映说碰到这样一个情况,就是电脑提示正在准备windows请勿关闭计算机,碰到这样的问题该怎么解决呢,现在小编就给大家分享一下windows10系统提示正在准备windows请勿关闭计算机的具体第一种方法:1、2、依次…...

2022/11/19 21:17:11 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”的解决方法...

今天和大家分享一下win7系统重装了Win7旗舰版系统后,每次关机的时候桌面上都会显示一个“配置Windows Update的界面,提示请勿关闭计算机”,每次停留好几分钟才能正常关机,导致什么情况引起的呢?出现配置Windows Update…...

2022/11/19 21:17:10 - 电脑桌面一直是清理请关闭计算机,windows7一直卡在清理 请勿关闭计算机-win7清理请勿关机,win7配置更新35%不动...

只能是等着,别无他法。说是卡着如果你看硬盘灯应该在读写。如果从 Win 10 无法正常回滚,只能是考虑备份数据后重装系统了。解决来方案一:管理员运行cmd:net stop WuAuServcd %windir%ren SoftwareDistribution SDoldnet start WuA…...

2022/11/19 21:17:09 - 计算机配置更新不起,电脑提示“配置Windows Update请勿关闭计算机”怎么办?

原标题:电脑提示“配置Windows Update请勿关闭计算机”怎么办?win7系统中在开机与关闭的时候总是显示“配置windows update请勿关闭计算机”相信有不少朋友都曾遇到过一次两次还能忍但经常遇到就叫人感到心烦了遇到这种问题怎么办呢?一般的方…...

2022/11/19 21:17:08 - 计算机正在配置无法关机,关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机...

关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!关机提示 windows7 正在配…...

2022/11/19 21:17:05 - 钉钉提示请勿通过开发者调试模式_钉钉请勿通过开发者调试模式是真的吗好不好用...

钉钉请勿通过开发者调试模式是真的吗好不好用 更新时间:2020-04-20 22:24:19 浏览次数:729次 区域: 南阳 > 卧龙 列举网提醒您:为保障您的权益,请不要提前支付任何费用! 虚拟位置外设器!!轨迹模拟&虚拟位置外设神器 专业用于:钉钉,外勤365,红圈通,企业微信和…...

2022/11/19 21:17:05 - 配置失败还原请勿关闭计算机怎么办,win7系统出现“配置windows update失败 还原更改 请勿关闭计算机”,长时间没反应,无法进入系统的解决方案...

前几天班里有位学生电脑(windows 7系统)出问题了,具体表现是开机时一直停留在“配置windows update失败 还原更改 请勿关闭计算机”这个界面,长时间没反应,无法进入系统。这个问题原来帮其他同学也解决过,网上搜了不少资料&#x…...

2022/11/19 21:17:04 - 一个电脑无法关闭计算机你应该怎么办,电脑显示“清理请勿关闭计算机”怎么办?...

本文为你提供了3个有效解决电脑显示“清理请勿关闭计算机”问题的方法,并在最后教给你1种保护系统安全的好方法,一起来看看!电脑出现“清理请勿关闭计算机”在Windows 7(SP1)和Windows Server 2008 R2 SP1中,添加了1个新功能在“磁…...

2022/11/19 21:17:03 - 请勿关闭计算机还原更改要多久,电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机怎么办...

许多用户在长期不使用电脑的时候,开启电脑发现电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机。。.这要怎么办呢?下面小编就带着大家一起看看吧!如果能够正常进入系统,建议您暂时移…...

2022/11/19 21:17:02 - 还原更改请勿关闭计算机 要多久,配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以...

配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!配置windows update失败 还原更改 请勿关闭计算机&#x…...

2022/11/19 21:17:01 - 电脑配置中请勿关闭计算机怎么办,准备配置windows请勿关闭计算机一直显示怎么办【图解】...

不知道大家有没有遇到过这样的一个问题,就是我们的win7系统在关机的时候,总是喜欢显示“准备配置windows,请勿关机”这样的一个页面,没有什么大碍,但是如果一直等着的话就要两个小时甚至更久都关不了机,非常…...

2022/11/19 21:17:00 - 正在准备配置请勿关闭计算机,正在准备配置windows请勿关闭计算机时间长了解决教程...

当电脑出现正在准备配置windows请勿关闭计算机时,一般是您正对windows进行升级,但是这个要是长时间没有反应,我们不能再傻等下去了。可能是电脑出了别的问题了,来看看教程的说法。正在准备配置windows请勿关闭计算机时间长了方法一…...

2022/11/19 21:16:59 - 配置失败还原请勿关闭计算机,配置Windows Update失败,还原更改请勿关闭计算机...

我们使用电脑的过程中有时会遇到这种情况,当我们打开电脑之后,发现一直停留在一个界面:“配置Windows Update失败,还原更改请勿关闭计算机”,等了许久还是无法进入系统。如果我们遇到此类问题应该如何解决呢࿰…...

2022/11/19 21:16:58 - 如何在iPhone上关闭“请勿打扰”

Apple’s “Do Not Disturb While Driving” is a potentially lifesaving iPhone feature, but it doesn’t always turn on automatically at the appropriate time. For example, you might be a passenger in a moving car, but your iPhone may think you’re the one dri…...

2022/11/19 21:16:57