杂七杂八知识点的摸索

文章目录

- 一、tcp/ip协议栈

- 1.1 OSI七层模型

- 1.2 TCP timewait太多是什么原因

- 1.3 TCP建立详细过程和UDP区别

- 1.4 介绍一下tcp包头有什么内容

- 1.5 TCP 三次丢包了怎么办,过多久重传

- 1.6 TCP 4次为什么要4次关闭

- 1.7 TCP 4次关闭服务端先关闭好还是客户端先关闭好

- 1.8 TCP UDP 区别分别用在那?举例说出应用到 TCP UDP 的协议

- 1.9 TCP 如何实现可靠传输的?——超时重传+确认机制

- 1.10 TCP滑动窗口什么情况下会变化,怎么变

- 1.11 HTTP协议与TCP协议的关系

- 1.12 HTTP和HTTPS的区别

- 1.13 介绍HTTPS加密原理

- 1.14 如何加快TCP socket连接的回收

- 二、网络相关

- 2.1 五层模型

- 2.2 TCP三次握手四次挥手

- 2.3 TCP和UDP区别

- 2.4 路由器和交换机区别

- 2.5 交换机性能优化

- 2.6 四次挥手为什么有timewait

- 2.7 HTTP协议

- 2.8 交换机与路由器的区别,各自的应用场景

- 三、操作系统原理

- 3.1 硬盘接口类型

- 3.1.1 IDE

- 3.1.2 SATA

- 3.1.3 SCSI

- 3.1.4 SAS

- 3.2 中断机制

- 3.2.1 中断类型

- 3.2.2 中断数据处理结构

- 3.2.3 Linux中断机制

- 3.3 进程和线程的关系,父进程和子进程的关系

- 3.4 线程和进程的区别

- 四、linux基础知识

- 4.1 tr命令和sar命令

- 4.2 管道符和重定向的区别

- 4.3 cache和buffer区别

- 4.4 Linux怎么设置开机自启动某个脚本

- 4.4.1 第一种 chkconfig管理

- 4.4.2 第二种 修改/etc/rc.local

- 4.5 kill和kill-9区别

- 4.6 写一个脚本来判断文件是否存在

- 4.7 ping一个地址的实现过程,协议

- 4.8 用脚本实现最简单的两个数相除(精确到小数点后四位)

- 4.9 权限体系,755,一些特殊文件为什么是600.400

- 4.10 查看内存的命令,内存占用最大的进程,怎么看这个进程调用了哪些文件,以及查看核数

- 4.10.1 查看内存的命令

- 4.10.2 内存占用最大的进程

- 4.10.3 看这个进程调用了哪些文件

- 4.10.4 查看核数

- 4.11 tcpdump指定源端口,过滤8000-9000端口

- 4.12 几种下载安装的步骤,报错有哪些情况,怎么解决

- 4.12.1 yum安装

- 4.12.2 编译安装

- 4.12.3 二进制安装

- 4.12.4 三种安装方法优缺点比较

- 4.12.5 常见错误

- 4.13 iptables的操作,过滤一个IP,与firewall的区别,了解ipset

- 4.13.1 iptables过滤一个IP

- 4.13.2 查看output策略

- 4.13.3 建立自定义链

- 4.13.4 清理防火墙选项

- 4.13.5 7以上防火墙命令

- 4.13.6 iptables与firewall的区别

- 4.13.7 ipset

- 4.14 查看网卡信息,MTU与MSS的区别

- 4.14.1 查看网卡信息

- 4.14.2 MTU

- 4.14.3 MSS

- 4.14.4 MTU和MSS的区别

- 4.15 cpu的使用率是怎样计算的,120%是什么意思,一个什么样的进程能让他达到200%

- 4.16 查看系统io状态,iostat里面的io百分比是怎么算的

- 4.16.1 查看系统io状态

- 4.16.2 iostat里面的io百分比

- 4.17 运行一个shell脚本怎样调试,怎样看到执行的整个过程,中间有一句错了后面还会不会执行,怎样解决

- 4.17.1 脚本调试

- 4.17.2 调试器bashdb

- 4.18 free

- 4.18.1 free

- 4.18.2 /proc/meminfo 文件

- 4.19 一个脚本重定向到另一个文件,另一个文件却是空的是怎么回事(排除权限问题)

- 4.20 shell重定向有几种方式,标准错误输出,一条命令不要他的输出与标准错误输出怎么做

- 4.20.1 shell重定向

- 4.20.2 >/dev/null 2>&1 和 2>&1 >/dev/null区别

- 4.21 top显示内容,第一行最后三个的含义,负载是什么意思,为什么不能超过核心数,是什么原理

- 4.22 查看磁盘读写的MB用什么参数,查看tps用什么参数

- 4.23 linux socket建立和关闭的原理

- 4.24 如何知道系统block大小

- 4.25 proc伪文件系统

- 4.26 LVM逻辑卷

- 4.26.1 逻辑卷优点

- 4.26.2 创建逻辑卷过程

- 4.26.3 扩大缩小逻辑卷/卷组

- 4.26.4 备份逻辑卷

- 4.26.5 /扩容的方法

- 4.27 MBR的作用

- 4.28 /var/log目录下有什么,日志分别是哪些服务的,日志里面的内容是什么

- 4.28.1 /var/log/目录

- 4.28.2 日志有哪些服务

- 4.28.3 日志里面的内容

- 4.29 文件系统中文件查找快的原因

- 4.29.1 查找文件

- 4.29.2 查找快的原因(可以从最底层的磁盘讲起)

- 4.30 raid0与raid1的区别,raid5一块盘坏了会怎么办,具体原理

- 4.30.1 raid0与raid1的区别

- 4.30.2 raid5一块盘坏,怎么处理

- 4.30.3 软raid

- 4.31 一条定时任务没有执行,有几种可能的原因

- 4.32 网卡的配置文件在哪里

- 4.33 怎样查看占用80端口的进程

- 4.34 怎样查看系统的性能

- 4.35 怎样看磁盘的io

- 4.36 awk怎样把最后一列拎出来

- 4.37 介绍一个w,uptime,iostat,top,ps

- 4.38 ab web服务器性能测试

- 4.39 查看某服务是否打开

- 4.40 一次性关闭某服务的所有进程

- 4.41 查看进程的命令

- 4.42 Linux杀死僵尸进程

- 4.43 文本处理/替换

- 4.43.1 awk文本处理

- 4.43.2 sed文本替换

- 4.43.3 用多种方法获取一个特殊字段并计数

- 4.44 系统启动流程

- 4.44.1 加电检查了那些外围设备,检查的顺序

- 4.44.2 bios存在的意义

- 4.44.3 /boot分区的内容

- 4.44.4 如何找到grub

- 4.44.5 grub和grub2的区别

- 4.44.6 initramfs文件的作用

- 4.44.7 grub的各个阶段功能

- 4.44.8 内核是什么,功能,如何修改内核参数

- 4.45 linux如何获取对方的arp(arping)

- 4.46 linux绑定双网卡,数据怎么走

- 4.47 文件权限linux 发行版本

- 4.47.1 文件权限

- 4.47.2 发行版本

- 4.48 常见的http状态码

- 4.49 netstat常见的选项

- 4.50 维护一个系统的安全有哪几方面

- 4.51 linux常用的分区格式

- 4.52 PYTHON

- 4.52.1 python的内存回收机制

- 4.52.2 python中+=

- 4.52.3 元组与列表的区别

- 4.52.4 python中有哪些复制的方式

- 4.52.5 Django的模块使用情况

- 4.52.6 Python和shell的区别

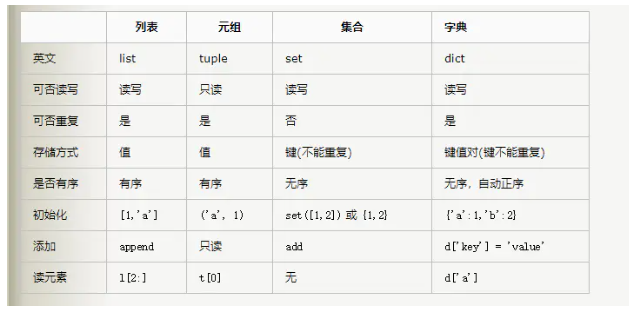

- 4.52.7 python的常见数据类型

- 五、数据库知识

- 5.1 部署数据库的整一个流程

- 5.1.1 安装

- 5.1.2 部署多实例

- 5.1.3 主从复制

- 5.2 数据库大数据类型

- 5.3 数据库存储引擎

- 5.4 索引

- 5.5 SQL查询语句的优化

- 5.6 数据库触发器

- 5.7 当创建好一个数据库,都生成了哪些文件,这些文件的本质是什么

- 5.8 MySQL主从不一致出现报错要怎么解决,简历主从的命令是什么

- 5.8.1 slave运行过慢不能与master同步,也就是MySQL数据库主从同步延迟

- 5.8.2 slave同步状态中出现Slave_IO_Running: NO

- 5.8.3 slave同步状态中出现Slave_IO_Running: Connecting

- 5.8.4 slave中继日志relay-log损坏

- 5.8.5 slave连接超时且重新连接频繁

- 5.8.6 在master更新一条记录,而slave却找不到

- 5.8.7 mysql主从同步(跨机房情况)不一致问题

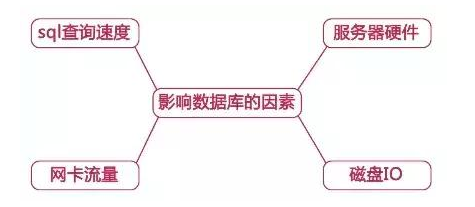

- 5.9 查看Mysql发现查询特别慢,可能的原因,对于慢查询,你的分析思路

- 5.9.1 查询速度慢的原因

- 5.9.2 查询优化

- 5.9.3 查看

- 六、服务器知识

- 6.1 Docker的原理

- 6.2 CDN

- 6.2.1 CDN概念

- 6.2.2 CDN架构

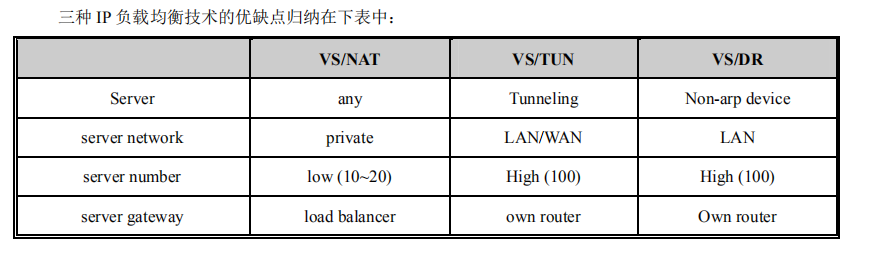

- 6.3 LVS(Linux Virtual Server)

- 6.3.1 lvs架构

- 6.3.2 工作原理

- 6.3.3 工作模式

- 6.3.4 做高可用

- 6.4 Apache服务器怎么搭建, IO复用模型, select epoll

- 6.4.1 配置apache服务器

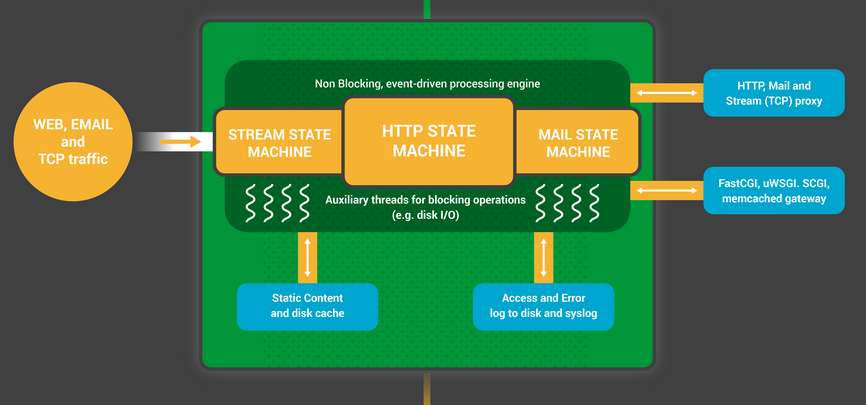

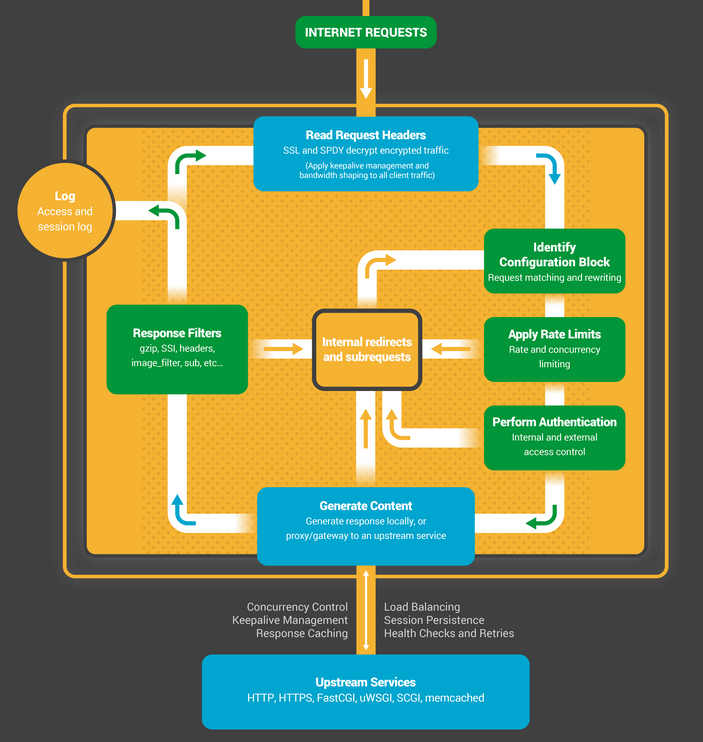

- 6.4.2 nginx架构

- 6.4.3 IO复用模型

- 6.5 公钥私钥原理,公钥文件存放哪里,权限是多少

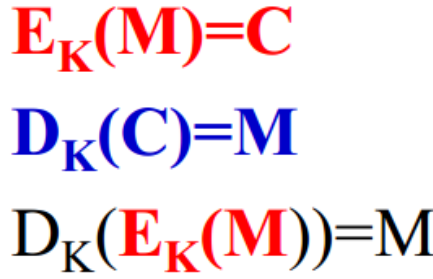

- 6.5.1 对称加密算法原理

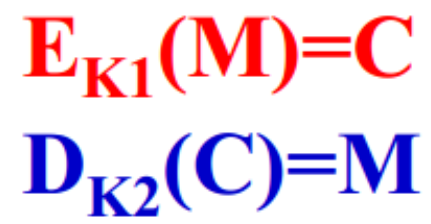

- 6.5.2 非对称加密算法原理

- 6.5.3 公钥文件以及权限

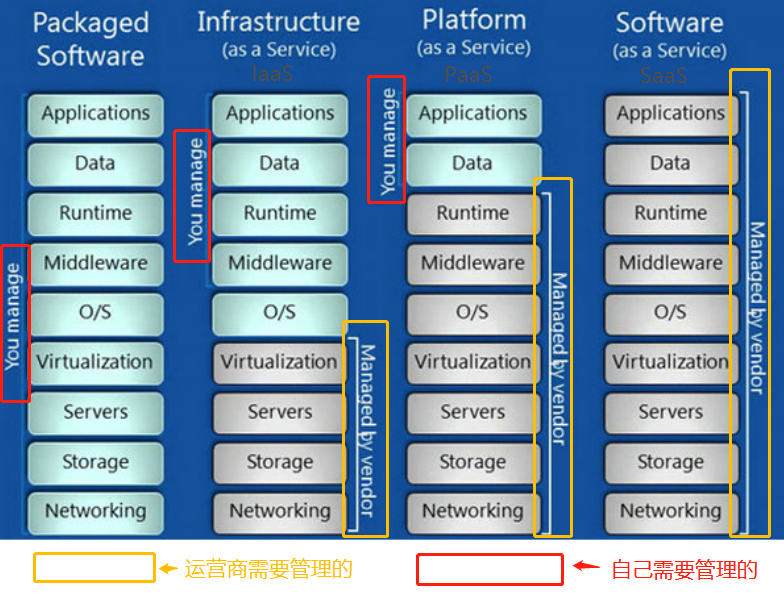

- 6.6 了解云计算

- 6.6.1 云计算分层

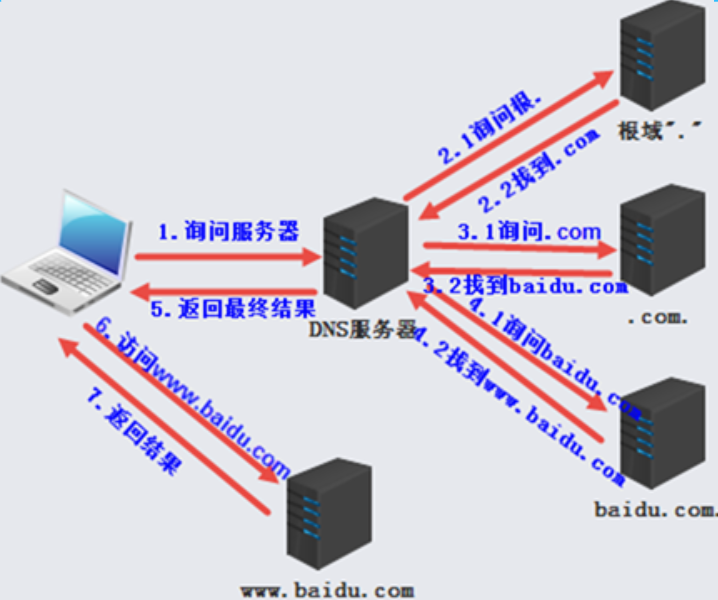

- 6.7 DNS的解析过程

- 6.7.1 实际查询过程分析

- 6.7.2 解析顺序

- 6.7.3 DNS服务器查找根域时丢包怎么办

- 6.8 为什么nginx支持高并发?

- 6.8.1 搭建静态资源web服务器

- 6.8.2 为什么nginx支持高并发

- 6.8.3 动态网页和静态网页有什么区别?

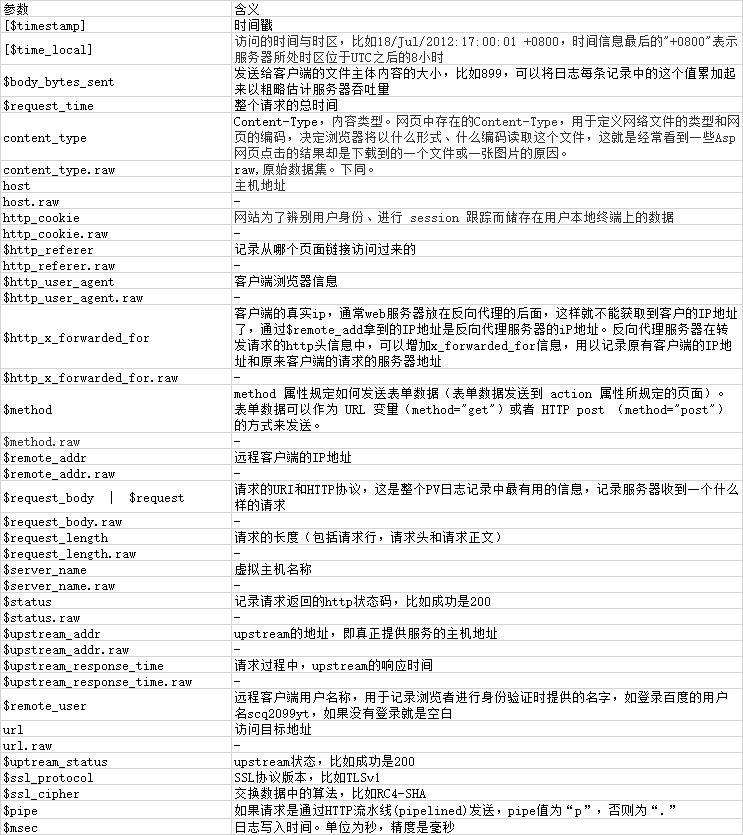

- 6.8.4 介绍一下nginx的日志

- 6.8.5 nginx的虚拟主机

- 6.8.6 nginx如何部署django

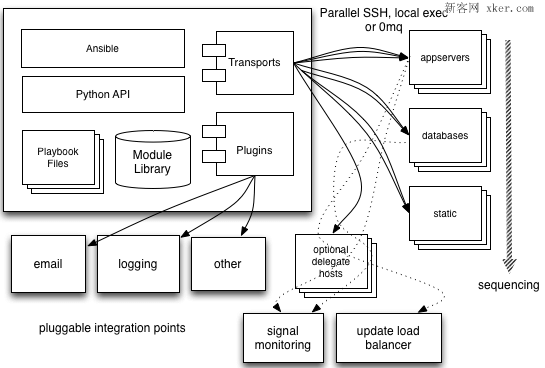

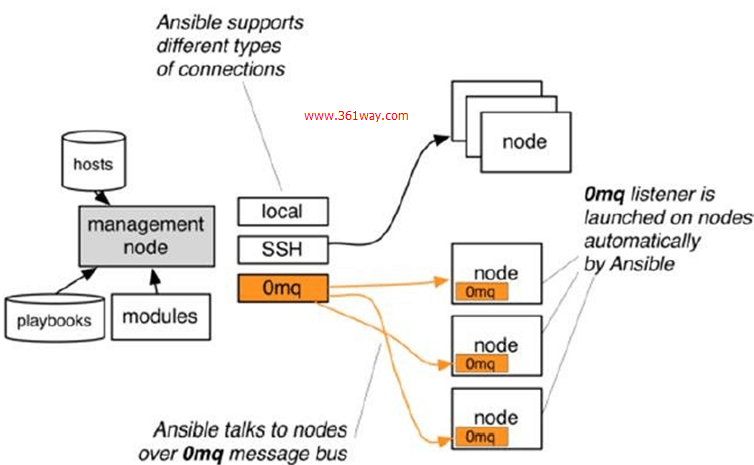

- 6.9 ansible的原理和使用方法

- 6.9.1 原理

- 6.9.2 使用方法

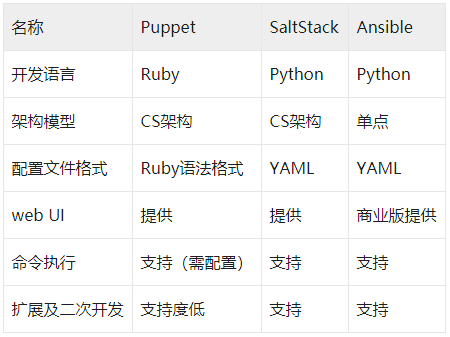

- 6.9.3 SaltStack、Ansible、Puppet比较

- 6.10 redis

- 6.10.1 redis的作用

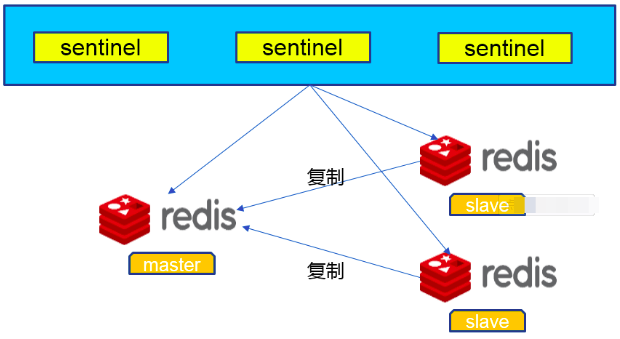

- 6.10.2 redis哨兵怎么做

- 6.10.3 redis数据库存放文件的地方

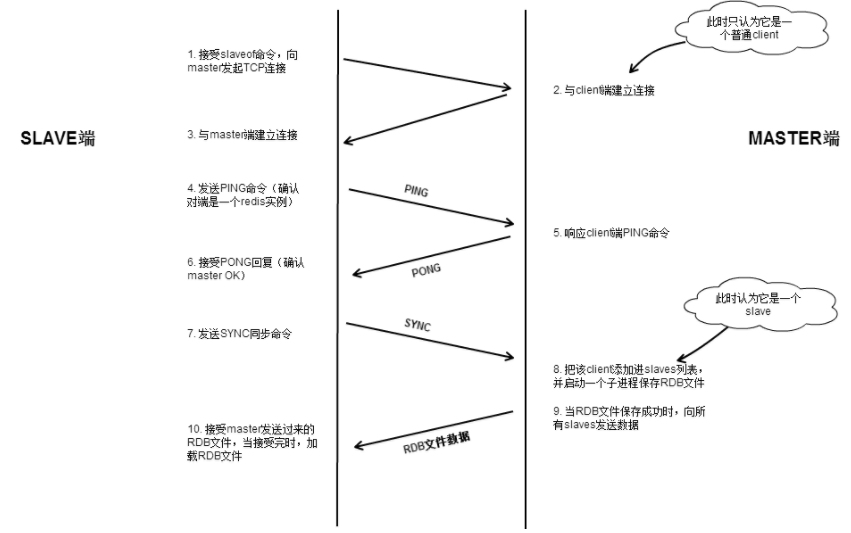

- 6.10.4 主从复制的过程

- 6.10.5 Redis常见问题和解决办法梳理

- 6.10.6 RDB和AOF持久化对比

一、tcp/ip协议栈

1.1 OSI七层模型

OSI七层模型:https://blog.csdn.net/yaopeng_2005/article/details/7064869

1.2 TCP timewait太多是什么原因

TCP timewait:https://www.cnblogs.com/softidea/p/5741192.html

在高并发短连接的TCP服务器上,当服务器处理完请求后立刻主动正常关闭连接。这个场景下会出现大量socket处于TIME_WAIT状态。

net.ipv4.tcp_tw_reuse=1 #表示开启重用。允许将TIME-WAIT sockets重新用于新的TCP连接,默认为0,表示关闭;该文件表示是否允许重新应用处于TIME-WAIT状态的socket用于新的TCP连接(这个对快速重启动某些服务,而启动后提示端口已经被使用的情形非常有帮助)

net.ipv4.tcp_tw_recycle=1 #表示开启TCP连接中TIME-WAIT sockets的快速回收,默认为0,表示关闭。

net.ipv4.tcp_timestamps #开启时,net.ipv4.tcp_tw_recycle开启才能生效,原因可以参考以下代码

timewait过多问题:https://www.cnblogs.com/dadonggg/p/8778318.html

1.3 TCP建立详细过程和UDP区别

TCP建立详细过程:https://blog.csdn.net/caoyan_12727/article/details/52081269

TCP和UDP区别:https://blog.csdn.net/weixin_46108954/article/details/104488107

1.4 介绍一下tcp包头有什么内容

tcp包头:https://blog.51cto.com/13854765/2163296

1.5 TCP 三次丢包了怎么办,过多久重传

主要的考虑还是要区分包的丢失是由于链路故障还是乱序等其他因素引发。两次duplicated ACK时很可能是乱序造成的!三次duplicated ACK时很可能是丢包造成的!

TCP 快速重传为什么是三次冗余ack:https://blog.csdn.net/u010202588/article/details/54563648

2MSL

1.6 TCP 4次为什么要4次关闭

四次挥手:https://blog.csdn.net/weixin_46108954/article/details/104687671

1.7 TCP 4次关闭服务端先关闭好还是客户端先关闭好

服务端先关闭,这段时间服务器端绑定的端口号被占用了,套接字不会释放。

客户端继续写的话,会触发SIGPIPE信号,操作系统会强制关闭客户端。

服务器先关闭,客户端不关闭的情况分析:https://blog.csdn.net/qq_37941471/article/details/82054920

为什么在四次挥手的过程中一般都是客户端先发起:https://blog.csdn.net/daputao_net/article/details/81255499

1.8 TCP UDP 区别分别用在那?举例说出应用到 TCP UDP 的协议

基于TCP的应用层协议有:SMTP、TELNET、HTTP、FTP

基于UDP的应用层协议:DNS、TFTP(简单文件传输协议)、RIP(路由选择协议)、DHCP、BOOTP(是DHCP的前身)、IGMP(Internet组管理协议)

1.9 TCP 如何实现可靠传输的?——超时重传+确认机制

通过累计确认、超时重传、拥塞控制三大模块保证

实现可靠传输:https://blog.csdn.net/shawjan/article/details/45117945

1.10 TCP滑动窗口什么情况下会变化,怎么变

滑动窗口实现有两个作用:

1.B端来不及处理接收数据(控制不同速率主机间的同步),这时,A通过B端通知的接收窗口而减缓数据的发送。

2.B端来得及处理接收数据,但是在A与B之间某处如C,使得AB之间的整体带宽性能较差,此时,A端根据拥塞处理策略(慢启动,加倍递减和缓慢增加)来更新窗口,以决定数据的发送。

条件判定:

1.cwnd < ssthresh, 继续使用慢开始算法;

2.cwnd > ssthresh,停止使用慢开始算法,改用拥塞避免算法;

3.cwnd = ssthresh,既可以使用慢开始算法,也可以使用拥塞避免算法;

TCP滑动窗口:https://www.cnblogs.com/alifpga/p/7675850.html

1.11 HTTP协议与TCP协议的关系

TCP协议是传输层协议,主要解决数据如何在网络中传输

HTTP是应用层协议,主要解决如何包装数据。

HTTP协议与TCP协议的关系:https://blog.csdn.net/weixin_46108954/article/details/104704231

1.12 HTTP和HTTPS的区别

HTTP + 加密 + 认证 + 完整性保护 = HTTPS

1.https协议需要到CA (Certificate Authority,证书颁发机构)申请证书,一般免费证书较少,因而需要一定费用。(原来网易官网是http,而网易邮箱是https。)

2.http是超文本传输协议,信息是明文传输,https则是具有安全性的ssl加密传输协议。

3.http和https使用的是完全不同的连接方式,用的端口也不一样,前者是80,后者是443。

4.http的连接很简单,是无状态的。Https协议是由SSL+Http协议构建的可进行加密传输、身份认证的网络协议,比http协议安全。(无状态的意思是其数据包的发送、传输和接收都是相互独立的。无连接的意思是指通信双方都不长久的维持对方的任何信息。)

HTTP和HTTPS的区别 :https://blog.csdn.net/qq_38289815/article/details/80969419

数字签名、数字证书与HTTPS是什么关系:https://www.zhihu.com/question/52493697

TLS,SSL:https://blog.csdn.net/kobejayandy/article/details/52433660

1.13 介绍HTTPS加密原理

非对称加密算法:RSA,DSA/DSS

对称加密算法:AES,RC4,3DES

HASH算法:MD5,SHA1,SHA256

HTTPS加密原理与算法详解:https://www.wosign.com/News/news_2018082801.htm

1.14 如何加快TCP socket连接的回收

/etc/sysctl.conf文件

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_tw_recycle = 1

net.ipv4.tcp_fin_timeout = 30

net.ipv4.tcp_timestamp = 1

net.ipv4.tcp_syncookies = 1表示开启SYN Cookies。当出现SYN等待队列溢出时,启用cookies来处理,可防范少量SYN攻击,默认为0,表示关闭;

net.ipv4.tcp_tw_reuse = 1表示开启重用。允许将TIME-WAIT sockets重新用于新的TCP连接,默认为0,表示关闭;

net.ipv4.tcp_tw_recycle = 1表示开启TCP连接中TIME-WAIT sockets的快速回收,默认为0,表示关闭。

net.ipv4.tcp_fin_timeout修改系統默认的TIMEOUT时间

开启tcp_timestamp是开启tcp_tw_recycle,tcp_tw_reuse和tcp_timestamp的前提条件。

但是在nat模式下,不用将tcp_tw_recycle和tcp_timestamp同时开启,这会造成tcp超时引发故障。

二、网络相关

2.1 五层模型

五层模型:https://www.cnblogs.com/bqwzx/p/11053778.html

应用层

传输层

网络层

数据链路层

物理层

2.2 TCP三次握手四次挥手

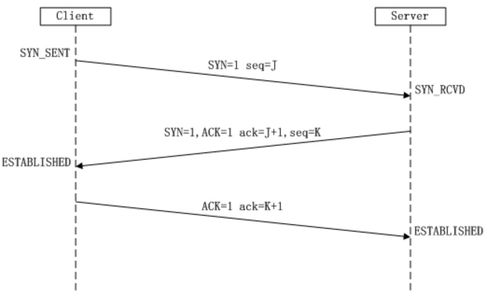

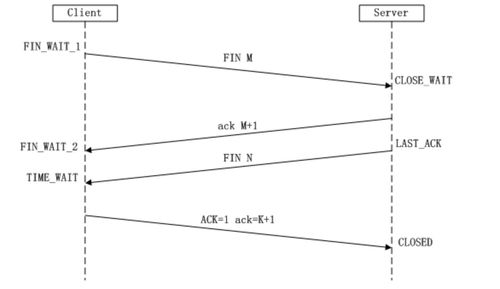

三次握手

四次挥手

2.3 TCP和UDP区别

TCP和UDP区别 :https://blog.csdn.net/weixin_46108954/article/details/104488107

1、连接、无连接

2、可靠性

3、有序性

4、数据边界

5、速度

6、重量级、轻量级

7、头大小

8、拥塞或流控制

9、用法和应用

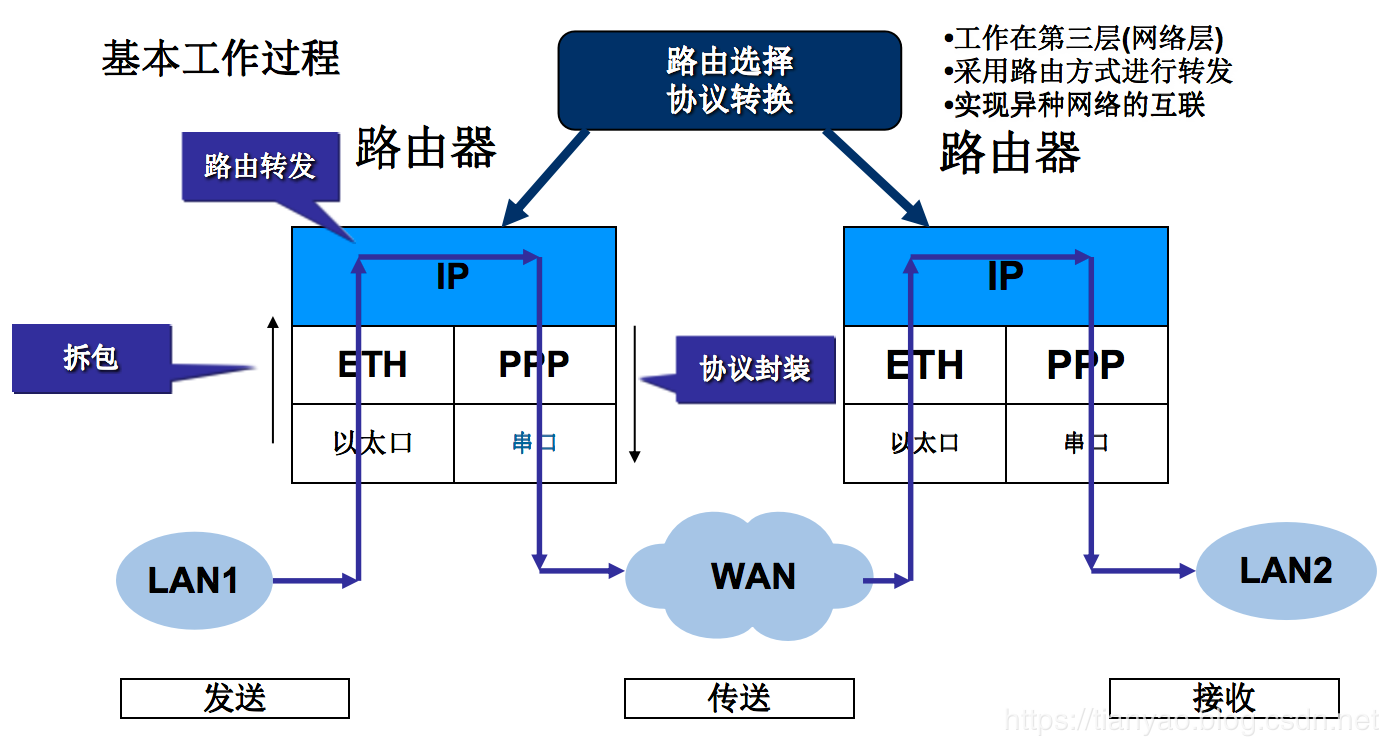

2.4 路由器和交换机区别

路由器和交换机:https://blog.csdn.net/qq_43624679/article/details/106238729

三层交换机和路由器:https://www.cnblogs.com/tianyao2020/p/12527817.html

路由器的工作原理

信息传输:路由转发

一个数据包进入路由器时,路由器先对其解封装到数据链路层以查看它的目标mac地址,然后再根据该目标mac地址判断是否进行下一步操作,具体分为以下:

①广播:解封装到第三层;

②组播:查看自己是否在组内,是,继续向上解封装,否,丢包;

③单播:判断该目标mac地址是否为数据包进入自身的端口的mac地址,是,继续向上解封装,否,丢包。

此时来到网络层,查看数据包的目标IP地址,再根据该目标IP地址判断是否进行下一步操作,具体分为以下:

①广播:继续向上解封装;

②组播:查看自己是否在组内,是,继续向上解封装,否,丢包;

③单播:查看目标IP地址是否为自己,是,继续向上解封装,否,路由器将查看本地路由表TCAM表进行下一步转发。

连接不同的网络:p2p、BMA、NBMA

路由器的另外一个功能是能互联不同的网络,具体的网络类型如下:

①p2p:点到点网络,仅允许存在两个物理接口;

②BMA:广播型多路访问,支持多路访问,可以洪泛;

③NBMA:非广播型多路访问,支持多路访问,但只能单播。

二层交换机的工作原理:

概括为:基于源mac地址学习,基于目标mac地址转发

即数据帧进入交换机时,首先查看源mac,交换机会将对应接口的VLAN ID+MAC地址+接口编号进行hash运算后的二进制记录到本地cam表中,然后查看数据包的目标mac地址,若目标mac地址存在本地的MAC地址表,则直接向其转发数据帧,否则进行洪泛,向除进入接口外的其他所有接口转发数据帧。

三层交换机的工作原理:

三层交换机是具有路由转发功能的二层交换机。

工作原理:当数据帧进入三层交换机后:

①查看源mac,生成cam表;

②再查看目标mac,此时目标mac

③查看目标IP地址,行为与上文路由器查看IP地址相同,不再赘述。

分为以下三种情况:

①广播:洪泛,向上解封装;

②组播:若交换机在该组,洪泛且向上解封装,否则丢包;

③单播:查看目标mac地址是否为在本地,是,继续向上解封装,否,基于cam表转发。

2.5 交换机性能优化

交换机性能:https://blog.51cto.com/774579/1412032

1、对于不变化的MAC地址和交换机端口,我们可以将MAC地址设置成静态的,这样,交换机一开机就知道恩,张三对应的是1号端口,李四对应的是2号端口

2、对于有变化但不是经常变化的MAC地址,我们可以设置老化时间,将老化时间设立的长一点,这样子交换机也就知道说,大家都是熟人,我就少喊两嗓子。

3、交换机的参数里面有两个重要的参数,那就是背板带宽和MAC地址表深度。个人感觉背板带宽比较重要。

2.6 四次挥手为什么有timewait

timewait :https://blog.csdn.net/u014053368/article/details/23117809

TIME_WAIT状态由两个存在的理由。

(1)可靠的实现TCP全双工链接的终止。

这是因为虽然双方都同意关闭连接了,而且握手的4个报文也都协调和发送完毕,按理可以直接回到CLOSED状态(就好比从SYN_SEND状态到ESTABLISH状态那样);但是因为我们必须要假想网络是不可靠的,你无法保证你最后发送的ACK报文会一定被对方收到,因此对方处于LAST_ACK状态下的SOCKET可能会因为超时未收到ACK报文,而重发FIN报文,所以这个TIME_WAIT状态的作用就是用来重发可能丢失的ACK报文。

(2)允许老的重复的分节在网络中消逝。

假设在12.106.32.254的1500端口和206.168.1.112.219的21端口之间有一个TCP连接。我们关闭这个链接,过一段时间后在相同的IP地址和端口建立另一个连接。后一个链接成为前一个的化身。因为它们的IP地址和端口号都相同。TCP必须防止来自某一个连接的老的重复分组在连接已经终止后再现,从而被误解成属于同一链接的某一个某一个新的化身。为做到这一点,TCP将不给处于TIME_WAIT状态的链接发起新的化身。既然TIME_WAIT状态的持续时间是MSL的2倍,这就足以让某个方向上的分组最多存活msl秒即被丢弃,另一个方向上的应答最多存活msl秒也被丢弃。通过实施这个规则,我们就能保证每成功建立一个TCP连接时。来自该链接先前化身的重复分组都已经在网络中消逝了。

2.7 HTTP协议

HTTP是应用层协议,主要解决如何包装数据。

2.8 交换机与路由器的区别,各自的应用场景

应用场景

交换机一般在已本地网中扩展用的,路由用来内网和外网的连接。

三、操作系统原理

3.1 硬盘接口类型

3.1.1 IDE

IDE接口的硬盘比较老款,其最大的表现在于数据线是一条像布条的东西。

IDE硬盘的传输模式有以下三种:PIO(Programmed I/O)模式,DMA(Driect Memory Access)模式,Ultra DMA(简称UDMA)模式。

PIO模式下的硬盘数据传输率在3MB/S到16.6MB/S不等;DMA(Direct Memory Access)模式分为Single-Word DMA及Multi-Word DMA两种,最高数据传输率分别为8.33MB/s和16.66MB/s;Ultra DMA模式随着科技的发展,传输速度已经高达100MB/S。

3.1.2 SATA

SATA接口硬盘

这种接口的硬盘又叫串口硬盘,是目前电脑硬盘的主流硬盘。它具备了更强的纠错能力,与以往相比其最大的区别在于能对传输指令(不仅仅是数据)进行检查,如果发现错误会自动矫正,这在很大程度上提高了数据传输的可靠性。

3.1.3 SCSI

这种接口并不是专门为硬盘设计的接口,是一种广泛应用于小型机上的高速数据传输技术。优点是应用范围广、多任务、带宽大、CPU占用率低,支持热插拔,不过缺点就是价格偏高。也因为如此SCSI接口的硬盘多用于服务器中而非个人。

3.1.4 SAS

SAS接口硬盘的一般用在服务器上面

可以看作是新一代的SCSI技术,其接口技术可以向下兼容SATA,所以SAS驱动器和SATA驱动器可以同时存在于一个存储系统之中。

3.2 中断机制

linux内核中断:https://blog.csdn.net/weixin_42092278/article/details/81989449

中断是指在CPU正常运行期间,由于内外部事件或由程序预先安排的事件引起的CPU暂时停止正在运行的程序,转而为该内部或外部事件或预先安排的事件服务的程序中去,服务完毕后再返回去继续运行被暂时中断的程序。

3.2.1 中断类型

同步中断由CPU本身产生,又称为内部中断。这里同步是指中断请求信号与代码指令之间的同步执行,在一条指令执行完毕后,CPU才能进行中断,不能在执行期间。所以也称为异常(exception)。

异步中断是由外部硬件设备产生,又称为外部中断,与同步中断相反,异步中断可在任何时间产生,包括指令执行期间,所以也被称为中断(interrupt)。

异常又可分为可屏蔽中断(Maskable interrupt)和非屏蔽中断(Nomaskable interrupt)。而中断可分为故障(fault)、陷阱(trap)、终止(abort)三类。

从广义上讲,中断又可分为四类:中断、故障、陷阱、终止。

| 类别 | 原因 | 异步/同步 | 返回行为 |

|---|---|---|---|

| 中断 | 来自I/O设备的信号 | 异步 | 总是返回到下一条指令 |

| 陷阱 | 有意的异常 | 同步 | 总是返回到下一条指令 |

| 故障 | 潜在可恢复的错误 | 同步 | 返回到当前指令 |

| 终止 | 不可恢复的错误 | 同步 | 不会返回 |

3.2.2 中断数据处理结构

Linux内核中处理中断主要有三个数据结构,irq_desc,irq_chip和irqaction。

-

irq_desc用于描述IRQ线的属性与状态,被称为中断描述符。

-

irq_chip用于描述不同类型的中断控制器。

-

在\include\linux\ interrupt.h中定义了 irqaction用来描述特定设备所产生的中断描述符。

3.2.3 Linux中断机制

Linux中断机制由三部分组成:

- 中断子系统初始化:内核自身初始化过程中对中断处理机制初始化,例如中断的数据结构以及中断请求等。

- 中断或异常处理:中断整体处理过程。

- 中断API:为设备驱动提供API,例如注册,释放和激活等。

注:IRQ线资源非常宝贵,我们在使用时必须先注册,不使用时必须释放IRQ资源。

ARM架构:https://blog.csdn.net/weixin_42092278/article/details/104491507

3.3 进程和线程的关系,父进程和子进程的关系

1、父子进程之间的关系

关于资源:子进程得到的是除了代码段是与父进程共享的意外,其他所有的都是得到父进程的一个副本,子进程的所有资源都继承父进程,得到父进程资源的副本,既然为副本,也就是说,二者并不共享地址空间。两个是单独的进程,继承了以后二者就没有什么关联了,子进程单独运行。(采用写时复制技术)

关于文件描述符:继承父进程的文件描述符时,相当于调用了dup函数,父子进程共享文件表项,即共同操作同一个文件,一个进程修改了文件,另一个进程也知道此文件被修改了。

2、线程与进程之间的关系

一个进程的线程之间共享由进程获得的资源,但线程拥有属于自己的一小部分资源,就是栈空间,保存其运行状态和局部自动变量的。堆是堆,栈是栈。栈可以叫做:堆栈,栈,栈和堆栈指的都是stack,只是叫法不一样。而堆就只能叫做堆。在线程中new出来的空间占的是进程的资源,也就是说是占用的堆资源(heap)。

3.4 线程和进程的区别

线程和进程的区别 :https://www.zhihu.com/question/25532384

进程是资源分配的最小单位,线程是CPU调度的最小单位

做个简单的比喻:进程=火车,线程=车厢

- 线程在进程下行进(单纯的车厢无法运行)

- 一个进程可以包含多个线程(一辆火车可以有多个车厢)

- 不同进程间数据很难共享(一辆火车上的乘客很难换到另外一辆火车,比如站点换乘)

- 同一进程下不同线程间数据很易共享(A车厢换到B车厢很容易)

- 进程要比线程消耗更多的计算机资源(采用多列火车相比多个车厢更耗资源)

- 进程间不会相互影响,一个线程挂掉将导致整个进程挂掉(一列火车不会影响到另外一列火车,但是如果一列火车上中间的一节车厢着火了,将影响到所有车厢)

- 进程可以拓展到多机,进程最多适合多核(不同火车可以开在多个轨道上,同一火车的车厢不能在行进的不同的轨道上)

- 进程使用的内存地址可以上锁,即一个线程使用某些共享内存时,其他线程必须等它结束,才能使用这一块内存。(比如火车上的洗手间)-“互斥锁”

- 进程使用的内存地址可以限定使用量(比如火车上的餐厅,最多只允许多少人进入,如果满了需要在门口等,等有人出来了才能进去)-“信号量”

四、linux基础知识

4.1 tr命令和sar命令

tr命令可以对来自标准输入的字符进行替换、压缩和删除。

tr命令:https://www.cnblogs.com/bingguoguo/articles/9188703.html

sar命令可以查看系统cpu、内存利用率、磁盘IO、流量等情况

sar -u 1 10 (1:每隔一秒,10:写入10次)

sar命令:https://blog.csdn.net/volitationlong/article/details/81741754

4.2 管道符和重定向的区别

管道符 |:把结果传给一个变量

重定向 >>:将定向符前面的命令输出的内容重定向到一个目标位置

管道符可以把标准输出转标准输入,以让可以接受标准输入的命令可以以此为输入执行命令

输入输出重定向就是取代了键盘屏幕,能够接受键盘输入的都可以用重定向改为文件输入,能够输出到屏幕的,都可以通过重定向保存到文件

4.3 cache和buffer区别

cache和buffer区别 :https://www.zhihu.com/question/26190832

cache 缓存

cache 是为了弥补高速设备和低速设备的鸿沟而引入的中间层,最终起到加快访问速度的作用。

因为CPU和memory之间的速度差异越来越大,所以人们充分利用数据的局部性(locality)特征,通过使用存储系统分级(memory hierarchy)的策略来减小这种差异带来的影响。

buffer 缓冲

buffer 的主要目的进行流量整形,把突发的大数量较小规模的 I/O 整理成平稳的小数量较大规模的 I/O,以减少响应次数。

比如生产者——消费者问题,他们产生和消耗资源的速度大体接近,加一个buffer可以抵消掉资源刚产生/消耗时的突然变化。

直观的区别:

cache是随机访问,buffer往往是顺序访问

释放buffffer和cache

[root@linux-server ~]# echo 3 > /proc/sys/vm/drop_caches

以读写来对两者分析:

在read(读取)的场合,cache通常被用于减少重复读取数据时的开销,而buffer则用于规整化每次读取数据的尺寸,在读取场合两者用途差别很大。

在write(写入)的场合,两者功能依然没变,但由于cache跟buffer的功能在写入场合可以融合使用,所以两者可以被混淆,写入缓冲跟写入缓存往往会同时担当规整化写入尺寸以及减少写入次数的功能,所以两者有时会被混淆,但这只是个名称问题,没有原则性关系。

4.4 Linux怎么设置开机自启动某个脚本

4.4.1 第一种 chkconfig管理

将脚本拷贝到/etc/init.d/目录下,

添加到系统服务

chkconfig --add name.sh

设置开机启动

chkconfig name.sh on

重启

4.4.2 第二种 修改/etc/rc.local

name.sh

#!/bin/bash

/bin/echo $(/bin/date +%F_%T) >> /tmp/name.log

/etc/rc.local,该文件为链接文件

[root@localhost ~]# ll /etc/rc.local

lrwxrwxrwx. 1 root root 13 Feb 5 10:03 /etc/rc.local -> rc.d/rc.local

修改/etc/rc.local文件

[root@localhost scripts]# tail -n 1 /etc/rc.local

/bin/bash /server/scripts/name.sh >/dev/null 2>/dev/null

重启系统,查看结果

[root@localhost ~]# cat /tmp/name.log

2020-06-19_23:30:56

已开机自启动该脚本

4.5 kill和kill-9区别

kill详解:https://www.cnblogs.com/liuhouhou/p/5400540.html

kill -15:一般不加参数kill是使用15来杀,这相当于正常停止进zhi程,停止进程的时候会释放进程所占用的资源;

kill - 9: 表示强制杀死该进程

附录:

linux signals

| Signal Name | Number | Description |

|---|---|---|

| SIGHUP | 1 | Hangup (POSIX) |

| SIGINT | 2 | Terminal interrupt (ANSI) |

| SIGQUIT | 3 | Terminal quit (POSIX) |

| SIGILL | 4 | Illegal instruction (ANSI) |

| SIGTRAP | 5 | Trace trap (POSIX) |

| SIGIOT | 6 | IOT Trap (4.2 BSD) |

| SIGBUS | 7 | BUS error (4.2 BSD) |

| SIGFPE | 8 | Floating point exception (ANSI) |

| SIGKILL | 9 | Kill(can’t be caught or ignored) (POSIX) |

| SIGUSR1 | 10 | User defined signal 1 (POSIX) |

| SIGSEGV | 11 | Invalid memory segment access (ANSI) |

| SIGUSR2 | 12 | User defined signal 2 (POSIX) |

| SIGPIPE | 13 | Write on a pipe with no reader, Broken pipe (POSIX) |

| SIGALRM | 14 | Alarm clock (POSIX) |

| SIGTERM | 15 | Termination (ANSI) |

| SIGSTKFLT | 16 | Stack fault |

| SIGCHLD | 17 | Child process has stopped or exited, changed (POSIX) |

| SIGCONT | 18 | Continue executing, if stopped (POSIX) |

| SIGSTOP | 19 | Stop executing(can’t be caught or ignored) (POSIX) |

| SIGTSTP | 20 | Terminal stop signal (POSIX) |

| SIGTTIN | 21 | Background process trying to read, from TTY (POSIX) |

| SIGTTOU | 22 | Background process trying to write, to TTY (POSIX) |

| SIGURG | 23 | Urgent condition on socket (4.2 BSD) |

| SIGXCPU | 24 | CPU limit exceeded (4.2 BSD) |

| SIGXFSZ | 25 | File size limit exceeded (4.2 BSD) |

| SIGVTALRM | 26 | Virtual alarm clock (4.2 BSD) |

| SIGPROF | 27 | Profiling alarm clock (4.2 BSD) |

| SIGWINCH | 28 | Window size change (4.3 BSD, Sun) |

| SIGIO | 29 | I/O now possible (4.2 BSD) |

| SIGPWR | 30 | Power failure restart (System V) |

4.6 写一个脚本来判断文件是否存在

判断文件:https://blog.csdn.net/it8343/article/details/93207169

判断文件是否存在:

if [ -f "/data/filename" ];thenecho "文件存在"

elseecho "文件不存在"

fi

其他参数

-e 判断对象是否存在

-d 判断对象是否存在,并且为目录

-f 判断对象是否存在,并且为常规文件

-L 判断对象是否存在,并且为符号链接

-h 判断对象是否存在,并且为软链接

-s 判断对象是否存在,并且长度不为0

-r 判断对象是否存在,并且可读

-w 判断对象是否存在,并且可写

-x 判断对象是否存在,并且可执行

-O 判断对象是否存在,并且属于当前用户

-G 判断对象是否存在,并且属于当前用户组

-nt 判断file1是否比file2新 [ "/data/file1" -nt "/data/file2" ]

-ot 判断file1是否比file2旧 [ "/data/file1" -ot "/data/file2" ]

4.7 ping一个地址的实现过程,协议

Ping命令用ICMP实现的,ICMP是Internet控制消息协议,用于IP主机,路由器之间传递消息。控制消息是指网络通不通,主机是否可达,路由器是否可用等网络本身的消息,这些控制消息并不传输用户数据。

Ping的原理是:向指定IP发送一定长度的数据包,按照约定,若指定IP存在的话,会返回同样大小的数据包,若没有在特定时间返回就是超时,就认为指定IP不存在。但是由于防火墙会屏蔽ICMP协议,所以ping不通不一定说明对方IP不存在。

注:跟踪路由的Tracert命令也是基于ICMP协议

4.8 用脚本实现最简单的两个数相除(精确到小数点后四位)

第一种

[root@mysql ~]# awk 'BEGIN{printf "%0.4f",1/3}' | sed 's/[0-9]$/&\n/g'

0.3333

第二种

[root@mysql tmp]# vim shell.sh#! /bin/bashecho "此脚本用于计算1-1/2+1/3-1/4+....-1/N的值"

echo "请输入 N:"

read N

sum=0

for ((i=1;i<N+1;i++))

dores=$(printf "%.4f" `echo "scale=3;1/$i"|bc`)sum=$(printf "%.4f" `echo "scale=3;$sum+$res"|bc`)

done

echo "结果是:$sum"[root@mysql tmp]# ./shell.sh

此脚本用于计算1-1/2+1/3-1/4+....-1/N的值

请输入 N:

5

结果是:2.2830

4.9 权限体系,755,一些特殊文件为什么是600.400

权限掩码umask

umask设置的是权限“补码”:如上umask值为022,则对应目录权限为7-0=7,7-2=5,7-2=5,即用777减去umask的相应位上的值;而对应的文件权限是用666减去umask的相应位上的值。

查看

[root@mysql tmp]# umask

0022

默认情况下

- 目录权限rwx r-x r-x (755) 这就是目录创建缺省权限 777

- 文件权限rw- r– r– (644) 这就是文件创建缺省权限 666

4.10 查看内存的命令,内存占用最大的进程,怎么看这个进程调用了哪些文件,以及查看核数

内存查看:https://www.cnblogs.com/sunyllove/p/9968219.html

内存占用进程:https://www.cnblogs.com/sparkbj/p/6148817.html

4.10.1 查看内存的命令

free

sar

top(htop itop)

ps aux

cat /proc/meminfo

4.10.2 内存占用最大的进程

ps aux|head -1;ps aux|grep -v PID|sort -rn -k +4|head

查看占用内存最高的进程

ps aux|head -1;ps aux|grep -v PID|sort -rn -k +4|head

或者top (然后按下M,注意这里是大写)

4.10.3 看这个进程调用了哪些文件

查看该进程打开的文件:lsof -p ID

查看内存分配:cat /proc/ID/maps

4.10.4 查看核数

cat /proc/cpuinfo

查看linux系统核数

cat /proc/cpuinfo| grep "processor"

总核数 = 物理CPU个数 X 每颗物理CPU的核数

总逻辑CPU数 = 物理CPU个数 X 每颗物理CPU的核数 X 超线程数

查看物理CPU个数

cat /proc/cpuinfo| grep "physical id"| sort| uniq| wc -l

或grep 'physical id' /proc/cpuinfo | sort -u | wc -l

查看每个物理CPU中core的个数(即核数)

cat /proc/cpuinfo| grep "cpu cores"| uniq

或者grep 'core id' /proc/cpuinfo | sort -u | wc -l

查看逻辑CPU的个数

cat /proc/cpuinfo| grep "processor"| wc -l

或者grep 'processor' /proc/cpuinfo | sort -u | wc -l

查看CPU信息(型号)

cat /proc/cpuinfo | grep name | cut -f2 -d: | uniq -c

或者dmidecode -s processor-version

#查看内 存信息cat /proc/meminfo

4.11 tcpdump指定源端口,过滤8000-9000端口

tcpdump帮助页:https://www.tcpdump.org/manpages/tcpdump.1.html

tcpdump帮助页中文版:https://www.cnblogs.com/ggjucheng/archive/2012/01/14/2322659.html

tcpdump高级包过滤:https://blog.csdn.net/wzx19840423/article/details/50836761

tcpdump可以将网络中传送的数据包的“头”完全截获下来提供分析。它支持针对网络层、协议、主机、网络或端口的过滤,并提供and、or、not等逻辑语句来帮助你去掉无用的信息。

[root@mysql ~]# tcpdump --help

tcpdump version 4.9.2

libpcap version 1.5.3

OpenSSL 1.0.2k-fips 26 Jan 2017

Usage: tcpdump [-aAbdDefhHIJKlLnNOpqStuUvxX#] [ -B size ] [ -c count ][ -C file_size ] [ -E algo:secret ] [ -F file ] [ -G seconds ][ -i interface ] [ -j tstamptype ] [ -M secret ] [ --number ][ -Q|-P in|out|inout ][ -r file ] [ -s snaplen ] [ --time-stamp-precision precision ][ --immediate-mode ] [ -T type ] [ --version ] [ -V file ][ -w file ] [ -W filecount ] [ -y datalinktype ] [ -z postrotate-command ][ -Z user ] [ expression ]

过滤8000-9000端口

tcpdump -i eth0 src port 'tcp[0:2] not 8000-9000'

另外:

time tcpdump -nn -i eth0 'tcp[tcpflags] = tcp-syn' -c 10000 > /dev/null

上面的命令计算抓10000个SYN包花费多少时间,可以判断访问量大概是多少。

指定某个IP抓

tcpdump -i eth0 host 192.168.1.1

4.12 几种下载安装的步骤,报错有哪些情况,怎么解决

4.12.1 yum安装

一般来说配置镜像站比较好,这样可以安装自己想要的软件包

(默认下,会找最近的镜像站)

yum install -y (apt-get install)

rpm -ivh

升级rpm -Uvh

4.12.2 编译安装

xxx.tar.gz

tar -xzf

./configure

make

make install

4.12.3 二进制安装

xxx.tar.gz

tar -xzf

通过配置文件来完成

4.12.4 三种安装方法优缺点比较

| rpm | 二进制 | 源码 | |

|---|---|---|---|

| 优点 | 安装简单,适合初学者学习使用 | 安装简单 可以安装在任何路径下,灵活性好 一台服务器可以安装多个mysql |

在实际安装的操作系统进行可根据需要定制编译,最灵活 性能最好 一台服务器可以安装多个mysql |

| 缺点 | 需要单独下载客户端和服务器 安装路径不灵活,默认路径不能修改,一台服务器只能安装一个mysql |

已经经过编译,性能不如源码编译的好 不能灵活定制编译参数 |

安装过程较复杂 编译时间长 |

4.12.5 常见错误

1)BASE镜像多个问题:https://www.cnblogs.com/kaiziwu/p/12101742.html

Repository base is listed more than once in the configuration"和"没有可用软件包 XXX"的问题

从对报错内容的分析来看, 应该是软件源有重复(“listed more than once”), 所以这里我们尝试删除一些上面的软件源配置文件.

在删除之前, 先对 /etc/yum.repos.d/ 目录下的文件做一个整体的备份, 以便于尝试失败后的还原.

删除之后重建缓存 yum clean all; yum makecache

2)epel库没装

导致有些软件包没有

yum install -y epel-release

3)没有更新源或者已安装软件包

yum update (apt-get update)(更新源)

yum upgrade (apt-get install upgrade) (更新已安装的包) (这个要慎重)

4.13 iptables的操作,过滤一个IP,与firewall的区别,了解ipset

4.13.1 iptables过滤一个IP

iptables用法:https://www.cnblogs.com/chanix/p/12744074.html

过滤某个IP

iptables -A INPUT -s 192.168.80.121 -p tcp -d 192.168.217.155 --dport 80 -j DROP

其他iptables指令:https://blog.csdn.net/chengxuyuanyonghu/article/details/51897666

4.13.2 查看output策略

iptables -L [-t (filter/nat/mangle/raw)] OUTPUT

4.13.3 建立自定义链

iptables -N NAME 创建自定义链

iptables -A INPUT -p tcp -s 192.168.217.154 --dport 80 -j NAME 引用自定义链

iptables -E OLD NEW 重命名自定义链

iptables -X NAME 删除自定义链

4.13.4 清理防火墙选项

iptables -F

4.13.5 7以上防火墙命令

firewalld操作命令:https://www.cnblogs.com/leoxuan/p/8275343.html

firewalld-cmd

参数

--get-default-zone 查询默认的区域名称

--set-default-zone=<区域名称> 设置默认的区域,使其永久生效

--get-services 显示预先定义的服务

4.13.6 iptables与firewall的区别

iptables和firewalld的详解:https://blog.csdn.net/weixin_40658000/article/details/78708375

firewall是centos7里面的新的防火墙命令,它底层还是使用 iptables 对内核命令动态通信包过滤的,简单理解就是firewall是centos7下管理iptables的新命令

1)最本质的不同在于配置文件的位置

iptables 在/etc/sysconfig/iptables中储存配置,而firewalld将配置储存在/usr/lib/firewalld/和/etc/firewalld/中的各种XML文件里

2)iptables通过控制端口来控制服务,而firewalld则是通过控制协议来控制端口

3)一个黑名单,一个白名单

4)一个centos6,一个centos7

4.13.7 ipset

ipset详解:https://blog.csdn.net/gymaisyl/article/details/101695697

ipset是iptables的扩展,它允许你创建 匹配整个地址集合的规则。而不像普通的iptables链只能单IP匹配, ip集合存储在带索引的数据结构中,这种结构即时集合比较大也可以进行高效的查找,除了一些常用的情况,比如阻止一些危险主机访问本机,从而减少系统资源占用或网络拥塞,IPsets也具备一些新防火墙设计方法,并简化了配置.

应用:

- 一口气存储多个IP地址或端口号,并与iptables 进行匹配;

- 针对IP地址或端口动态更新iptables规则,而不会影响性能;

- 通过一个iptables规则表达基于IP地址和端口的复杂规则集, 并受益于IP集的速度

ipset官网:http://ipset.netfilter.org/

[root@localhost ~]# ipset --help

ipset v6.29Usage: ipset [options] COMMANDCommands:

create SETNAME TYPENAME [type-specific-options]Create a new set

SETNAME是创建的ipset的名称,TYPENAME是ipset的类型: add SETNAME ENTRYAdd entry to the named set

del SETNAME ENTRYDelete entry from the named set

test SETNAME ENTRYTest entry in the named set

destroy [SETNAME]Destroy a named set or all sets

list [SETNAME]List the entries of a named set or all sets

save [SETNAME]Save the named set or all sets to stdout

restore Restore a saved state

flush [SETNAME]Flush a named set or all sets

rename FROM-SETNAME TO-SETNAMERename two sets

swap FROM-SETNAME TO-SETNAMESwap the contect of two existing sets

help [TYPENAME]Print help, and settype specific help

version Print version information

quit Quit interactive modeOptions:

-o plain|save|xmlSpecify output mode for listing sets.Default value for "list" command is mode "plain"and for "save" command is mode "save".

-s Print elements sorted (if supported by the set type).

-q Suppress any notice or warning message.

-r Try to resolve IP addresses in the output (slow!)

-! Ignore errors when creating or adding sets orelements that do exist or when deleting elementsthat don't exist.

-n When listing, just list setnames from the kernel.-t When listing, list setnames and set headersfrom kernel only.

-f Read from the given file instead of standardinput (restore) or write to given file insteadof standard output (list/save).Supported set types:list:set 3 skbinfo supportlist:set 2 comment supportlist:set 1 counters supportlist:set 0 Initial revisionhash:mac 0 Initial revisionhash:net,iface 6 skbinfo supporthash:net,iface 5 forceadd supporthash:net,iface 4 comment supporthash:net,iface 3 counters supporthash:net,iface 2 /0 network supporthash:net,iface 1 nomatch flag supporthash:net,iface 0 Initial revisionhash:net,port 7 skbinfo supporthash:net,port 6 forceadd supporthash:net,port 5 comment supporthash:net,port 4 counters supporthash:net,port 3 nomatch flag supporthash:net,port 2 Add/del range supporthash:net,port 1 SCTP and UDPLITE supporthash:net,port,net 2 skbinfo supporthash:net,port,net 1 forceadd supporthash:net,port,net 0 initial revisionhash:net,net 2 skbinfo supporthash:net,net 1 forceadd supporthash:net,net 0 initial revisionhash:net 6 skbinfo supporthash:net 5 forceadd supporthash:net 4 comment supporthash:net 3 counters supporthash:net 2 nomatch flag supporthash:net 1 Add/del range supporthash:net 0 Initial revisionhash:ip,port,net 7 skbinfo supporthash:ip,port,net 6 forceadd supporthash:ip,port,net 5 comment supporthash:ip,port,net 4 counters supporthash:ip,port,net 3 nomatch flag supporthash:ip,port,net 2 Add/del range supporthash:ip,port,net 1 SCTP and UDPLITE supporthash:ip,port,ip 5 skbinfo supporthash:ip,port,ip 4 forceadd supporthash:ip,port,ip 3 comment supporthash:ip,port,ip 2 counters supporthash:ip,port,ip 1 SCTP and UDPLITE supporthash:ip,mark 2 sbkinfo supporthash:ip,mark 1 forceadd supporthash:ip,mark 0 initial revisionhash:ip,port 5 skbinfo supporthash:ip,port 4 forceadd supporthash:ip,port 3 comment supporthash:ip,port 2 counters supporthash:ip,port 1 SCTP and UDPLITE supporthash:ip 4 skbinfo supporthash:ip 3 forceadd supporthash:ip 2 comment supporthash:ip 1 counters supporthash:ip 0 Initial revisionbitmap:port 3 skbinfo supportbitmap:port 2 comment supportbitmap:port 1 counters supportbitmap:port 0 Initial revisionbitmap:ip,mac 3 skbinfo supportbitmap:ip,mac 2 comment supportbitmap:ip,mac 1 counters supportbitmap:ip,mac 0 Initial revisionbitmap:ip 3 skbinfo supportbitmap:ip 2 comment supportbitmap:ip 1 counters supportbitmap:ip 0 Initial revision

源和目的都使用ipset(源ip集合为aaa,目的ip集合为bbb)

iptables -I INPUT -m set --match-set aaa src -m set --match-set bbb dst -j DROP

4.14 查看网卡信息,MTU与MSS的区别

4.14.1 查看网卡信息

查看网卡详解:https://blog.csdn.net/morigejile/article/details/78598645

ifconfig

lspci (pciutils)

iwconfig (wireless-tools)用于查看无线网络

ethtool 用于查询配置网卡参数

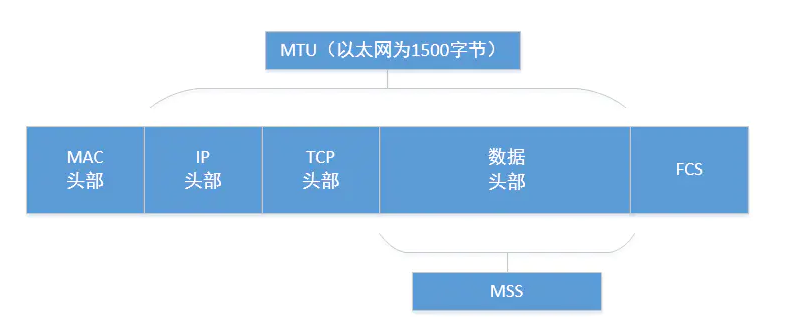

4.14.2 MTU

MTU:https://blog.csdn.net/passionkk/article/details/100538418

标准以太网长度上下限:https://blog.51cto.com/19880206/890070

Maximum Transmission Unit,缩写MTU,中文名是:最大传输单元。

标准以太网帧长度下限为:64 字节

标准以太网帧长度上限为:1518 字节

1518,头信息有14字节,尾部校验和FCS占了4字节,所以真正留给上层协议传输数据的大小就是:1518 - 14 - 4 = 1500

标准以太网帧长度下限:

一个帧从A-B,B-A的这个时间被称为slot time,这个时间计算出来为57.6 μs.

在10Mbit/s的网络中,在57.6μs的时间内,能够传输576个bit,所以要求以太网帧的大小最小为576个bits,从而让所有的碰撞都能够被检测到

在传输完一个数据帧以后,在传输下一个数据帧之前,要传输12bytes的空闲帧

12 bytes = 12×8 = 96 bits

在10Mbit/s的网络中,传输1个bit 需要的时间为 1×10-7s

所以Interframe Gap 的时间为 96×10-7=9.6×10-6 s= 9.6μs

在一个数据帧发送完以后,要等待9.6μs的时间,然后再传输下一个数据帧

576bits= 72 bytes

通常情况下我们所说的以太网长度,不包括preamble和start of frame delimiter,所以以太网最小长度为:72-8= 64 bytes

标准以太网帧长度上限:

标准的以太网的最大字节长度为1518/1522:

untagged的frame最大帧长为1518

tagged的frame 最大帧长为1522

4.14.3 MSS

Maximum Segment Size,缩写MSS,中文名是:最大报文段长度。

为了达到最佳的传输效能,TCP协议在建立连接的时候通常要协商双方的MSS值,这个值TCP协议在实现的时候往往用MTU值代替(需要减去IP数据包包头的大小20Bytes和TCP数据段的包头20Bytes)所以一般MSS值1460

4.14.4 MTU和MSS的区别

MTU: Maximum Transmit Unit,最大传输单元,即物理接口(数据链路层)提供给其上层(通常是IP层)最大一次传输数据的大小;以普遍使用的以太网接口为例,缺省MTU=1500 Byte,这是以太网接口对IP层的约束,如果IP层有<=1500 byte 需要发送,只需要一个IP包就可以完成发送任务;如果IP层有> 1500 byte 数据需要发送,需要分片才能完成发送,这些分片有一个共同点,即IP Header ID相同。

MSS:Maximum Segment Size ,TCP提交给IP层最大分段大小,不包含TCP Header和 TCP Option,只包含TCP Payload ,MSS是TCP用来限制application层最大的发送字节数。如果底层物理接口MTU= 1500 byte,则 MSS = 1500- 20(IP Header) -20 (TCP Header) = 1460 byte,如果application 有2000 byte发送,需要两个segment才可以完成发送,第一个TCP segment = 1460,第二个TCP segment = 540。

4.15 cpu的使用率是怎样计算的,120%是什么意思,一个什么样的进程能让他达到200%

CPU使用率计算:https://www.cnblogs.com/gatsby123/p/11127158.html

man top查看

1. %CPU -- CPU UsageThe task's share of the elapsed CPU time since the lastscreen update, expressed as a percentage of total CPUtime.In a true SMP environment, if a process is multi-threadedand top is not operating in Threads mode, amounts greaterthan 100% may be reported. You toggle Threads mode withthe `H' interactive command.Also for multi-processor environments, if Irix mode isOff, top will operate in Solaris mode where a task's cpuusage will be divided by the total number of CPUs. Youtoggle Irix/Solaris modes with the `I' interactive com‐mand.

总结来说某个进程的CPU使用率就是这个进程在一段时间内占用的CPU时间占总的CPU时间的百分比。

比如某个开启多线程的进程1s内占用了CPU0 0.6s, CPU1 0.6s, 那么它的占用率是120%。

某进程cpu使用率 = 该进程cpu时间 / 总cpu时间。

200%:

占用系统内存高,

netstat -natp | awk ‘{print $7}’| sort|uniq -c|sort -rn可以统计进程中线程的连接数。

top 命令:查看进程级别的cpu使用情况。

vmstat 命令:查看系统级别的cpu使用情况。

4.16 查看系统io状态,iostat里面的io百分比是怎么算的

4.16.1 查看系统io状态

1)

iostat手册:http://sebastien.godard.pagesperso-orange.fr/man_iostat.html

iostat(sysstat)

[root@mysql ~]# iostat

Linux 3.10.0-693.el7.x86_64 (mysql) 07/01/2020 _x86_64_ (1 CPU)avg-cpu: %user %nice %system %iowait %steal %idle0.02 0.00 0.07 0.06 0.00 99.85Device: tps kB_read/s kB_wrtn/s kB_read kB_wrtn

sda 0.20 3.76 2.13 199863 113262

scd0 0.00 0.02 0.00 1028 0

解释一下各个输出项的含义:

avg-cpu段:

%user: 在用户级别运行所使用的CPU的百分比.

%nice: nice操作所使用的CPU的百分比.

%system: 在系统级别(kernel)运行所使用CPU的百分比.

%iowait: CPU等待硬件I/O时,所占用CPU百分比.

%steal显示在管理程序为另一个虚拟处理器提供服务时,一个或多个虚拟CPU在非自愿等待中花费的时间百分比.

%idle: CPU空闲时间的百分比.

Device段:

tps: 每秒钟发送到的I/O请求数.

Blk_read /s: 每秒读取的block数.

Blk_wrtn/s: 每秒写入的block数.

Blk_read: 读入的block总数.

Blk_wrtn: 写入的block总数.入门使用

1.若 %iowait 的值过高,表示硬盘存在I/O瓶颈

2.若 %idle 的值高但系统响应慢时,有可能是CPU等待分配内存,此时应加大内存容量

3.若 %idle 的值持续低于1,则系统的CPU处理能力相对较低,表明系统中最需要解决的资源是 CPU

2)

/proc/diskstats文件

diskstats:https://blog.csdn.net/cyan_grey/article/details/82787686

[root@mysql ~]# cat /proc/diskstats 8 0 sda 6352 64 461774 52377 5356 5774 947786 277103 0 33088 3280478 1 sda1 134 1 8668 330 3 0 18 0 0 104 3308 2 sda2 6079 63 444530 51800 5353 5774 947768 277103 0 33009 3274708 3 sda3 52 0 4424 214 0 0 0 0 0 190 21411 0 sr0 18 0 2056 201 0 0 0 0 0 197 201

第一列为 设备号

第二列为 次设备号

第三列为 设备名称

第四列为 成功完成读的总次数----- 读磁盘的次数

第五列为 合并读次数,为了效率可能会合并相邻的读和写,从而两次4K的读在它最终被处理到磁盘上之前可能会变成一次8K的读,才被计数(和排队),因此只有一次I/O操作。

第六列为 读扇区的次数

第七列为 读花的时间(ms),这是所有读操作所花费的毫秒数(用__make_request()到end_that_request_last()测量)

第八列到第十一列分别是写

第十二列为 I/O的当前进度,只有这个域应该是0,如果这个值为0,同时write_complete read_complete io_processing 一直不变可能就就是IO hang了。

第十三列为 输入输入花的时间(ms),花在I/O操作上的毫秒数,这个域会增长只要field 9不为0。

第十四列为 输入/输出操作花费的加权毫秒数,

注:

zabbix中磁盘使用情况就是从diskstats采集,磁盘使用率计算方式为:

两次采集的输入/输出操作花费的毫秒数之差 / 采集间隔时间

例如:第一次采集输入/输出操作花费的毫秒数为90258834,间隔10秒后采集的值为90258710

那么磁盘使用率为 (90258710ms - 90258834ms)/ 10*1000ms = 0.0124,也就是1.24%

4.16.2 iostat里面的io百分比

IO的各指标计算方法:https://blog.csdn.net/qu1993/article/details/105702991/

iostat和iowait详细解析:https://www.cnblogs.com/549294286/p/6561900.html

%iowait = (cpu idle time)/(all cpu time)

4.17 运行一个shell脚本怎样调试,怎样看到执行的整个过程,中间有一句错了后面还会不会执行,怎样解决

4.17.1 脚本调试

sh -n/-x/-c:https://blog.csdn.net/weixin_42167759/article/details/80700719

-n/-x/-c

-n 只读取shell脚本,但不实际执行

-x 进入跟踪方式,显示所执行的每一条命令

-c “string” 从strings中读取命令

sh -x xxx.sh 加上-x会显示错在哪,显示脚本里面的内容,并且还会报错,显示过程

在shell中,默认当某行命令执行出错之后,后面的命令会继续执行,这会导致后面的代码会出现不可预知的错误,所以当我们的shell程序出错时,应该立即停止执行shell程序。

解决:

在shell文件中加上set -e(当执行语句的状态码不为0时,直接退出程序。)

但有时候又需要关掉set -e(如判断目录是否存在时会直接退出程序)

set -x #启动"-x"选项

要跟踪的程序段

set +x #关闭"-x"选项

输出调式信息:https://www.ibm.com/developerworks/cn/linux/l-cn-shell-debug/

trap命令,

tee命令,

4.17.2 调试器bashdb

bashdb:http://bashdb.sourceforge.net/

bashdb -debug 脚本名

l 列出当前行以下的10行

- 列出正在执行的代码行的前面10行

. 回到正在执行的代码行

w 列出正在执行的代码行前后的代码

/pat/ 向后搜索pat

?pat?向前搜索pat

查看帮助 debug类

[root@mysql tmp]# bashdb -h

Usage:bashdb [OPTIONS] <script_file>Runs bash <script_file> under a debugger.options:-h | --help Print this help.-q | --quiet Do not print introductory and quiet messages.-A | --annotate LEVEL Set the annotation level.-B | --basename Show basename only on source file listings.(Needed in regression tests)--highlight {dark|light} Use dark or light background ANSI terminal sequencesyntax highlighting| --no-highlightDon't use ANSI terminal sequences for syntaxhighlight--highlight | --no-highlightUse or don't use ANSI terminal sequences for syntaxhighlight--init-file FILE Source script file FILE. Similar to bash'scorresponding option. This option can be givenseveral times with different files.-L | --library DIRECTORYSet the directory location of library helper file: /usr/share/bashdb/dbg-main.sh-c | --command STRING Run STRING instead of a script file-n | --nx | --no-init Don't run initialization files.-S | --style STYLE Run use pygments STYLE for formatting source code--tty | --terminal DEV Set to terminal in debugger output to DEVDEV can also be &1 for STDOUT-T | --tempdir DIRECTORYUse DIRECTORY to store temporary files-V | --version Print the debugger version number.-X | --trace Set line tracing similar to set -x-x | --eval-command CMDFILEExecute debugger commands from CMDFILE.

4.18 free

4.18.1 free

buffer/cache:https://www.cnblogs.com/ultranms/p/9254160.html

free命令可以显示Linux系统中空闲的、已用的物理内存及swap内存,及被内核使用的buffer

参数

[root@mysql ~]# free --helpUsage:free [options]Options:-b, --bytes show output in bytes 以Byte为单位显示内存使用情况-k, --kilo show output in kilobytes 以KB为单位显示内存使用情况-m, --mega show output in megabytes 以MB为单位显示内存使用情况-g, --giga show output in gigabytes 以GB为单位显示内存使用情况--tera show output in terabytes 以太字节为单位显示内存使用情况-h, --human show human-readable output--si use powers of 1000 not 1024-l, --lohi show detailed low and high memory statistics-t, --total show total for RAM + swap-s N, --seconds N repeat printing every N seconds-c N, --count N repeat printing N times, then exit-w, --wide wide output--help display this help and exit-V, --version output version information and exit

简单实例

[root@mysql ~]# freetotal used free shared buff/cache available

Mem: 999696 85448 403028 6852 511220 740156

Swap: 1048572 0 1048572

[root@mysql ~]# free -mtotal used free shared buff/cache available

Mem: 976 83 393 6 499 723

Swap: 1023 0 1023

[root@mysql ~]# free -htotal used free shared buff/cache available

Mem: 976M 83M 393M 6.7M 499M 723M

Swap: 1.0G 0B 1.0G

字段解释:

Mem 行(第二行)是内存的使用情况。

Swap 行(第三行)是交换空间的使用情况。

total 列显示系统总的可用物理内存和交换空间大小。

used 列显示已经被使用的物理内存和交换空间。

free 列显示还有多少物理内存和交换空间可用使用。

shared 列显示被共享使用的物理内存大小。

buff/cache 列显示被 buffer 和 cache 使用的物理内存大小。

available 列显示还可以被应用程序使用的物理内存大小。

available = free + buffer + cache

4.18.2 /proc/meminfo 文件

其实 free 命令中的信息都来自于 /proc/meminfo 文件

[root@mysql ~]# cat /proc/meminfo

MemTotal: 999696 kB

MemFree: 403412 kB

MemAvailable: 740768 kB

Buffers: 16632 kB

Cached: 438216 kB

SwapCached: 0 kB

Active: 210600 kB

Inactive: 286932 kB

Active(anon): 43124 kB

Inactive(anon): 6408 kB

Active(file): 167476 kB

Inactive(file): 280524 kB

Unevictable: 0 kB

Mlocked: 0 kB

SwapTotal: 1048572 kB

SwapFree: 1048572 kB

Dirty: 0 kB

Writeback: 0 kB

AnonPages: 42712 kB

Mapped: 28452 kB

Shmem: 6852 kB

Slab: 56504 kB

SReclaimable: 34160 kB

SUnreclaim: 22344 kB

KernelStack: 3568 kB

PageTables: 5852 kB

NFS_Unstable: 0 kB

Bounce: 0 kB

WritebackTmp: 0 kB

CommitLimit: 1548420 kB

Committed_AS: 242444 kB

VmallocTotal: 34359738367 kB

VmallocUsed: 176120 kB

VmallocChunk: 34359310332 kB

HardwareCorrupted: 0 kB

AnonHugePages: 10240 kB

HugePages_Total: 0

HugePages_Free: 0

HugePages_Rsvd: 0

HugePages_Surp: 0

Hugepagesize: 2048 kB

DirectMap4k: 57216 kB

DirectMap2M: 991232 kB

DirectMap1G: 0 kB

4.19 一个脚本重定向到另一个文件,另一个文件却是空的是怎么回事(排除权限问题)

stdout:https://cloud.tencent.com/developer/ask/172310

如果你用print要输出文本,其参数flush可能对你有帮助:

print('Hello, World', flush=True)

有一种情况,就是重定向的输入和输出都是同一文件

测试结果如下:

[root@mysql tmp]# cat 1.txt

a

b

c

[root@mysql tmp]# cat 1.txt > 1.txt

cat: 1.txt: input file is output file

[root@mysql tmp]# cat 1.txt

所以得到以下结论如果文件不存在会自动创建,如果存在会清空。

4.20 shell重定向有几种方式,标准错误输出,一条命令不要他的输出与标准错误输出怎么做

4.20.1 shell重定向

详解shell中的几种标准输出重定向方式:https://blog.csdn.net/yuki5233/article/details/85091314

重定向的方式:

>

tee

| 文件描述符 | 代表的含义 | 默认情况 | 对应文件句柄位置 |

|---|---|---|---|

| 1 | 标准正确输出(standard output) | 输出到屏幕(即控制台) | /proc/self/fd/1 |

| 2 | 标准错误输出(error output) | 输出到屏幕(即控制台) | /proc/self/fd/2 |

| 0 | 标准输入(standard input) | 从键盘获得输入 | /proc/self/fd/0 |

一条命令不要他的输出与标准错误输出: >/dev/null 2>&1

>/dev/null

这条命令等同于 1>/dev/null,作用是将标准正确输出1重定向到/dev/null中。 /dev/null代表linux的空设备文件,所有往这个文件里面写入的内容都会丢失,俗称“黑洞”。那么执行了>/dev/null之后,标准正确输出的内容就会不再存在,没有任何地方能够找到输出的内容。

2>&1

这条命令用到了重定向绑定,采用&可以将两个输出绑定在一起。这条命令的作用是将标准错误输出和标准正确输出输出同用一个文件描述符,说人话就是标准错误输出和标准正确输出重定向到同一个地方。

linux在执行shell命令之前,就会确定好所有的输入输出位置,并且从左到右依次执行重定向的命令,所以>/dev/null 2>&1的作用就是让标准正确输出重定向到/dev/null中(丢弃标准正确输出),然后标准错误输出由于重用了标准正确输出的描述符,所以标准错误输出也会被定向到了/dev/null中,标准错误输出同样也被丢弃了。执行了这条命令之后,该条shell命令将不会输出任何信息到控制台,也不会有任何信息输出到文件中。

4.20.2 >/dev/null 2>&1 和 2>&1 >/dev/null区别

结论:

| 命令 | 标准正确输出 | 标准错误输出 |

|---|---|---|

| >/dev/null 2>&1 | 丢弃 | 丢弃 |

| 2>&1 >/dev/null | 丢弃 | 屏幕 |

4.21 top显示内容,第一行最后三个的含义,负载是什么意思,为什么不能超过核心数,是什么原理

top各部分详解:https://blog.csdn.net/weixin_46108954/article/details/105492945

load average: 0.09, 0.03, 0.01

load average后面的三个数分别是1分钟、5分钟、15分钟的负载情况。

系统平均负载被定义为在特定时间间隔内运行队列中的平均进程数

load average数据是每隔5秒钟检查一次活跃的进程数,然后按特定算法计算出的数值。

计算公式:load(t) = load(t-1) e^(-5/60) + n (1 - e^(-5/60)),迭代计算,其中n为run-queue length。

采用此公式的好处:局部的load抖动不会对load average造成重大影响,使其平滑。

Load Average的值应该小于CPU个数X核数X0.7

可以将CPU负载理解为车道的负载,对单车道而言:

- 如果路面上的车不多,没有占满车道,那么load < 1;

- 如果占满了车道,load = 1;

- 如果车道外面还有车在等待,load > 1;

判断load average状态:

1、状态为R和D的任务

2、CPU使用率高,IO无作业, Load Average低,系统反应颠簸

这种场景,通常是计算密集型任务,即大量生成耗时短的计算任务。

3、CPU使用率低,IO等待, Load Average高,系统不卡

这种场景,通常是IO密集型任务,如果大量请求都集中于相同的IO设备,超出设备的响应能力,会造成任务在运行队列里堆积等待,也就是D状态的进程堆积,那么此时Load Average就会飙高。

4、CPU使用率低,IO繁忙, Load Average低,系统卡

这种场景,通常是低频大文件读写,由于请求数量不大,所以任务都处于R状态,Load Average数值反映了当前运行的任务数,不会飙升,IO设备处于满负荷工作状态,导致系统响应能力降低。

5、CPU使用率高,IO繁忙/等待, Load Average高,系统卡

这种场景,通常是服务混部,即IO、计算密集型任务混部在一起,相当于CPU、IO都处于高负荷状态,那么Load Average 自然很高。

例子:

我们举个例子:高速公路收费站10个车道,那当有1-9辆车在不同的通道通过时,认为收费站的load<1;当正好10辆车在不同的通道时,load=1;当超过10辆车(假设每个通道是均匀有车)时,load>1.假设有100辆车,每个通道10辆,那就说明能有10辆车能过去,另外90辆车则需要等待。此时收费站的load为100/10=10. 这个10的负载表示系统当前满负荷运转,且还有相当于90%的满负载的请求在等待。

4.22 查看磁盘读写的MB用什么参数,查看tps用什么参数

查看TPS和吞吐量信息

[root@localhost ~]# iostat -d -m 1 2

Linux 3.10.0-693.el7.x86_64 (mg-nginx-02) 07/02/2020 _x86_64_ (1 CPU)Device: tps MB_read/s MB_wrtn/s MB_read MB_wrtn

sda 23.65 0.64 0.25 170 67

scd0 0.07 0.00 0.00 1 0Device: tps MB_read/s MB_wrtn/s MB_read MB_wrtn

sda 0.00 0.00 0.00 0 0

scd0 0.00 0.00 0.00 0 0

sar -b 1 2 但这个没有以单位来查看

4.23 linux socket建立和关闭的原理

1、socket是对TCP/UDP协议的封装,Socket本身并不是协议,而是一个调用接口,通过Socket,我们才能使用TCP/UDP协议。

2、UDP和TCP都是通过『IP地址』与『TCP Port』形成一个『Socket』,透过此Socket与对方的Socket形成一个『Socket Pair』进行通讯。

3、通常我们在说到网络编程时默认是指TCP编程,即用socket函数创建一个socket用于TCP通讯.

4、UDP和TCP编程区别:http://blog.chinaunix.net/uid-26421509-id-3814684.html

TCP编程的服务器端一般步骤是:

1、创建一个socket,用函数socket();

2、设置socket属性,用函数setsockopt(); * 可选

3、绑定IP地址、端口等信息到socket上,用函数bind();

4、开启监听,用函数listen();

5、接收客户端上来的连接,用函数accept();

6、收发数据,用函数send()和recv(),或者read()和write();

7、关闭网络连接;

8、关闭监听;

TCP编程的客户端一般步骤是:

1、创建一个socket,用函数socket();

2、设置socket属性,用函数setsockopt();* 可选

3、绑定IP地址、端口等信息到socket上,用函数bind();* 可选

4、设置要连接的对方的IP地址和端口等属性;

5、连接服务器,用函数connect();

6、收发数据,用函数send()和recv(),或者read()和write();

7、关闭网络连接;

总结:客户端的connect在三次握手的第二次返回,而服务器端的accept在三次握手的第三次返回。

与之对应的UDP编程步骤要简单许多,分别如下:

UDP编程的服务器端一般步骤是:

1、创建一个socket,用函数socket();

2、设置socket属性,用函数setsockopt();* 可选

3、绑定IP地址、端口等信息到socket上,用函数bind();

4、循环接收数据,用函数recvfrom();

5、关闭网络连接;

UDP编程的客户端一般步骤是:

1、创建一个socket,用函数socket();

2、设置socket属性,用函数setsockopt();* 可选

3、绑定IP地址、端口等信息到socket上,用函数bind();* 可选

4、设置对方的IP地址和端口等属性;

5、发送数据,用函数sendto();

6、关闭网络连接;

优雅关闭和强制关闭:https://blog.51cto.com/3layer/1119552

关闭socket和关闭TCP连接的区别,关闭TCP连接是指TCP协议层的东西,就是两个TCP端之间交换了一些协议包(FIN,RST等),具体的交换过程可以看TCP协议,这里不详细描述了。而关闭socket是指关闭用户应用程序中的socket句柄,释放相关资源。但是当用户关闭socket句柄时会隐含的触发TCP连接的关闭过程。

TCP连接的关闭过程有两种,一种是优雅关闭(graceful close),一种是强制关闭(hard close或abortive close)。所谓优雅关闭是指,如果发送缓存中还有数据未发出则其发出去,并且收到所有数据的ACK之后,发送FIN包,开始关闭过程。而强制关闭是指如果缓存中还有数据,则这些数据都将被丢弃,然后发送RST包,直接重置TCP连接。

socket的底层创建与关闭:https://blog.csdn.net/jiaomingliang/article/details/45950591?utm_medium=distribute.pc_relevant_t0.none-task-blog-BlogCommendFromMachineLearnPai2-1.nonecase&depth_1-utm_source=distribute.pc_relevant_t0.none-task-blog-BlogCommendFromMachineLearnPai2-1.nonecase

二者的区别

close-----关闭本进程的socket id,但链接还是开着的,用这个socket id的其它进程还能用这个链接,能读或写这个socket id。

shutdown–破坏了socket 链接,读的时候可能侦探到EOF结束符,写的时候可能会收到一个SIGPIPE信号,这个信号可能直到socket buffer被填充了才收到,shutdown有一个关闭方式的参数,0 不能再读,1不能再写,2 读写都不能。

4.24 如何知道系统block大小

1.tune2fs命令查看block size大小:

tune2fs命令:http://blog.chinaunix.net/uid-7530389-id-2050094.html

[root@localhost ~]# tune2fs -l /dev/sda2 | grep 'Block size'

Block size: 4096

2.stat命令查看block size大小:

[root@localhost ~]# stat / | grep 'IO Block'Size: 4096 Blocks: 8 IO Block: 4096 directory

3.dumpe2fs命令查看block size大小:

[root@localhost ~]# dumpe2fs /dev/sda2 | grep 'Block size'

dumpe2fs 1.42.9 (28-Dec-2013)

Block size: 4096

4.25 proc伪文件系统

proc文件系统是一种伪文件系统,只存在于内存中,只有内核运行时才会动态生成里面的内容。

创建proc文件的流程:https://blog.csdn.net/kokodudu/article/details/16368107

1、创建目录

struct proc_dir_entry *proc_mkdir(const char *name, struct proc_dir_entry *parent);

类似于mkdir()函数,name是目录名,如“example_dir”,parent是要创建的目录的父目录名(若parent = NULL则创建在/proc目录下)。

2、创建proc文件:

struct proc_dir_entry *create_proc_entry( const char *name, mode_t mode, struct proc_dir_entry *parent );

create_proc_entry函数用于创建一个一般的proc文件,其中name是文件名,比如“hello”,mode是文件模式,parent是要创建的proc文件的父目录(若parent = NULL则创建在/proc目录下)。

读回调函数原型:int mod_read( char *page, char **start, off_t off, int count, int *eof, void *data );

写回调函数原型:int mod_write( struct file *filp, const char __user *buff, unsigned long len, void *data );

4.26 LVM逻辑卷

物理卷(Phsical Volume):物理区段(Physical Extent)

卷组(Volume Group)

逻辑卷(Logic Volume):逻辑区段(Logical Extent)

4.26.1 逻辑卷优点

- 在磁盘池中添加磁盘和分区,对现有的文件系统进行在线扩展

- 用一个 160GB 磁盘替换两个 80GB 磁盘,而不需要让系统离线,也不需要在磁盘之间手工转移数据

- 当存储空间超过所需的空间量时,从池中去除磁盘,从而缩小文件系统

- 使用快照(snapshot)执行一致性的备份

4.26.2 创建逻辑卷过程

1)分区

2)制作物理卷 pvcreate 分区名

3)创建卷组 vgcreate -s PE大小 卷组名 物理卷路径

4)创建逻辑卷 lvcreate -n 逻辑卷名称 -L 逻辑卷大小 卷组名称

5)格式化 挂载

4.26.3 扩大缩小逻辑卷/卷组

1)卷组

删除卷组 vgremove 卷组

扩大卷组 vgextend 卷组名称 物理卷路径

缩小卷组 vgreduce

2)逻辑卷

扩大逻辑卷

1、扩逻辑卷 lvextend -L 1G /dev/mapper/plvg-lvmovie

2、扩文件系统 resize2fs /dev/mapper/plvg-lvmovie

缩小逻辑卷

1、卸载逻辑卷 umount /dev/mapper/plvg-lvmusic

2、文件系统检查 e2fsck -f /dev/mapper/plvg-lvmusic

3、缩小文件系统 resize2fs /dev/mapper/plvg-lvmusic 100M

4、缩小逻辑卷 lvreduce -L 100M /dev/mapper/plvg-lvmusic

5、挂载 mount -t ext4 /dev/mapper/plvg-lvmusic /mnt/music

扩大/缩小逻辑卷

lvresize -L +100M

lvresize -L -100M

4.26.4 备份逻辑卷

1)给源逻辑卷做快照卷

lvcreate -s -L 100M -n musicsnap /dev/mapper/plvg-lvmusic

2)将快照卷挂载

mount -t ext4 /dev/mapper/plvg-musicsnap /mnt/musicsnap

3)备份快照卷内容

tar / rsync

4)卸载

umount /mnt/musicsnap

5)删除快照卷

lvremove /dev/mapper/plvg-musicsnap

4.26.5 /扩容的方法

参照4.26.2和4.26.3

1)分区(partprobe更新分区)

2)制作物理卷 pvcreate 分区名

3)查看系统中的卷组 vgdisplay

4)扩大卷组 vgextend 卷组名 分区名

5)扩大逻辑卷 lvextend -L +1G 根目录挂载点

6)扩大文件系统 resize2fs 根目录挂载点

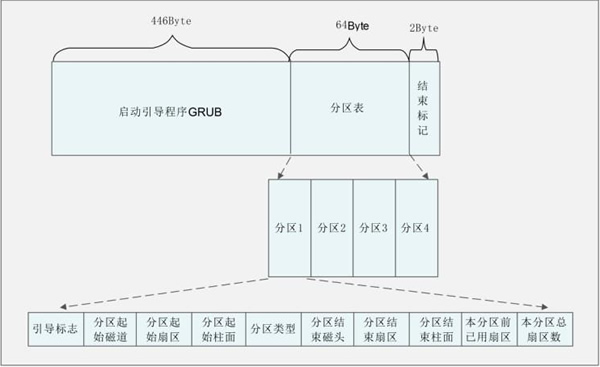

4.27 MBR的作用

MBR:http://www.found5.com/view/987.html

MBR 也就是主引导记录,位于硬盘的 0 磁道、0 柱面、1 扇区中,主要记录了启动引导程序和磁盘的分区表。

其中 446 Byte 安装了启动引导程序,其后 64 Byte 描述分区表,最后的 2 Byte 是结束标记。

MBR 中最主要的功能就是存储启动引导程序。

4.28 /var/log目录下有什么,日志分别是哪些服务的,日志里面的内容是什么

4.28.1 /var/log/目录

4.28.2 日志有哪些服务

/var/log/日志:https://www.cnblogs.com/kaishirenshi/p/7724963.html

1、/var/log/messages — 包括整体系统信息,其中也包含系统启动期间的日志。此外,mail,cron,daemon,kern和auth等内容也记录在var/log/messages日志中。

2、/var/log/dmesg — 包含内核缓冲信息(kernel ring buffer)。在系统启动时,会在屏幕上显示许多与硬件有关的信息。可以用dmesg查看它们。

3、/var/log/boot.log — 包含系统启动时的日志。

4、 /var/log/daemon.log — 包含各种系统后台守护进程日志信息。

5、 /var/log/yum.log – 包括安装或yum命令清除软件包的日志。

6、/var/log/kern.log – 包含内核产生的日志,有助于在定制内核时解决问题。

7、/var/log/lastlog — 记录所有用户的最近信息。这不是一个ASCII文件,因此需要用lastlog命令查看内容。

8、 /var/log/maillog /var/log/mail.log — 包含来着系统运行电子邮件服务器的日志信息。例如,sendmail日志信息就全部送到这个文件中。

9、/var/log/user.log — 记录所有等级用户信息的日志。

10、 /var/log/Xorg.x.log — 来自X的日志信息。

11、 /var/log/alternatives.log – 更新替代信息都记录在这个文件中。

12、/var/log/btmp – 记录所有失败登录信息。使用last命令可以查看btmp文件。例如,”last -f /var/log/btmp | more“。

13、/var/log/cups — 涉及所有打印信息的日志。

14、/var/log/anaconda.log — 在安装Linux时,所有安装信息都储存在这个文件中。

15、/var/log/cron — 每当cron进程开始一个工作时,就会将相关信息记录在这个文件中。

16、 /var/log/secure — 包含验证和授权方面信息。例如,sshd会将所有信息记录(其中包括失败登录)在这里。

17、 /var/log/wtmp或/var/log/utmp — 包含登录信息。使用wtmp可以找出谁正在登陆进入系统,谁使用命令显示这个文件或信息等。

4.28.3 日志里面的内容

例子

[root@mg-nginx-02 ~]# tail /var/log/yum.log

Apr 07 11:56:04 Installed: gcc-4.8.5-39.el7.x86_64

Apr 07 11:56:05 Updated: e2fsprogs-1.42.9-17.el7.x86_64

Apr 07 11:56:05 Updated: 1:openssl-1.0.2k-19.el7.x86_64

4.29 文件系统中文件查找快的原因

4.29.1 查找文件

二进制文件:which -a which #查看命令which所在位置,-a参数表示找出所有

二进制文件,源代码文件或帮助文档:whereis命令用于搜索程序的二进制文件,源代码文件或帮助文档

查找任何文件:locate (从一个系统数据库进行文件查找,而不需要遍历磁盘,速度极快)

查找任何文件:find (需要遍历磁盘文件,因此查找速度较慢,但较丰富)

具体用法就不了吧。。。

4.29.2 查找快的原因(可以从最底层的磁盘讲起)

inode:https://www.cnblogs.com/junjind/p/8999349.html

每一个文件都有一个对应的inode。

inode:文件的元信息,比如文件的属性,创建时间,权限,所占的块大小,数量等等

文件的存储方式:

文件是存储在硬盘上的。硬盘的最小单位是扇区,每个扇区的大小为512字节。

多个扇区整合成一个块(block),一个块的大小为4k。

所以硬盘在分区的时候会分为两个区域,一个区域存放数据,一个区域存放inode信息。

这里可以提软硬链接的区别。。。

4.30 raid0与raid1的区别,raid5一块盘坏了会怎么办,具体原理

4.30.1 raid0与raid1的区别

raid 0 条带

RAID 0可以把多块硬盘连成一个容量更大的硬盘群,可以提高磁 盘的性能和吞吐量。RAID 0没有冗余或错误修复能力,成本低,要求至少两个磁盘,一般只是在那些对数 据安全性要求不高的情况下才被使用。

raid 1 镜像

把一个磁盘的数据镜像到另一个磁盘上,在不影响性能情况下最大限度的保证系统的可靠性和可修复性上,具有很高的数据冗余能力,但磁盘利用 率为1/2,故成本最高,多用在保存关键性的重要数据的场合。RAID 1的操作方式是把用户写入硬盘的数据百分之百地自动复制到另外一个硬盘上。

4.30.2 raid5一块盘坏,怎么处理

硬raid:拔出损坏的硬盘,插入新的硬盘

软raid:参考4.30.3

4.30.3 软raid

mdadm [模式] <RAID设备名称> [选项] [成员设备名称]

- 准备磁盘或分区,以分区为例。

sdb1,2,3,5,大小200M - 使用mdadm命令创建RAID10,名称为"/dev/md0"。

mdadm -C /dev/md0 -n 4 -l 10 -a yes /dev/sdb{1,2,3,5} - 查看RAID设备信息

mdadm -D /dev/md0

损坏磁盘阵列及修复:

-

通过manage模式可以模拟阵列中的设备损坏

mdadm --manage /dev/md[0-9] [–add 设备名] [–remove 设备名] [–fail 设备名] -

模拟/dev/sdb1损坏

mdadm --manage /dev/md0 --fail /dev/sdb1 模拟sdb1损坏

查看raid状态 mdadm -D /dev/md0

由于4块磁盘组成的raid10允许损坏一块盘,且还允许坏第二块非对称盘。所以这里损坏了一块盘后raid10是可以正常工作的。

mdadm --manage /dev/md0 --remove /dev/sdb1

损坏的磁盘拔出,然后向raid中加入新的磁盘即可

mdadm --manage /dev/md0 --add /dev/sdb5

4.31 一条定时任务没有执行,有几种可能的原因

1)被执行的脚本没有执行权限:chmod 755 xxx.sh

2)被执行的脚本编码有问题,这种情况直接转码:dos2unix xxx.sh

3)crontab权限问题到/var/adm/cron/下一看,文件cron.allow和cron.deny是否存在

4.32 网卡的配置文件在哪里

/etc/sysconfig/network-scripts/ifcfg-ens33

4.33 怎样查看占用80端口的进程

1、首先查看下 80 端口的使用情况

netstat -tulnp | grep 80

查看80端口被被占用的PID

2、根据这个PID 来查看被哪个程序在使用

netstat -aux|grep PID

4.34 怎样查看系统的性能

top

sar

uptime

w

ntop

iftop

ntop

4.35 怎样看磁盘的io

几种查看磁盘io的方法:https://www.cnblogs.com/diaozhaojian/p/10497773.html

top

vmstat

iostat

4.36 awk怎样把最后一列拎出来

$NF

awk详解:https://blog.csdn.net/weixin_41477980/article/details/89511954

$0 表示整个当前行

$1 每行第一个字段

NF 字段数量变量

NR 每行的记录号,多文件记录递增

FNR 与NR类似,不过多文件记录不递增,每个文件都从1开始

\t 制表符

\n 换行符

FS BEGIN时定义分隔符

RS 输入的记录分隔符, 默认为换行符(即文本是按一行一行输入)

~ 匹配,与==相比不是精确比较

!~ 不匹配,不精确比较

== 等于,必须全部相等,精确比较

!= 不等于,精确比较

&& 逻辑与

|| 逻辑或

+ 匹配时表示1个或1个以上

/[0-9][0-9]+/ 两个或两个以上数字

/[0-9][0-9]*/ 一个或一个以上数字

FILENAME 文件名

OFS 输出字段分隔符, 默认也是空格,可以改为制表符等

ORS 输出的记录分隔符,默认为换行符,即处理结果也是一行一行输出到屏幕

-F'[:#/]' 定义三个分隔符

4.37 介绍一个w,uptime,iostat,top,ps

Linux系统负载:https://blog.csdn.net/weixin_34346099/article/details/92191458

[root@localhost ~]# w21:54:31 up 23:05, 2 users, load average: 0.53, 0.55, 0.35

USER TTY FROM LOGIN@ IDLE JCPU PCPU WHAT

root tty1 Thu22 23:05m 0.01s 0.01s -bash

root pts/0 192.168.217.1 Thu22 7.00s 0.15s 0.00s w[root@localhost ~]# uptime21:54:35 up 23:05, 2 users, load average: 0.49, 0.54, 0.35[root@localhost ~]# iostat

Linux 3.10.0-693.el7.x86_64 (mg-nginx-02) 07/03/2020 _x86_64_ (1 CPU)avg-cpu: %user %nice %system %iowait %steal %idle0.11 0.00 0.10 0.05 0.00 99.73Device: tps kB_read/s kB_wrtn/s kB_read kB_wrtn

sda 0.40 2.52 8.03 209111 665634

scd0 0.00 0.01 0.00 1028 0[root@localhost ~]# toptop - 21:56:26 up 23:07, 2 users, load average: 0.52, 0.60, 0.40

Tasks: 74 total, 1 running, 73 sleeping, 0 stopped, 0 zombie

%Cpu(s): 0.0 us, 0.0 sy, 0.0 ni,100.0 id, 0.0 wa, 0.0 hi, 0.0 si,

KiB Mem : 999696 total, 85896 free, 314324 used, 599476 buff/c

KiB Swap: 1048572 total, 1048572 free, 0 used. 503504 avail PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ [root@localhost ~]# ps aux

USER PID %CPU %MEM VSZ RSS TTY STAT START TIME COMMAND

PS

user:运行该进程的用户

PID:标志数

CPU:占用CPU百分比

MEM:占用内存百分比

VSZ:虚拟内存的大小

RSS:真实内存的大小

TTY:从哪里启动的 tty1 tty2

STAT:进程状态,S表示休眠Sleep,s表示主进程或叫父进程,<表示优先级比较高,N表示进程是低优先级,+表示是前台运行的进程,R正在运行running,L内存中被锁Lock,l多线程,Z僵尸进程,X死掉的进程,T暂停的进程,D不能中断的进程

START:启动日期

Time:一共用了CPU时间

COMMAND:进程的名称

4.38 ab web服务器性能测试

使用ab命令进行web server性能测试:https://www.cnblogs.com/leaves1024/p/10437335.html

ApacheBench 是 Apache 服务器自带的一个web压力测试工具,简称ab。**ab命令会创建多个并发访问线程,模拟多个访问者同时对某一URL地址进行访问。**它的测试目标是基于URL的,因此,既可以用来测试Apache的负载压力,也可以测试nginx、lighthttp、tomcat、IIS等其它Web服务器的压力。ab命令对发出负载的计算机要求很低,既不会占用很高CPU,也不会占用很多内存,但却会给目标服务器造成巨大的负载,可能会造成目标服务器资源耗尽,严重时可能会导致死机。

-n requests Number of requests to perform 请求总数

-c concurrency Number of multiple requests to make 并发数

-t timelimit Seconds to max. wait for responses

-b windowsize Size of TCP send/receive buffer, in bytes

4.39 查看某服务是否打开

ps aux | grep linux

lsof -i :PID

netstat -tnlp

4.40 一次性关闭某服务的所有进程

killall命令

killall命令用于终止某个指定名称的服务所对应的全部进程,格式为"killall[参数][服务名称]"。

4.41 查看进程的命令

ps:https://www.cnblogs.com/leeyongbard/p/10301206.html

top:4.21

htop:https://www.cnblogs.com/zangfans/p/8595000.html

4.42 Linux杀死僵尸进程

僵尸进程:https://www.cnblogs.com/lvcisco/p/9836701.html

4.43 文本处理/替换

4.43.1 awk文本处理

awk面试题:https://blog.51cto.com/14230436/2378328

1)处理以下⽂件内容,将域名取出并计数排序:

http://www.baidu.com/index.html

http://www.baidu.com/1.html

http://post.baidu.com/index.html

http://mp3.baidu.com/index.html

http://www.baidu.com/3.html

http://post.baidu.com/2.html

得到如下结果:

域名出现的次数 域名

3 www.baidu.com

2 post.baidu.com

1 MP3.baidu.com

如何取出?

awk -F “/” ‘{print $3}’|sort|uniq -c|sort -nr

2)统计apaceh的access.log中访问量最多的5个ip

cat access_log | awk ’{print $1}’ | sort | uniq -c | sort -nr | head -5

3)使⽤awk统计当前主机的并发访问量

netstat -ant | awk '/^tcp/ {++state[$NF]} END {for(key in state) print key,"\t",state[key]}'

4)已知文件a.txt,第一列是文件名,第二列是版本号,打印出每个文件最大的版本号一行

a.txt

file 100

dir 11

file 100

dir 11

file 102

dir 112

file 120

dir 119

测试

[root@localhost tmp]# awk '{if(code[$1]<$2) code[$1]=$2}END{for (i in code) print i,code[i] }' a.txt

dir 119

file 120

5)把2列和3列的值作为新的第5列,第5列的平均值为avg5,求第5列中大于avg5的行数。

b.txt

3 5 6 7

2 3 1 0

4 5 6 9

2 3 4 4

2 2 1 0

4 5 0 9

测试

[root@localhost tmp]# awk '{x+=$2+$3;a[NR]=$2+$3}END{y=x/NR;for(i in a){if(y<a[i])z++}print z}' b.txt

3

4.43.2 sed文本替换

1)把/tmp目录以及子目录下所有以扩展名为.sh结尾的文件包含old的字符串全部替换为new

find /tmp -type f -name "*.sh" | xargs sed "s/old/new/g"

2)把多行用,拼接成一行

[root@localhost tmp]#sed 'H;${x;s/\n/,/g;s/^,//};$!d' test

4.43.3 用多种方法获取一个特殊字段并计数

awk ‘{++a[$1]}END{for (i in a) print i,a[i]}’

grep -o ’ xxx’ | wc -c

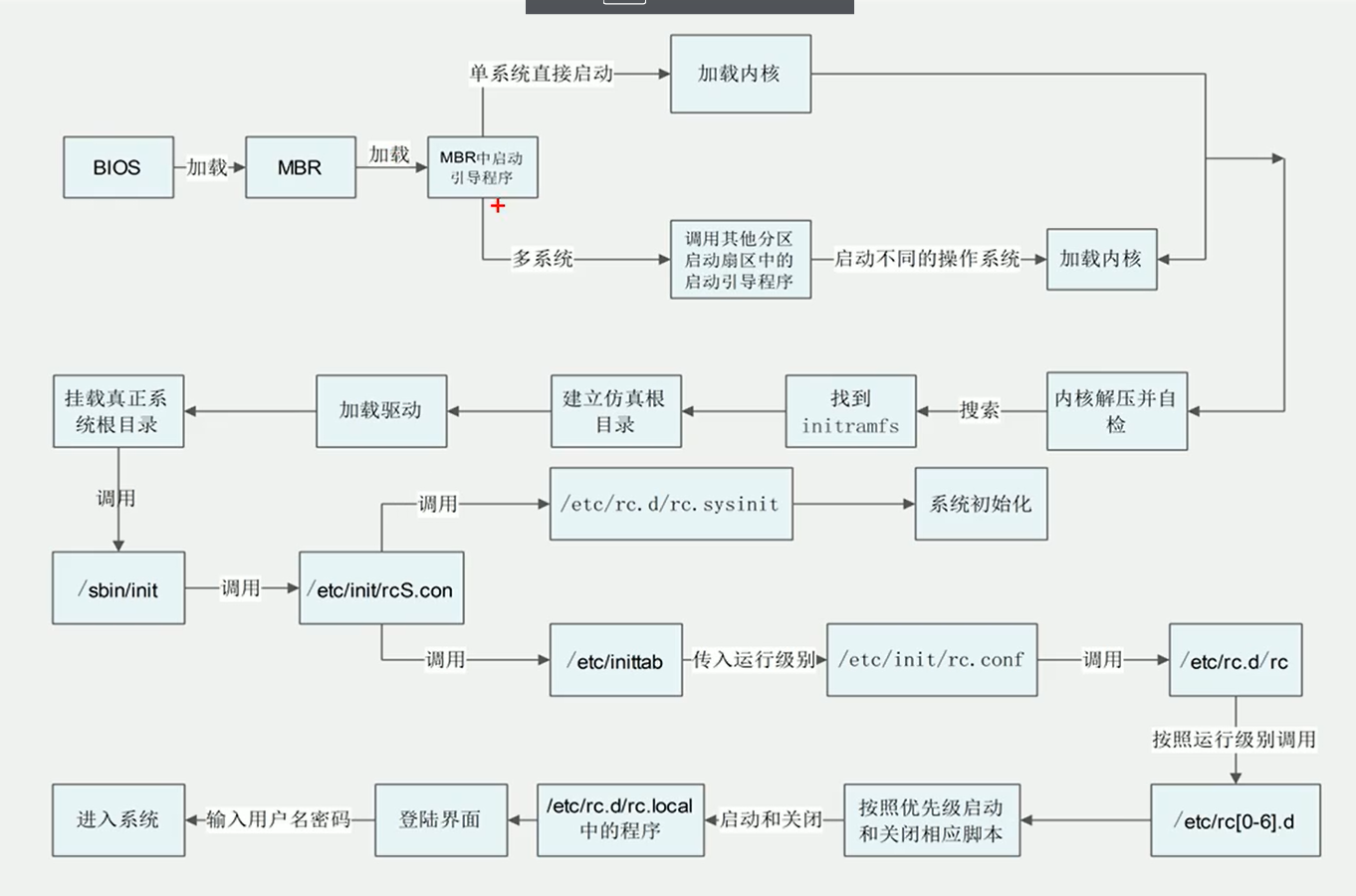

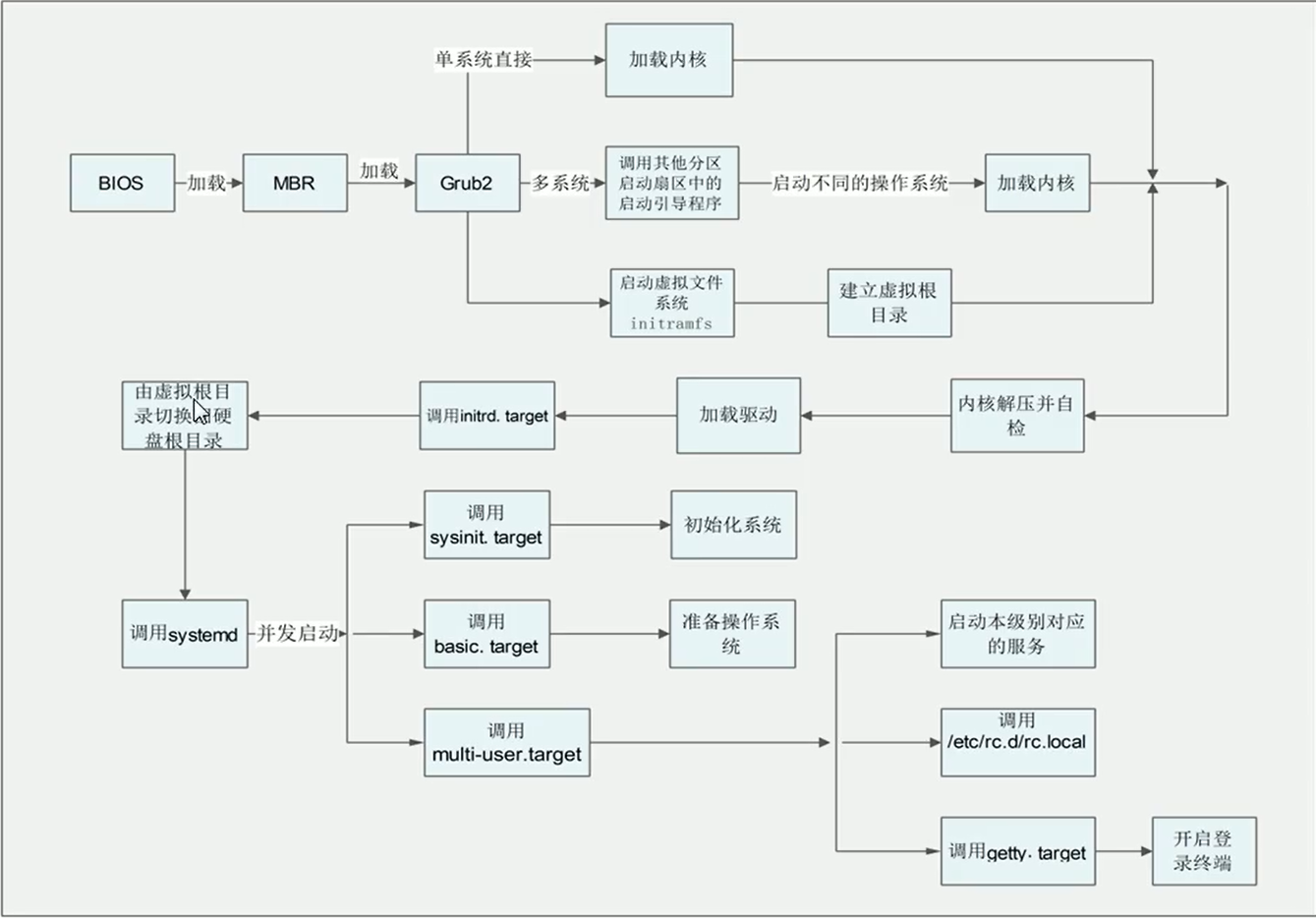

4.44 系统启动流程

1.centos6

2.centos7

4.44.1 加电检查了那些外围设备,检查的顺序

POST:检查外围硬件设备是否正常,比如内存,cpu,显卡,键盘

4.44.2 bios存在的意义

Basic Input Output System

- 功能

一组固化到计算机内主板上一个ROM芯片上的程序,

它保存着计算机最重要的基本输入输出的程序、开机后自检程序和系统自启动程序,它可从CMOS中读写系统设置的具体信息。

其主要功能是为计算机提供最底层的、最直接的硬件设置和控制。

开启cpu虚拟化支持

启动项调整

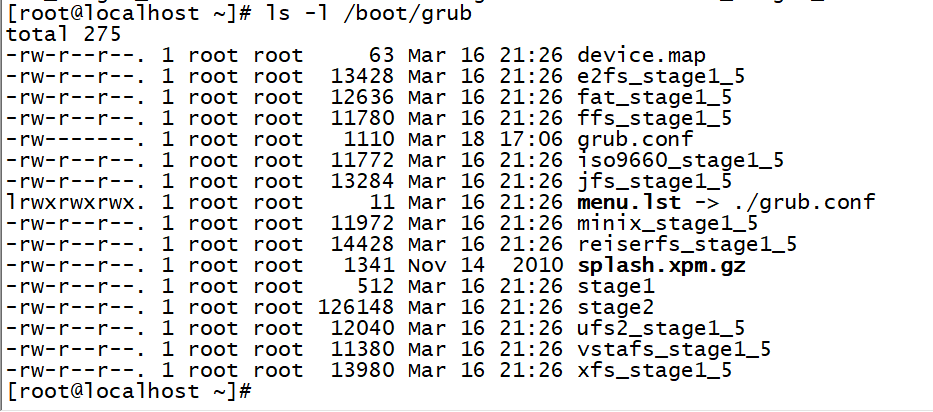

4.44.3 /boot分区的内容

4.44.4 如何找到grub

删掉/boot/grub/grub.conf 配置文件,重启会自动进入grup界面

/boot/grub/grub.conf 文件内容

default=0 默认启动标题编号

timeout=5 超时时间

splashimage=(hd0,0)/grub/splash.xpm.gz 背景图片

hiddenmenu 隐藏菜单下的参数

title CentOS 6 (2.6.32-642.el6.x86_64) 标题名称 编号从0

root (hd0,0) 指定内核所在分区的物理位置 hd0,0硬盘第一个分区

kernel /vmlinuz-2.6.32-642.el6.x86_64 ro root=UUID=391fb1e7-63fc-4642-95ce-375d26494c8d rd_NO_LUKS rd_NO_LVM LANG=en_US.UTF-8 rd_NO_MD SYSFONT=latarcyrheb-sun16 crashkernel=auto KEYBOARDTYPE=pc KEYTABLE=us rd_NO_DM rhgb quiet

ro 以只读方式挂载根文件系统

root=指定真正的根文件系统的位置

rhgb (redhat graphical boot)以进度条方式启动

quiet 静默模式,不显示硬件自检信息initrd /initramfs-2.6.32-642.el6.x86_64.img 提供内核初始化环境 --> 临时根文件系统

(课外扩展) 解压initramfs

4.44.5 grub和grub2的区别

GRUB 的最主要作用都是将内核加载到内存并运行。

1.配置文件的名称改变了。在grub中,配置文件为grub.conf或menu.lst(grub.conf的一个软链接),在grub2中改名为grub.cfg。

2.grub2增添了许多语法,更接近于脚本语言了,例如支持变量、条件判断、循环。

3.grub2中,设备分区名称从1开始,而在grub中是从0开始的。

4.grub2使用img文件,不再使用grub中的stage1、stage1.5和stage2。

5.支持图形界面配置grub,但要安装grub-customizer包,epel源提供该包。

6.在已进入操作系统环境下,不再提供grub命令,也就是不能进入grub交互式界面,只有在开机时才能进入。

7.在grub2中没有了好用的find命令。

4.44.6 initramfs文件的作用

1.initrd: initial Ramdisk

/linuxrc文件,基于ramdisk技术,文件系统(ext2等)镜像文件 ————> cpio格式镜像文件

在内核启动完成后把它复制到/dev/ram块设备中, 作为内核加载真正根文件系统的过渡根文件系统

2.initramfs: initial RAM file system

init文件,cpio格式镜像文件

在内核启动完成后把它复制到rootfs中,作为内核初始的根文件系统,完成挂载系统真正的根文件系统

常见的内存文件系统有:

rootfs,ramfs,ramdisk,tmpfs

1.rootfs:内核启动的初始始根文件系统,大部分linux系统正常运行后都会安装另外的文件系统,然后忽略rootfs

2.ramfs:基于内存的文件系统.ramfs文件系统没有容量大小的限制,它可以根据需要动态增加容量.直接利用了内核的磁盘高速缓存

3.ramdisk:基于ram的块设备,占据一块固定的内存,事先要使用特定的工具比如mke2fs格式化,还需要一个文件系统驱动来读写其上的文件空间固定导致容量有限,要想装入更多的文件需要重新格式化.Linux的块设备缓冲特性, ram disk上的数据被拷贝到page cache(对于文件数据)和dentry cache(对于目录项),导致内存浪费,它可能不停的动态增长直到耗尽系统的全部内存,所以只有root或授权用户允许使用ramfs

4.tmpfs:增加了容量大小的限制 + 允许把数据写入交换分区.由于增加了这两个特性,tmpfs允许普通用户使用

initramfs:https://www.cnblogs.com/CHYI1/p/5551022.html

initrd和initramfs的区别:https://blog.51cto.com/linuxzj/1409882

4.44.7 grub的各个阶段功能

分三个阶段stage1/stage1.5/stage2

这些功能都是放在/boot/grub目录下:

1.从上面可以看到,stage1文件的大小正好是512字节,事实上stage1文件其实就是MBR中bootloader的备份,而之所以是bootloader而不是MBR, 是因为这个文件的前446字节才是和MBR是一样的。

2.上面可以看到stage1_5形式的文件有很多,如e2fs_stage1_5、jfs_stage1_5等等,这些都是stage1.5阶段的文件,只是每个都针对不同的文件系统格式,而e2fs_stage1_5是默认的(ext系列的文件系统)。当stage1加载stage1.5之后,就访问文件系统目录,从而可以加载stage2文件。

而stage1.5要执行,是通过stage1加载它

3.平时开机启动的时候看到的Grub选项、信息,还有修改GRUB背景等功能都是stage2提供的,stage2会去读入/boot/grub/grub.conf或者menu.lst等配置文件。

4.44.8 内核是什么,功能,如何修改内核参数

- 内核的功能

进程管理

内核负责创建和销毁进程,并处理它们与外部世界的联系(输入和输出)

内存管理

内核为所有进程的每一个都在有限的可用资源上建立了一个虚拟地址空间

文件系统

内核在非结构化的硬件之上建立了一个结构化的文件系统, 结果是文件的抽象非常多地在整个系统中应用

设备控制

内核中必须嵌入系统中出现的每个外设的驱动, 从硬盘驱动到键盘和磁带驱动器

网络管理

所有的路由和地址解析问题都在内核中实现.

修改网络协议参数

/etc/sysctl.conf

1) /proc/sys/net/ipv4/icmp_echo_ignore_all

echo "1" > /proc/sys/net/ipv4/icmp_echo_ignore_all

2) 修改/etc/sysctl.conf

添加一行内容:net.ipv4.icmp_echo_ignore_all = 值

3) 立即生效

sysctl -p

Linux内核的功能:https://blog.csdn.net/u010889616/article/details/47868887

Linux修改内核的参数:https://zhuanlan.zhihu.com/p/43341587

4.45 linux如何获取对方的arp(arping)

arp:https://blog.csdn.net/qq_27627195/article/details/81942378

- arp -a

- cat /proc/net/arp

注:只有建立过连接的才能查看到对端mac,如果查找不到直接在命令行中ping一下对方ip即可查看到对方mac地址。

4.46 linux绑定双网卡,数据怎么走

双网卡bond:https://blog.csdn.net/dongfei2033/article/details/76222742

网卡bond是通过多张网卡绑定为一个逻辑网卡,实现本地网卡的冗余,带宽扩容和负载均衡,在生产场景中是一种常用的技术。

bond的模式

-

mode=0(balance-rr):表示负载分担round-robin,并且是轮询的方式比如第一个包走eth0,第二个包走eth1,直到数据包发送完毕。

-

mode=1(active-backup):表示主备模式,即同时只有1块网卡在工作。

-

mode=2(balance-xor)(平衡策略):表示XOR Hash负载分担,和交换机的聚合强制不协商方式配合。(需要xmit_hash_policy,需要交换机配置port channel)

-

mode=3(broadcast)(广播策略):表示所有包从所有网络接口发出,这个不均衡,只有冗余机制,但过于浪费资源。此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题。需要和交换机的聚合强制不协商方式配合。

-

mode=4(802.3ad)(IEEE 802.3ad 动态链接聚合):表示所有包从所有网络接口发出,这个不均衡,只有冗余机制,但过于浪费资源。此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题。需要和交换机的聚合强制不协商方式配合。

-

mode=5(balance-tlb)(适配器传输负载均衡):是根据每个slave的负载情况选择slave进行发送,接收时使用当前轮到的slave。该模式要求slave接口的网络设备驱动有某种ethtool支持;而且ARP监控不可用。

-

mode=6(balance-alb)(适配器适应性负载均衡):在5的tlb基础上增加了rlb(接收负载均衡receiveload balance).不需要任何switch(交换机)的支持。接收负载均衡是通过ARP协商实现的.

总结:mode5和mode6不需要交换机端的设置,网卡能自动聚合。mode4需要支持802.3ad。mode0,mode2和mode3理论上需要静态聚合方式。

4.47 文件权限linux 发行版本

4.47.1 文件权限

drwxr-xr-x.

十一位,

- 第1位 文件类型

- 第2~4位 拥有者

- 第5~7位 拥有组

- 第8~10位 所有人

- 第11位 acl

4.47.2 发行版本

linux 发行版一般称 GNU/linux,其中 GNU 与 linux 分别代表什么;

GNU:gnu’s not unix

gnu通用公共许可证(gnu general public license,gpl)

大致分为两类:

商业公司维护的发行版本,以著名的 Red Hat 为代表;

社区组织维护的发行版本,以 Debian 为代表。

| 版本名称 | 网 址 | 特 点 | 软件包管理器 |

|---|---|---|---|

| Debian Linux | www.debian.org | 开放的开发模式,且易于进行软件包升级 | apt |

| Fedora Core | www.redhat.com | 拥有数量庞人的用户,优秀的社区技术支持. 并且有许多创新 | up2date(rpm),yum (rpm) |

| CentOS | www.centos.org | CentOS 是一种对 RHEL(Red Hat Enterprise Linux)源代码再编译的产物,由于 Linux 是开发源代码的操作系统,并不排斥样基于源代码的再分发,CentOS 就是将商业的 Linux 操作系统 RHEL 进行源代码再编译后分发,并在 RHEL 的基础上修正了不少已知的漏洞 | rpm |

| SUSE Linux | www.suse.com | 专业的操作系统,易用的 YaST 软件包管理系统 | YaST(rpm),第三方 apt (rpm)软件库(repository) |

| Mandriva | www.mandriva.com | 操作界面友好,使用图形配置工具,有庞大的社区进行技术支持,支持 NTFS 分区的大小变更 | rpm |

| KNOPPIX | www.knoppix.com | 可以直接在 CD 上运行,具有优秀的硬件检测和适配能力,可作为系统的急救盘使用 | apt |

| Gentoo Linux | www.gentoo.org | 高度的可定制性,使用手册完整 | portage |

| Ubuntu | www.ubuntu.com | 优秀已用的桌面环境,基于 Debian 构建 | apt |

4.48 常见的http状态码

http状态码:https://blog.csdn.net/weixin_46108954/article/details/105171569

1开头的表示服务器收到请求并需要请求这继续处理;

2开头的成功响应,表示成功处理了请求;

3开头的重定向,引导浏览器跳转到另一个资源页面;

4开头表示请求出错,妨碍了服务器的处理,服务器会返回一个状态码解释到底是什么错误;

5开头的表示服务器错误,并不是请求者的原因;

常见的HTTP相应状态码

200:请求被正常处理

204:请求被受理但没有资源可以返回

206:客户端只是请求资源的一部分,服务器只对请求的部分资源执行GET方法,相应报文中通过Content-Range指定范围的资源。

301:永久性重定向

302:临时重定向

303:与302状态码有相似功能,只是它希望客户端在请求一个URI的时候,能通过GET方法重定向到另一个URI上

304:发送附带条件的请求时,条件不满足时返回,与重定向无关

307:临时重定向,与302类似,只是强制要求使用POST方法

400:请求报文语法有误,服务器无法识别

401:请求需要认证

403:请求的对应资源禁止被访问

404:服务器无法找到对应资源

500:服务器内部错误

503:服务器正忙

499 client has closed connection:这很有可能是因为服务器端处理的时间过长,客户端“不耐烦”了。

4.49 netstat常见的选项

[root@localhost ~]# netstat --help

usage: netstat [-vWeenNcCF] [<Af>] -r netstat {-V|--version|-h|--help}netstat [-vWnNcaeol] [<Socket> ...]netstat { [-vWeenNac] -I[<Iface>] | [-veenNac] -i | [-cnNe] -M | -s [-6tuw] } [delay]-r, --route display routing table-I, --interfaces=<Iface> display interface table for <Iface>-i, --interfaces display interface table-g, --groups display multicast group memberships-s, --statistics display networking statistics (like SNMP)-M, --masquerade display masqueraded connections-v, --verbose be verbose-W, --wide don't truncate IP addresses-n, --numeric don't resolve names--numeric-hosts don't resolve host names--numeric-ports don't resolve port names--numeric-users don't resolve user names-N, --symbolic resolve hardware names-e, --extend display other/more information-p, --programs display PID/Program name for sockets-o, --timers display timers-c, --continuous continuous listing-l, --listening display listening server sockets-a, --all display all sockets (default: connected)-F, --fib display Forwarding Information Base (default)-C, --cache display routing cache instead of FIB-Z, --context display SELinux security context for sockets<Socket>={-t|--tcp} {-u|--udp} {-U|--udplite} {-S|--sctp} {-w|--raw}{-x|--unix} --ax25 --ipx --netrom<AF>=Use '-6|-4' or '-A <af>' or '--<af>'; default: inetList of possible address families (which support routing):inet (DARPA Internet) inet6 (IPv6) ax25 (AMPR AX.25) netrom (AMPR NET/ROM) ipx (Novell IPX) ddp (Appletalk DDP) x25 (CCITT X.25)

tulnp

ant

4.50 维护一个系统的安全有哪几方面

linux安全配置:https://wenku.baidu.com/view/b84eaf87b9d528ea81c7790d.html

-

用户管理:删除默认创建的一些用户/用户组

-

服务管理:升级服务软件版本,关闭系统不使用的服务

-

系统文件权限:修改部分系统文件的权限

-

系统优化:虚拟内存优化

-

日志管理:系统引导/运行/操作日志

-

防火墙:iptables四表五链 firewalld

4.51 linux常用的分区格式

ext2

ext3

ext4

xfs

jfs

btrfs

文件系统比较:https://wenku.baidu.com/view/4c18863543323968011c92f7.html

大小:KB,MB,GB,TB,PB,EB,ZB

| 文件系统 | 最大卷容量 | 最大文件容量 | 目录结构 | 文件分配 | ACLS | checksum | 透明压缩 | 透明加密 | online defrag | shrink | 特性 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| btrfs | 16EB | 16EB | B tree | extents | Yes | Yes | Yes | No | Yes | Yes | SSD |

| ext3 | 32TB | 2TB | list/tree | bitmap/table | Yes | No | No | No | No | Yes | |

| ext4 | 1EB | 16TB | list/Htree | bitmap/extents | Yes | journal | No | No | Yes | Yes | |

| jfs | 32PB | 4PB | B tree | bitmap/extents | Yes | No | No | No | Yes | No | |

| reiserfs | 16TB | 8TB | B+ tree | bitmap | No | No | No | No | No | offline resize | |

| reiser4 | 8TB | dancing B* tree | No | No | Plugin | Plugin | Yes | offline | |||

| xfs | 16EB | 8EB | B+ tree | extents | Yes | No | No | No | Yes | No | |

| ntfs | 256TB | 16TB | B+ tree | bitmap | ACLS only | No | Yes | Yes | Yes | Yes | Stream |

| zfs | 16EB | 16EB | hash table | Yes | Yes | Yes | Yes | Yes | No |

4.52 PYTHON

4.52.1 python的内存回收机制

垃圾回收机制:https://blog.csdn.net/xiongchengluo1129/article/details/80462651

垃圾回收机制详解:https://www.jianshu.com/p/1e375fb40506

python采用的是引用计数机制为主,标记-清除和分代收集两种机制为辅的策略

引用计数法的原理是每个对象维护一个ob_ref,用来记录当前对象被引用的次数,也就是来追踪到底有多少引用指向了这个对象,当发生以下四种情况的时候,该对象的引用计数器+1

- 对象被创建 a=14

- 对象被引用 b=a

- 对象被作为参数,传到函数中 func(a)

- 对象作为一个元素,存储在容器中 List={a,”a”,”b”,2}

与上述情况相对应,当发生以下四种情况时,该对象的引用计数器-1

- 当该对象的别名被显式销毁时 del a

- 当该对象的引别名被赋予新的对象, a=26

- 一个对象离开它的作用域,例如 func函数执行完毕时,函数里面的局部变量的引用计数器就会减一(但是全局变量不会)

- 将该元素从容器中删除时,或者容器被销毁时。

注:当指向该对象的内存的引用计数器为0的时候,该内存将会被Python虚拟机销毁。

GC系统的主要任务:

- 为新生成的对象分配内存

- 识别那些垃圾对象

- 从垃圾对象那回收内存。

4.52.2 python中+=

-

两个值相加,然后返回值给符号左侧的变量

-

用于字符串连接(变量值带引号,数据类型为字符串)

4.52.3 元组与列表的区别

python列表元组区别:https://www.jianshu.com/p/f40f095f4e20

(1)列表:一个大仓库,你可以随时往里边添加和删除任何东西。

(2)元组:封闭的列表,一旦定义,就不可改变(不能添加、删除或修改)只读。

注:都可以使用下标索引来访问元组中的值

4.52.4 python中有哪些复制的方式

深浅拷贝:https://blog.csdn.net/qq_39290225/article/details/90451324

其他复制方式:https://blog.csdn.net/weixin_43305880/article/details/82891465?utm_medium=distribute.pc_relevant_t0.none-task-blog-BlogCommendFromMachineLearnPai2-1.nonecase&depth_1-utm_source=distribute.pc_relevant_t0.none-task-blog-BlogCommendFromMachineLearnPai2-1.nonecase

深浅拷贝的区别:https://blog.csdn.net/weixin_40576010/article/details/88848189

>>> import copy>>> a = [[10], 20]

>>> b = a[:] #<---切片复制

>>> c = list(a) #<---构造函数

>>> d = a * 1 #<---乘一赋值

>>> e = a.copy() #<---copy方法

>>> f = copy.deepcopy(a) #<---deepcopy函数>>> a.append(21)

>>> a[0].append(11)>>> for i in (a,b,c,d,e,f):

... print(id(i),id(i[0]),i)

...

1827373681032 1827374668936 [[10, 11], 20, 21]

1827372347144 1827374668936 [[10, 11], 20]

1827373679752 1827374668936 [[10, 11], 20]

1827373674184 1827374668936 [[10, 11], 20]

1827373668744 1827374668936 [[10, 11], 20]

1827376420168 1827372453448 [[10], 20]

注:只有使用copy.deepcopy(a)方法得到的新列表f才是包括子列表在内的完全复制。

4.52.5 Django的模块使用情况

Django:https://www.cnblogs.com/ssyfj/p/9087545.html

Django应用:https://blog.csdn.net/lftaoyuan/article/details/79014251

from django.contrib.auth import authenticate,login,logout #可以用来做登录验证

from django.contrib.auth.decorators import login_required #装饰器,用于对用户是否登录进行验证

Django教程:https://www.liujiangblog.com/course/django/2

Django教程:https://code.ziqiangxuetang.com/django/django-tutorial.html

Django教程:https://www.runoob.com/django/django-tutorial.html

4.52.6 Python和shell的区别

Python和shell的区别 :https://www.cnblogs.com/chengjian-physique/p/9152988.html

Python和shell的思考:https://blog.csdn.net/monkey_d_meng/article/details/6173055

python定义和使用只需要使用变量名

shell定义变量只需要变量名,而使用变量的值则需要加$符号

python中没有数组的概念,但是有list,tuple,dict等可以代替其功能

shell中只有一维数组

4.52.7 python的常见数据类型

数据类型详解:https://blog.csdn.net/aurora_1970s/article/details/105519821

1.数字类型:整型(int),浮点型(float),复数类型(complex)

2.字符串类型:str

3.逻辑类型:bool True False

4.列表类型:list [ ] 有序可修改

5.元组类型:tuple () 有序不可修改

6.集合类型:set { } 无序不重复

7.字典类型:dict {key:value} 无序

五、数据库知识

5.1 部署数据库的整一个流程

5.1.1 安装

1)源码安装:

1.安装依赖

2.安装cmake、编译mysql

3.初始化mysql(mysql_install_db)

4.启动mysql服务

2)二进制安装:

1.创建用户、目录,修改权限

2.下载mysql.tar.gz,解压

3.配置my.cnf文件

4.初始化mysql(mysqld --initialize)

5.进入mysql修改密码

5.1.2 部署多实例

1.创建多实例目录

2.在不同的实例目录中编辑my.cnf

3.初始化数据文件

4.启动mysql多实例

5.登录到mysql多实例

6.关闭mysql多实例

5.1.3 主从复制

1.master开启binlog

并添加不同的server-id=101

2.创建用户并授权

show master status;

3.主库全量备份

4.从库做全量恢复

5.从库设定主库信息

6.从库开启主从复制

show slave status\G

5.2 数据库大数据类型

| 数据类型 | 含义(有符号) |

|---|---|

| int(m) | 4个字节 范围(-2147483648~2147483647) |

| float(m,d) | 单精度浮点型 8位精度(4字节) m总个数,d小数位 |

| double(m,d) | 双精度浮点型 16位精度(8字节) m总个数,d小数位 |

| decimal(m,d) | 参数m<65 是总个数,d<30且 d<m 是小数位。 |

| char(n) | 固定长度,最多255个字符 |

| varchar(n) | 可变长度,最多65535个字节 |

5.3 数据库存储引擎

mysql的存储引擎包括:MyISAM、 InnoDB、BDB、MEMORY、MERGE、EXAMPLE、NDB Cluster、ARCHIVE、CSV、BLACKHOLE、FEDERATED等,其中InnoDB和BDB提供事务安全表,其他存储引擎都是非事务安全表。

| 特点 | MYISAM | BDB | MEMORY | INNODB | ARCHIVE |

|---|---|---|---|---|---|

| 存储限制 | 没有 | 没有 | 有 | 64TB | 没有 |

| 事务安全 | 支持 | 支持 | |||

| 锁机制 | 表锁 | 页锁 | 表锁 | 行锁 | 行锁 |

| B树索引 | 支持 | 支持 | 支持 | 支持 | |

| 哈希索引 | 支持 | 支持 | |||

| 全文索引 | 支持 | ||||

| 集群索引 | 支持 | ||||

| 数据缓存 | 支持 | 支持 | |||

| 索引缓存 | 支持 | 支持 | 支持 | ||

| 数据可压缩 | 支持 | 支持 | |||

| 空间使用 | 低 | 低 | N/A | 高 | 非常低 |

| 内存使用 | 低 | 低 | 中等 | 高 | 低 |

| 批量插入的速度 | 高 | 高 | 高 | 高 | 非常高 |

| 支持外键 |

innodb和myisam的主要区别

1、事务的支持不同

innodb支持事务

myisam不支持事务

2、锁粒度

innodb行锁

myisam表锁

3、存储空间

innodb既缓存索引文件又缓存数据文件

myisam只能缓存索引文件

4、存储结构

(myisam:数据文件的扩展名为.MYD myData ,索引文件的扩展名是.MYI myIndex)

(innodb:所有的表都保存在同一个数据文件里面 即为.Ibd)

5、统计记录行数

(myisam:保存有表的总行数,select count() from table;会直接取出出该值)

(innodb:没有保存表的总行数,select count() from table;就会遍历整个表,消耗相当大)

5.4 索引

索引进阶:https://blog.csdn.net/q402057192/article/details/87695498

1.索引是什么?有什么作用?

索引是对数据库表中一个或多个列的值进行排序的数据结构,以协助快速查询、更新数据库表中数据。索引的实现通常使用B_TREE及其变种。索引加速了数据访问,因为存储引擎不会再去扫描整张表得到需要的数据;相反,它从根节点开始,根节点保存了子节点的指针,存储引擎会根据指针快速寻找数据。

2.索引的优缺点

优点:

- 大大加快数据的检索速度,这也是创建索引的最主要的原因;

- 加速表和表之间的连接;

- 在使用分组和排序子句进行数据检索时,同样可以显著减少查询中分组和排序的时间;

- 通过创建唯一性索引,可以保证数据库表中每一行数据的唯一性;

缺点:

-

时间方面:创建索引和维护索引要耗费时间,具体地,当对表中的数据进行增加、删除和修改的时候,索引也要动态的维护,这样就降低了数据的维护速度;

-

空间方面:索引需要占物理空间。

3.为什么说B+tree比B 树更适合实际应用中操作系统的文件索引和数据库索引

- B+tree的磁盘读写代价更低:B+tree的内部结点并没有指向关键字具体信息的指针(红色部分),因此其内部结点相对B 树更小。如果把所有同一内部结点的关键字存放在同一盘块中,那么盘块所能容纳的关键字数量也越多。一次性读入内存中的需要查找的关键字也就越多,相对来说IO读写次数也就降低了;

- B+tree的查询效率更加稳定:由于内部结点并不是最终指向文件内容的结点,而只是叶子结点中关键字的索引,所以,任何关键字的查找必须走一条从根结点到叶子结点的路。所有关键字查询的路径长度相同,导致每一个数据的查询效率相当;

- 数据库索引采用B+树而不是B树的主要原因:B+树只要遍历叶子节点就可以实现整棵树的遍历,而且在数据库中基于范围的查询是非常频繁的,而B树只能中序遍历所有节点,效率太低。

4.什么情况下设置了索引但无法使用?

-

以“%(表示任意0个或多个字符)”开头的LIKE语句,模糊匹配;

-

OR语句前后没有同时使用索引;

-

数据类型出现隐式转化(如varchar不加单引号的话可能会自动转换为int型);

-

对于多列索引,必须满足 最左匹配原则 (eg:多列索引col1、col2和col3,则 索引生效的情形包括 col1或col1,col2或col1,col2,col3)

5.什么样的字段适合创建索引?

- 经常作查询选择的字段

- 经常作表连接的字段

- 经常出现在order by, group by, distinct 后面的字段

6.创建索引时需要注意什么?

- 非空字段:应该指定列为NOT NULL,除非你想存储NULL。在mysql中,含有空值的列很难进行查询优化,因为它们使得索引、索引的统计信息以及比较运算更加复杂。你应该用0、一个特殊的值或者一个空串代替空值;

- 取值离散大的字段:(变量各个取值之间的差异程度)的列放到联合索引的前面,可以通过count()函数查看字段的差异值,返回值越大说明字段的唯一值越多字段的离散程度高;

- 索引字段越小越好:数据库的数据存储以页为单位一页存储的数据越多一次IO操作获取的数据越大效率越高。

5.5 SQL查询语句的优化

1、在表中建立索引,优先考虑where、group by使用到的字段。

2、尽量避免使用select *,返回无用的字段会降低查询效率。如下:

SELECT * FROM t

优化方式:使用具体的字段代替*,只返回使用到的字段。

3、尽量避免使用in 和not in,会导致数据库引擎放弃索引进行全表扫描。如下:

SELECT * FROM t WHERE id IN (2,3)

SELECT * FROM t1 WHERE username IN (SELECT username FROM t2)

优化方式:如果是连续数值,可以用between代替。如下:

SELECT * FROM t WHERE id BETWEEN 2 AND 3

如果是子查询,可以用exists代替。如下:

SELECT * FROM t1 WHERE EXISTS (SELECT * FROM t2 WHERE t1.username = t2.username)

4、尽量避免使用or,会导致数据库引擎放弃索引进行全表扫描。如下:

SELECT * FROM t WHERE id = 1 OR id = 3

优化方式:可以用union代替or。如下:

SELECT * FROM t WHERE id = 1

UNION

SELECT * FROM t WHERE id = 3

(PS:如果or两边的字段是同一个,如例子中这样。貌似两种方式效率差不多,即使union扫描的是索引,or扫描的是全表)

5、尽量避免在字段开头模糊查询,会导致数据库引擎放弃索引进行全表扫描。如下:

SELECT * FROM t WHERE username LIKE ‘%li%’

优化方式:尽量在字段后面使用模糊查询。如下:

SELECT * FROM t WHERE username LIKE ‘li%’

6、尽量避免进行null值的判断,会导致数据库引擎放弃索引进行全表扫描。如下:

SELECT * FROM t WHERE score IS NULL

优化方式:可以给字段添加默认值0,对0值进行判断。如下:

SELECT * FROM t WHERE score = 0

7、尽量避免在where条件中等号的左侧进行表达式、函数操作,会导致数据库引擎放弃索引进行全表扫描。如下:

SELECT * FROM t2 WHERE score/10 = 9

SELECT * FROM t2 WHERE SUBSTR(username,1,2) = ‘li’

优化方式:可以将表达式、函数操作移动到等号右侧。如下:

SELECT * FROM t2 WHERE score = 10*9

SELECT * FROM t2 WHERE username LIKE ‘li%’

8、当数据量大时,避免使用where 1=1的条件。通常为了方便拼装查询条件,我们会默认使用该条件,数据库引擎会放弃索引进行全表扫描。如下:

SELECT * FROM t WHERE 1=1

优化方式:用代码拼装sql时进行判断,没where加where,有where加and。

5.6 数据库触发器

创建触发器。创建触发器语法如下:

CREATE TRIGGER trigger_name trigger_time trigger_event

ON tbl_name FOR EACH ROW trigger_stmt

其中trigger_name标识触发器名称,用户自行指定;

trigger_time标识触发时机,用before和after替换;

trigger_event标识触发事件,用insert,update和delete替换;

tbl_name标识建立触发器的表名,即在哪张表上建立触发器;

trigger_stmt是触发器程序体;触发器程序可以使用begin和end作为开始和结束,中间包含多条语句;

例子

CREATE TRIGGER trig_insert_user

AFTER INSERT

ON test.student FOR EACH ROW

BEGININSERT into test.user set username=NEW.name;

END

5.7 当创建好一个数据库,都生成了哪些文件,这些文件的本质是什么

oracle:https://docs.oracle.com/cd/E11882_01/server.112/e25494/create.htm#ADMIN11085

Oracle数据库至少执行以下操作:

- 为数据库创建数据文件

- 创建数据库的控制文件

- 为数据库创建重做日志文件并建立

ARCHIVELOG模式 - 创建

SYSTEM表空间 - 创建

SYSAUX表空间 - 创建数据字典

- 设置将数据存储在数据库中的字符集

- 设置数据库时区

- 挂载并打开数据库以供使用

mysql

有一个DatabaseName文件夹

接着创建TableName表的话会有三个文件 db.opt 文件、TableName.frm 文件、TableName .idb文件

db.opt 文件:字符集与排序规则信息

TableName.frm 文件:整个表框架的定义,但是它保存的是密文

TableName .idb文件:表中的数据

5.8 MySQL主从不一致出现报错要怎么解决,简历主从的命令是什么

MySQL主从不同步问题分析与处理思路:http://blog.itpub.net/31015730/viewspace-2154414/

mysql主从同步梳理:https://www.cnblogs.com/kevingrace/p/6261111.html

5.8.1 slave运行过慢不能与master同步,也就是MySQL数据库主从同步延迟

MySQL数据库slave服务器延迟的现象是非常普遍的,MySQL复制允许从机进行SELECT操作,但是在实际生产环境下,由于从机延迟的关系,很难将读取操作转向到从机。这就导致了有了以下一些潜规则:“实时性要求不高的读取操作可以放到slave服务器,实时性要求高的读取操作放到master服务器”,“从机仅能做前一天的统计类查询”。

slave滞后即slave不能快速执行来自于master的所有事件,从而不能避免更新slave数据延迟。

mysql的master-slave架构中master仅做写入、更新、删除操作,slave做select操作。造成slave滞后的原因有很多。

slave同步延迟的原理

MySQL的主从复制都是单线程的操作,主库对所有DDL和DML产生的日志写进binlog,由于binlog是顺序写,所以效率很高。

Slave的IO Thread线程从主库中bin log中读取取日志。

Slave的SQL Thread线程将主库的DDL和DML操作事件在slave中重放。DML和DDL的IO操作是随机的,不是顺序的,成本高很多。

由于SQL Thread也是单线程的,如果slave上的其他查询产生lock争用,又或者一个DML语句(大事务、大查询)执行了几分钟卡住了,那么所有之后的DML会等待这个DML执行完才会继续执行,这就导致了延时。那么:主库上那个相同的DDL也会执行几分钟,为什么slave会延时?原因是master可以并发执行,而Slave_SQL_Running线程却不可以。

slave同步延迟的可能原因

1–slave的I/O线程推迟读取日志中的事件信息;最常见原因是slave是在单线程中执行所有事务,而master有很多线程可以并行执行事务。

2–带来低效连接的长查询、磁盘读取的I/O限制、锁竞争和innodb线程同步启动等。

3–Master负载;Slave负载

4–网络延迟

5–机器配置(cpu、内存、硬盘)