【CV-Paper 13】图像分割 02:U-Net-2015

论文原文:点击此处

论文下载:点击此处

论文被引:12052(08/03/2020)

论文年份:2015

文章目录

- U-Net: Convolutional Networks for Biomedical Image Segmentation

- Abstract

- 1 Introduction

- 2 Network Architecture

- 3 Training

- 3.1 Data Augmentation

- 4 Experiments

- 5 Conclusion

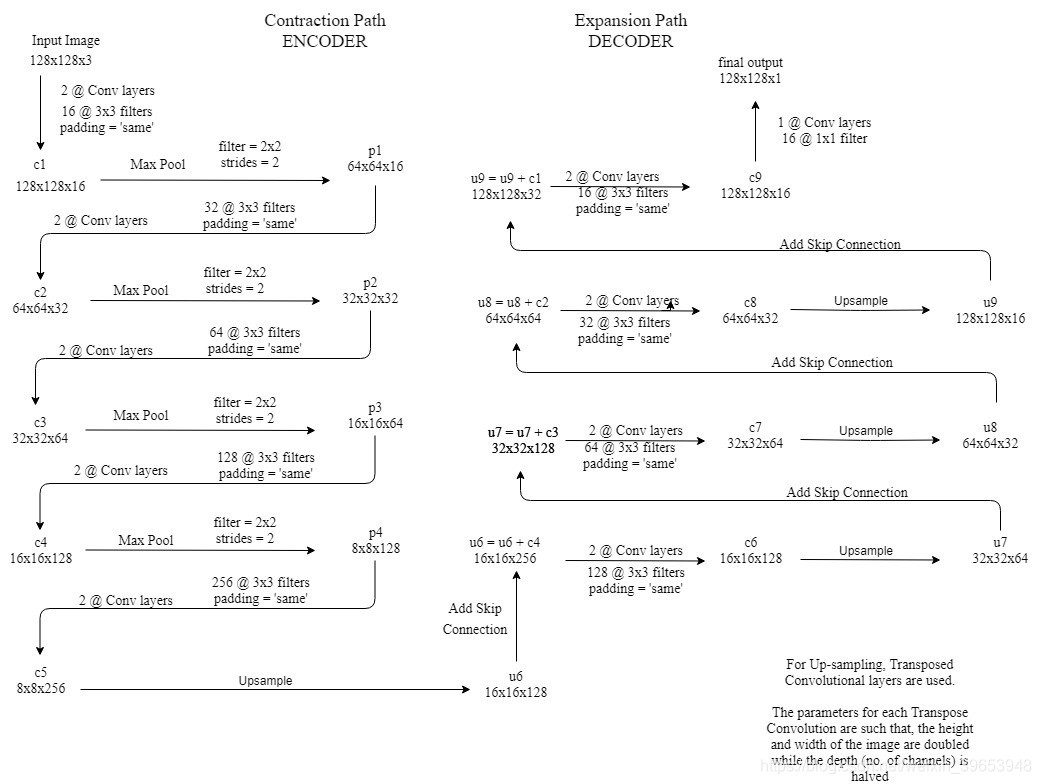

- U-Net Network Architecture

- Contraction path

- Expansion path

- U-net 网络详解

- Keras 代码实现

U-Net: Convolutional Networks for Biomedical Image Segmentation

Abstract

There is large consent that successful training of deep networks requires many thousand annotated training samples. In this paper, we present a network and training strategy that relies on the strong use of data augmentation to use the available annotated samples more efficiently. The architecture consists of a contracting path to capture context and a symmetric expanding path that enables precise localization. We show that such a network can be trained end-to-end from very few images and outperforms the prior best method (a sliding-window convolutional network) on the ISBI challenge for segmentation of neuronal structures in electron microscopic stacks. Using the same network trained on transmitted light microscopy images (phase contrast and DIC) we won the ISBI cell tracking challenge 2015 in these categories by a large margin. Moreover, the network is fast. Segmentation of a 512x512 image takes less than a second on a recent GPU. The full implementation (based on Caffe) and the trained networks are available at http://lmb.informatik.uni-freiburg.de/people/ronneber/u-net.

人们普遍同意,成功地训练深度网络需要数千个带注释的训练样本。 在本文中,我们提出了一种网络和训练策略,该策略依赖于数据增强的强大使用来更有效地使用可用的带注释的样本。 该结构包括一个用于捕获上下文的收缩路径和一个能够实现精确定位的对称扩展路径。 我们展示了这样的网络可以从很少的图像进行端到端训练,并且在ISBI挑战方面优于现有的最佳方法(滑动窗口卷积网络),可以对电子显微镜堆栈中的神经元结构进行分割。 使用在透射光显微镜图像(相差和DIC)上训练过的同一网络,我们在这些类别中赢得了2015年ISBI细胞跟踪挑战赛的冠军。 而且,网络速度很快。 在最新的GPU上,对512x512图像进行分割所需的时间不到一秒钟。 完整的实现(基于Caffe)和经过训练的网络可在http://lmb.informatik.uni-freiburg.de/people/ronneber/u-net上获得。

1 Introduction

In the last two years, deep convolutional networks have outperformed the state of the art in many visual recognition tasks, e.g. [7,3]. While convolutional networks have already existed for a long time [8], their success was limited due to the size of the available training sets and the size of the considered networks. The breakthrough by Krizhevsky et al. [7] was due to supervised training of a large network with 8 layers and millions of parameters on the ImageNet dataset with 1 million training images. Since then, even larger and deeper networks have been trained [12].

在过去的两年中,深度卷积网络在许多视觉识别任务中的表现超越了现有技术,比如[7,3]。 尽管卷积网络已经存在很长时间[8],但由于可用训练集的大小和所考虑网络的大小,卷积网络的成功受到限制。Krizhevsky等人[7]的突破是由于对具有8层的大型网络和具有100万个训练图像的ImageNet数据集上的数百万个参数进行了监督训练。从那时起,甚至更大更深的网络也得到了训练[12]。

The typical use of convolutional networks is on classification tasks, where the output to an image is a single class label. However, in many visual tasks, especially in biomedical image processing, the desired output should include localization, i.e., a class label is supposed to be assigned to each pixel. Moreover, thousands of training images are usually beyond reach in biomedical tasks. Hence, Ciresan et al. [1] trained a network in a sliding-window setup to predict the class label of each pixel by providing a local region (patch) around that pixel as input. First, this network can localize. Secondly, the training data in terms of patches is much larger than the number of training images. The resulting network won the EM segmentation challenge at ISBI 2012 by a large margin.

卷积网络的典型用途是用于分类任务,其中图像的输出是单个类别标签。 然而,在许多视觉任务中,特别是在生物医学图像处理中,期望的输出应包括定位,即应该将类别标签分配给每个像素。 此外,在生物医学任务中通常无法获得数千个训练图像。因此,Ciresan等[1]在滑动窗口设置中训练了一个网络,以通过提供围绕该像素的局部区域(补丁)来预测每个像素的类别标签。首先,该网络可以本地化。 其次,就补丁而言,训练数据远大于训练图像的数量。 最终的网络在ISBI 2012上大幅度赢得了EM细分挑战。

Obviously, the strategy in Ciresan et al. [1] has two drawbacks. First, it is quite slow because the network must be run separately for each patch, and there is a lot of redundancy due to overlapping patches. Secondly, there is a trade-off between localization accuracy and the use of context. Larger patches require more max-pooling layers that reduce the localization accuracy, while small patches allow the network to see only little context. More recent approaches [11,4] proposed a classifier output that takes into account the features from multiple layers. Good localization and the use of context are possible at the same time.

显然,Ciresan等人[1]的策略有两个缺点。 首先,它很慢,因为每个补丁程序(patch)都必须单独运行网络,而且由于补丁程序重叠(overlapping patches),因此存在很多冗余。 其次,在定位精度和上下文使用之间需要权衡。较大的补丁程序(patches)需要更多的最大池化层,这会降低定位精度,而较小的修补程序使网络只能看到很少的上下文。 最近的方法[11,4]提出了一种分类输出,该输出考虑了来自多层的特征。 良好的localization和上下文的使用是可能的。

In this paper, we build upon a more elegant architecture, the so-called “fully convolutional network” [9]. We modify and extend this architecture such that it works with very few training images and yields more precise segmentations; see Figure 1. The main idea in [9] is to supplement a usual contracting network by successive layers, where pooling operators are replaced by upsampling operators. Hence, these layers increase the resolution of the output. In order to localize, high resolution features from the contracting path are combined with the upsampled output. A successive convolution layer can then learn to assemble a more precise output based on this information.

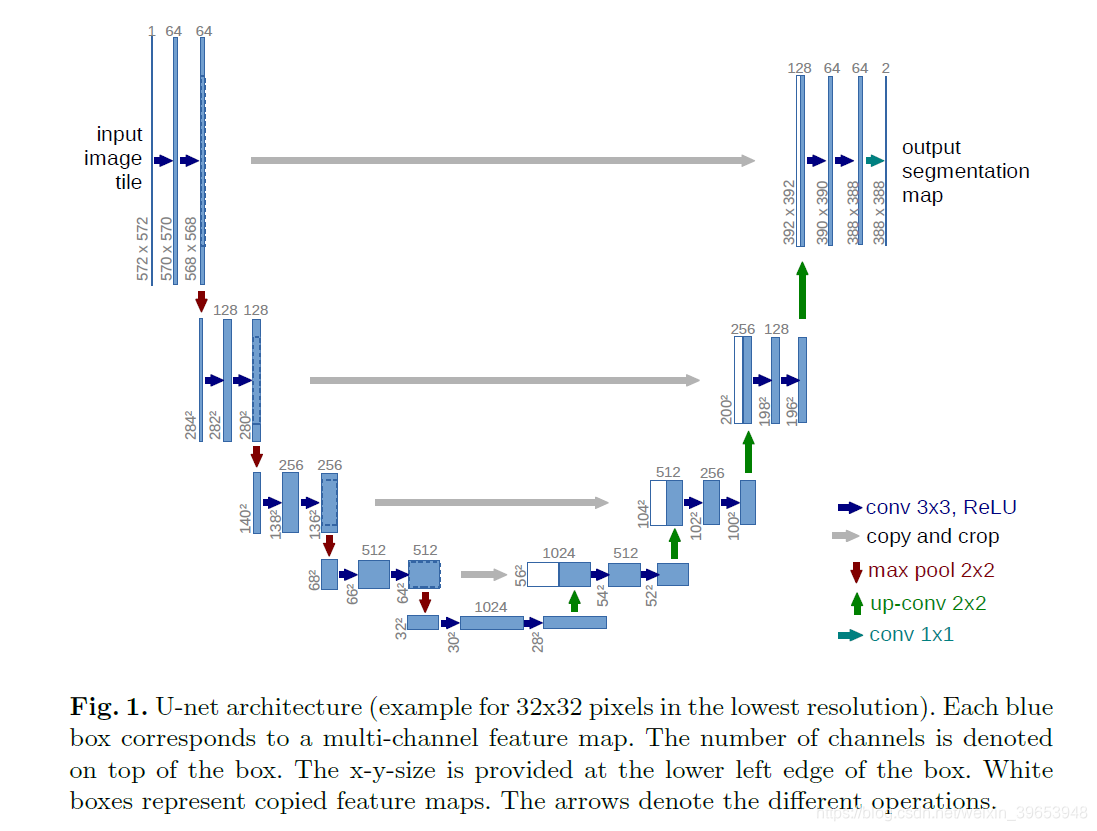

在本文中,我们基于更优雅的结构,即所谓的“全卷积网络” [9],我们修改并扩展了该结构,使其可以在很少的训练图像上工作并产生更精确的segmentations,请参见图1。[9]中的主要思想是在连续的层级上补充通常的合同网络(usual contracting network),其中池化运算由上采样运算代替。因此,这些层提高了输出的分辨率。 为了定位,将收缩路径(contracting path)中的高分辨率特征与上采样的输出结合在一起。 然后,连续的卷积层可以根据此信息学习组装更精确的输出。

图1. U-net架构(最低分辨率的32x32像素示例)。 每个蓝色框对应一个多通道特征图。 通道数显示在框的顶部。 x-y尺寸位于框的左下边缘。 白框代表复制的特征图。 箭头表示不同的操作。

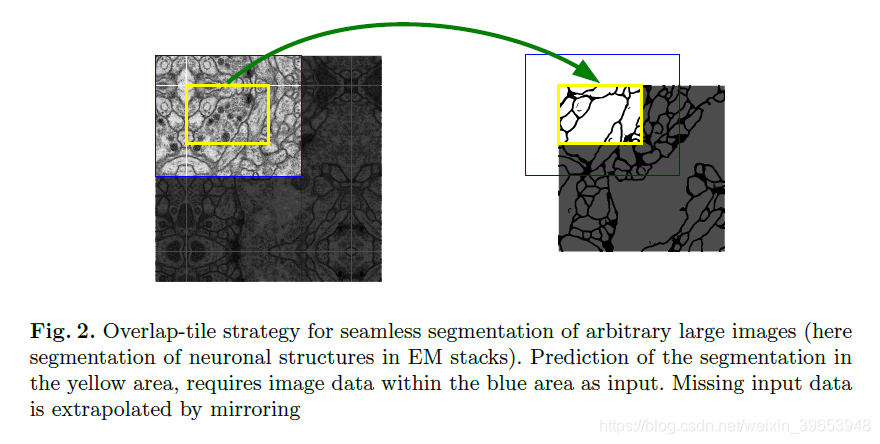

One important modification in our architecture is that in the upsampling part we have also a large number of feature channels, which allow the network to propagate context information to higher resolution layers. As a consequence, the expansive path is more or less symmetric to the contracting path, and yields a u-shaped architecture. The network does not have any fully connected layers and only uses the valid part of each convolution, i.e., the segmentation map only contains the pixels, for which the full context is available in the input image. This strategy allows the seamless segmentation of arbitrarily large images by an overlap-tile strategy (see Figure 2). To predict the pixels in the border region of the image, the missing context is extrapolated by mirroring the input image. This tiling strategy is important to apply the network to large images, since otherwise the resolution would be limited by the GPU memory.

我们架构中的一个重要修改是在上采样部分,我们还有大量的特征通道,这些特征通道使网络可以将上下文信息传播到更高分辨率的层。 结果,扩展路径或多或少地相对于收缩路径对称,并且产生u形结构。 该网络没有全连接层,仅使用每个卷积的有效部分,即分割图仅包含像素,在输入图像中可获得完整的上下文。这种策略允许通过重叠拼贴策略对任意大图像进行无缝分割(参见图2)。 为了预测图像边界区域中的像素,可通过镜像输入图像来推断缺失的上下文。这种平铺策略对于将网络应用于大图像非常重要,因为否则分辨率会受到GPU内存的限制。

图2.任意大图像的无缝分割(此处为EM堆栈中神经元结构的分割)的重叠拼贴策略。 对黄色区域中的分割的预测需要蓝色区域内的图像数据作为输入。 丢失的输入数据通过镜像推断。

As for our tasks there is very little training data available, we use excessive data augmentation by applying elastic deformations to the available training images. This allows the network to learn invariance to such deformations, without the need to see these transformations in the annotated image corpus. This is particularly important in biomedical segmentation, since deformation used to be the most common variation in tissue and realistic deformations can be simulated efficiently. The value of data augmentation for learning invariance has been shown in Dosovitskiy et al. [2] in the scope of unsupervised feature learning.

至于我们的任务,几乎没有可用的训练数据,我们通过对可用的训练图像应用弹性变形(elastic deformations)来使用过多的数据增强。 这允许网络学习此类变形的不变性,而无需在带注释的图像语料库中查看这些转换。 这在生物医学分割中尤其重要,因为变形曾经是组织中最常见的变化,并且可以有效地模拟实际变形。 Dosovitskiy等人[2]已经证明了在无监督特征学习的范围内,数据增强对于学习不变性的价值。

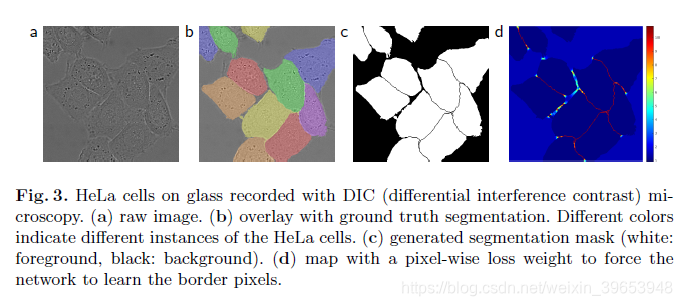

Another challenge in many cell segmentation tasks is the separation of touching objects of the same class; see Figure 3. To this end, we propose the use of a weighted loss, where the separating background labels between touching cells obtain a large weight in the loss function.

许多细胞分割任务中的另一个挑战是分离同一类别的接触对象(touch

ing objects),参见图3。为此,我们建议使用加权损失(weighted loss),其中在接触细胞(touching cells)之间分开的背景标签在损失函数中获得较大的权重。

图3.用DIC(微分干涉对比)显微镜记录的玻璃上的HeLa细胞。(a)原始图像。(b)覆盖真实标签的分割。不同的颜色表示HeLa细胞的不同情况。(c)生成分割蒙版(白色:前景,黑色:背景)。(d)使用逐像素损失权重进行映射,以强制网络学习边界像素。

The resulting network is applicable to various biomedical segmentation problems. In this paper, we show results on the segmentation of neuronal structures in EM stacks (an ongoing competition started at ISBI 2012), where we outperformed the network of Ciresan et al. [1]. Furthermore, we show results for cell segmentation in light microscopy images from the ISBI cell tracking challenge 2015. Here we won with a large margin on the two most challenging 2D transmitted light datasets.

所得的网络适用于各种生物医学分割问题。 在本文中,我们显示了关于EM堆栈中神经元结构分割的结果(一场持续的竞争始于ISBI 2012),在此我们胜过了Ciresan等人[1]的网络。 此外,我们在2015年ISBI细胞追踪挑战赛的光学显微镜图像中显示了细胞分割的结果。在这里,我们在两个最具挑战性的2D透射光数据集上大获全胜。

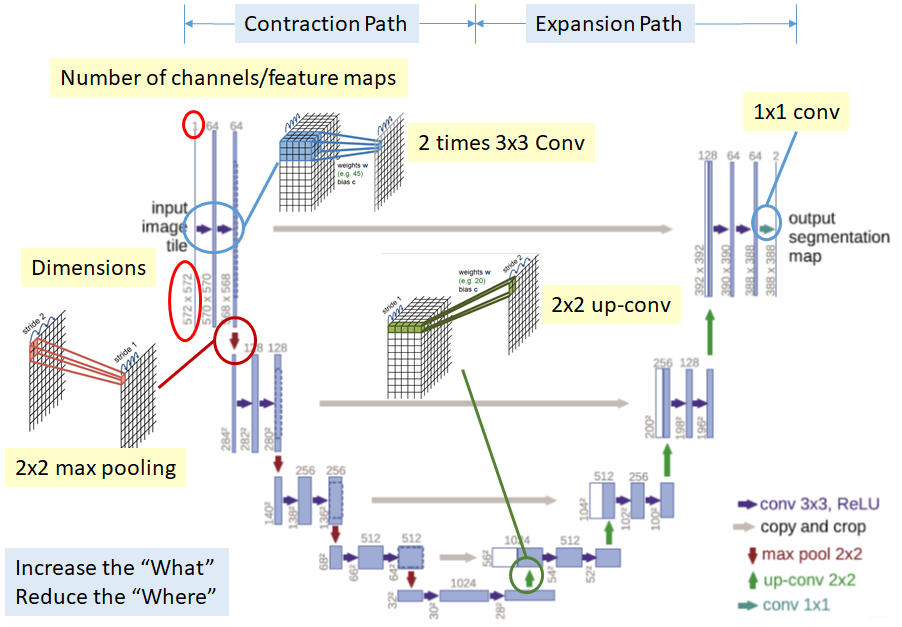

2 Network Architecture

The network architecture is illustrated in Figure 1. It consists of a contracting path (left side) and an expansive path (right side). The contracting path follows the typical architecture of a convolutional network. It consists of the repeated application of two 3x3 convolutions (unpadded convolutions), each followed by a rectified linear unit (ReLU) and a 2x2 max pooling operation with stride 2 for downsampling. At each downsampling step we double the number of feature channels. Every step in the expansive path consists of an upsampling of the feature map followed by a 2x2 convolution (“up-convolution”) that halves the number of feature channels, a concatenation with the correspondingly cropped feature map from the contracting path, and two 3x3 convolutions, each followed by a ReLU. The cropping is necessary due to the loss of border pixels in every convolution. At the final layer a 1x1 convolution is used to map each 64component feature vector to the desired number of classes. In total the network has 23 convolutional layers.

网络架构如图1所示。它由一个收缩路径(左侧)和一个扩展路径(右侧)组成。 收缩路径遵循卷积网络的典型架构。 它由两个3x3卷积(未填充卷积)的重复应用组成,每个卷积后跟一个矩形线性单位(ReLU)和一个2x2最大合并运算,步长为2用于下采样。 在每个降采样步骤中,我们将特征通道的数量增加一倍。 扩展路径中的每个步骤都包括对特征图进行上采样,然后是将特征通道数量减半的2x2卷积(“向上卷积”),与来自收缩路径的相应裁剪的特征图的串联以及两个3x3 卷积,每个后跟一个ReLU。 由于每次卷积中都会丢失边界像素,因此有必要进行裁剪( cropping)。 在最终层,使用1x1卷积将每个64分量特征向量映射到所需的类数。 该网络总共有23个卷积层。

To allow a seamless tiling of the output segmentation map (see Figure 2), it is important to select the input tile size such that all 2x2 max-pooling operations are applied to a layer with an even x- and y-size.

为了无缝拼接输出分割图(请参见图2),重要的是选择输入图块大小,以便将所有2x2最大池化操作应用于x和y大小均等的层。

3 Training

The input images and their corresponding segmentation maps are used to train the network with the stochastic gradient descent implementation of Caffe [6]. Due to the unpadded convolutions, the output image is smaller than the input by a constant border width. To minimize the overhead and make maximum use of the GPU memory, we favor large input tiles over a large batch size and hence reduce the batch to a single image. Accordingly we use a high momentum (0.99) such that a large number of the previously seen training samples determine the update in the current optimization step.

输入图像及其对应的分割图用于通过Caffe [6]的随机梯度下降(SGD)实现来训练网络。由于未填充(unpadded)卷积,因此输出图像比输入图像小一个恒定的边框宽度。 为了最大程度地减少开销并最大程度地利用GPU内存,我们倾向于在大批量时使用较大的输入图块,从而将批量减少为单个图像。 因此,我们使用高动量(momentum)(0.99),以使大量先前看到的训练样本确定当前优化步骤中的更新。

The energy function is computed by a pixel-wise soft-max over the final feature map combined with the cross entropy loss function. The soft-max is defined as where denotes the activation in feature channel at the pixel position with . is the number of classes and is the approximated maximum-function. I.e. for the that has the maximum activation and for all other . The cross entropy then penalizes at each position the deviation of from 1 using

能量函数由最终特征图上的像素级soft-max与交叉熵损失函数组合而成。soft-max定义为 其中 表示在特征通道 中具有 的像素位置 处的激活。 是类的数量, 是近似的最大函数。即对于具有最大激活 的 ,,对于所有其他 ,。交叉熵然后惩罚每个位置上 与1的偏差

where is the true label of each pixel and is a weight map that we introduced to give some pixels more importance in the training.

其中 是每个像素的真实标签, 是一个权重图,我们引入它来使某些像素在训练中更加重要。

We pre-compute the weight map for each ground truth segmentation to compensate the different frequency of pixels from a certain class in the training data set, and to force the network to learn the small separation borders that we introduce between touching cells (See Figure 3c and d).

我们为每个真实标签的分割(ground truth segmentation)预先计算权重图,以补偿训练数据集中某个类别的像素的不同频率,并迫使网络学习我们在接触细胞(touching cells)之间引入的小的分隔边界(参见图3c和d)。

The separation border is computed using morphological operations. The weight map is then computed as

使用形态学运算来计算分离边界。 然后将权重图计算为:

where is the weight map to balance the class frequencies, denotes the distance to the border of the nearest cell and the distance to the border of the second nearest cell. In our experiments we set and pixels.

其中 是平衡类频率的权重图, 表示到最近的细胞的边界的距离,而 到第二个最近的细胞的边界的距离。在我们的实验中,我们设置 , 像素。

In deep networks with many convolutional layers and different paths through the network, a good initialization of the weights is extremely important. Otherwise, parts of the network might give excessive activations, while other parts never contribute. Ideally the initial weights should be adapted such that each feature map in the network has approximately unit variance. For a network with our architecture (alternating convolution and ReLU layers) this can be achieved by drawing the initial weights from a Gaussian distribution with a standard deviation of , where denotes the number of incoming nodes of one neuron [5]. E.g. for a convolution and feature channels in the previous layer .

在具有许多卷积层和通过网络的不同路径的深层网络中,权重的良好初始化非常重要。 否则,网络的某些部分可能会进行过多的激活,而其他部分则永远不会起作用。 理想情况下,应调整初始权重,以使网络中的每个特征图都具有大约单位方差。 对于具有我们架构(交替卷积和ReLU层)的网络,可以通过从高斯分布中提取初始权重(标准差为 )来实现,其中 表示一个神经元的传入节点数[5] 。 例如,对于上一层的 卷积和 个特征通道,。

3.1 Data Augmentation

Data augmentation is essential to teach the network the desired invariance and robustness properties, when only few training samples are available. In case of microscopical images we primarily need shift and rotation invariance as well as robustness to deformations and gray value variations. Especially random elastic deformations of the training samples seem to be the key concept to train a segmentation network with very few annotated images. We generate smooth deformations using random displacement vectors on a coarse 3 by 3 grid. The displacements are sampled from a Gaussian distribution with 10 pixels standard deviation. Per-pixel displacements are then computed using bicubic interpolation. Drop-out layers at the end of the contracting path perform further implicit data augmentation.

当只有少量训练样本可用时,数据增强对于向网络传授所需的不变性和鲁棒性至关重要。对于显微图像,我们首先需要平移和旋转不变性,以及对变形和灰度值变化的鲁棒性。 尤其是训练样本的随机弹性变形似乎是训练带有很少注释图像的分割网络的关键概念。我们使用在3 x 3粗网格上的随机位移矢量生成平滑变形。 从具有10个像素标准差的高斯分布中采样位移。 然后使用双三次插值法计算每个像素的位移。 收缩路径末端的退出层进一步执行隐式数据扩充。

4 Experiments

We demonstrate the application of the u-net to three different segmentation tasks. The first task is the segmentation of neuronal structures in electron microscopic recordings. An example of the data set and our obtained segmentation is displayed in Figure 2. We provide the full result as Supplementary Material. The data set is provided by the EM segmentation challenge [14] that was started at ISBI 2012 and is still open for new contributions. The training data is a set of 30 images (512x512 pixels) from serial section transmission electron microscopy of the Drosophila first instar larva ventral nerve cord (VNC). Each image comes with a corresponding fully annotated ground truth segmentation map for cells (white) and membranes (black). The test set is publicly available, but its segmentation maps are kept secret. An evaluation can be obtained by sending the predicted membrane probability map to the organizers. The evaluation is done by thresholding the map at 10 different levels and computation of the “warping error”, the “Rand error” and the “pixel error” [14].

我们演示了u-net在三个不同细分任务中的应用。 第一项任务是在电子显微镜记录中分割神经元结构。 图2显示了数据集和获得的细分的示例。我们提供完整结果作为补充材料。该数据集由EM细分挑战[14]提供,该挑战始于ISBI 2012,目前仍在接受新的贡献。 训练数据是一组来自果蝇第一龄幼虫腹侧腹侧神经索(VNC)的连续切片透射电镜的30张图像(512x512像素)。 每个图像都带有一个对应的完全注释的真实标签的分割图,用于细胞(白色)和膜(黑色)。 该测试集是公开可用的,但其分段图已保密。 可以通过将预测的膜概率图发送给组织者来获得评估。 通过在10个不同级别对地图进行阈值化和计算“warping error”,“ Rand error”和“pixel error” [14],可以完成评估。

The u-net (averaged over 7 rotated versions of the input data) achieves without any further pre- or postprocessing a warping error of 0.0003529 (the new best score, see Table 1) and a rand-error of 0.0382.

u-net(输入数据的7个旋转版本的平均值)无需任何进一步的预处理或后处理即可实现0.0003529(新的最佳分数,请参见表1)的warping error和0.0382的rand error。

This is significantly better than the sliding-window convolutional network result by Ciresan et al. [1], whose best submission had a warping error of 0.000420 and a rand error of 0.0504. In terms of rand error the only better performing algorithms on this data set use highly data set specific post-processing methods1 applied to the probability map of Ciresan et al. [1].

这比Ciresan等人[1]的滑动窗口卷积网络结果好得多,其最佳提交的warping error为0.000420,rand error为0.0504。 就rand error而言,在此数据集上唯一表现更好的算法是使用适用于Ciresan等人概率图的高度数据集特定的后处理方法 [1]。

表1. EM细分挑战的排名[14](2015年3月6日),按 warping error 排序。

Fig. 4. Result on the ISBI cell tracking challenge. (a) part of an input image of the “PhC-U373” data set. (b) Segmentation result (cyan mask) with manual ground truth (yellow border) © input image of the “DIC-HeLa” data set. (d) Segmentation result (random colored masks) with manual ground truth (yellow border).

图4. ISBI细胞追踪挑战的结果。 (a)“ PhC-U373”数据集的输入图像的一部分。 (b)具有手动地面真实性的分割结果(青色蒙版)(黄色边框)(c)“ DIC-HeLa”数据集的输入图像。 (d)具有人工标注(黄色边框)的分割结果(随机彩色蒙版)

表2. 2015年ISBI细胞跟踪挑战的分段结果(IOU)。

We also applied the u-net to a cell segmentation task in light microscopic images. This segmenation task is part of the ISBI cell tracking challenge 2014 and 2015 [10,13]. The first data set “PhC-U373”2 contains Glioblastoma-astrocytoma U373 cells on a polyacrylimide substrate recorded by phase contrast microscopy (see Figure 4a,b and Supp. Material). It contains 35 partially annotated training images. Here we achieve an average IOU (“intersection over union”) of 92%, which is significantly better than the second best algorithm with 83% (see Table 2). The second data set “DIC-HeLa”3 are HeLa cells on a flat glass recorded by differential interference contrast (DIC) microscopy (see Figure 3, Figure 4c,d and Supp. Material). It contains 20 partially annotated training images. Here we achieve an average IOU of 77.5% which is significantly better than the second best algorithm with 46%.

我们还将u-net应用于光学显微图像中的细胞分割任务。 该细分任务是ISBI电池跟踪挑战2014和2015的一部分[10,13]。 第一个数据集“PhC-U373”2通过相差显微镜(参见图4a,b和附加材料)在聚丙烯酰亚胺基底上包含胶质母细胞瘤-星形细胞瘤U373细胞(Glioblastoma-astrocytoma U373 cells)。它包含35个部分注释的训练图像。在这里,我们获得了平均值 IOU(联合上的“相交”)为92%,明显好于83%的次优算法(请参见表2)。 第二个数据集“ DIC-HeLa” 3是通过差动干涉对比(DIC)显微镜记录的at玻璃上的HeLa细胞(请参见图3,图4c,d和补充材料)。它包含20个部分注释的训练图像。 在这里,我们达到77.5%的平均IOU,明显好于46%的次优算法。

5 Conclusion

The u-net architecture achieves very good performance on very different biomedical segmentation applications. Thanks to data augmentation with elastic deformations, it only needs very few annotated images and has a very reasonable training time of only 10 hours on a NVidia Titan GPU (6 GB). We provide the full Caffe[6]-based implementation and the trained networks4. We are sure that the u-net architecture can be applied easily to many more tasks.

u-net结构在非常不同的生物医学细分应用程序中都具有非常好的性能。 由于具有弹性变形的数据增强,它仅需要很少的带注释的图像,并且在NVidia Titan GPU(6 GB)上只有10小时的非常合理的训练时间。 我们提供完整的基于Caffe [6]的实施方案和经过培训的网络4。 我们确信u-net架构可以轻松地应用于更多任务。

U-Net Network Architecture

U-net体系结构如上所示。 它由收缩路径( contraction path)和扩展路径(expansion path)组成。

Contraction path

- 连续进行两次

3×3 Cov和2×2 max pooling。 这可以帮助提取更多高级特征,并且可以减少特征图的大小。

Expansion path

- 连续执行

2×2 Up-conv和两次3×3 Conv以恢复分割图的大小。 但是,上述过程虽然增加了“内容(what)”,但减少了“位置(where)”。 这意味着,我们可以获得高级特征,但同时也会丢失本地化信息。 - 因此,在每次向上转换之后,我们还可以连接具有相同级别的特征图(灰色箭头)。 这有助于提供从收缩路径到扩展路径的本地化信息。

- 最后,由于输出特征图仅具有

2类(细胞和膜),因此1×1Conv可将特征图的大小从64映射到2。

U-net 网络详解

Keras 代码实现

def conv2d_block(input_tensor, n_filters, kernel_size = 3, batchnorm = True):"""Function to add 2 convolutional layers with the parameters passed to it"""# first layerx = Conv2D(filters = n_filters, kernel_size = (kernel_size, kernel_size),\kernel_initializer = 'he_normal', padding = 'same')(input_tensor)if batchnorm:x = BatchNormalization()(x)x = Activation('relu')(x)# second layerx = Conv2D(filters = n_filters, kernel_size = (kernel_size, kernel_size),\kernel_initializer = 'he_normal', padding = 'same')(input_tensor)if batchnorm:x = BatchNormalization()(x)x = Activation('relu')(x)return xdef get_unet(input_img, n_filters = 16, dropout = 0.1, batchnorm = True):# Contracting Pathc1 = conv2d_block(input_img, n_filters * 1, kernel_size = 3, batchnorm = batchnorm)p1 = MaxPooling2D((2, 2))(c1)p1 = Dropout(dropout)(p1)c2 = conv2d_block(p1, n_filters * 2, kernel_size = 3, batchnorm = batchnorm)p2 = MaxPooling2D((2, 2))(c2)p2 = Dropout(dropout)(p2)c3 = conv2d_block(p2, n_filters * 4, kernel_size = 3, batchnorm = batchnorm)p3 = MaxPooling2D((2, 2))(c3)p3 = Dropout(dropout)(p3)c4 = conv2d_block(p3, n_filters * 8, kernel_size = 3, batchnorm = batchnorm)p4 = MaxPooling2D((2, 2))(c4)p4 = Dropout(dropout)(p4)c5 = conv2d_block(p4, n_filters = n_filters * 16, kernel_size = 3, batchnorm = batchnorm)# Expansive Pathu6 = Conv2DTranspose(n_filters * 8, (3, 3), strides = (2, 2), padding = 'same')(c5)u6 = concatenate([u6, c4])u6 = Dropout(dropout)(u6)c6 = conv2d_block(u6, n_filters * 8, kernel_size = 3, batchnorm = batchnorm)u7 = Conv2DTranspose(n_filters * 4, (3, 3), strides = (2, 2), padding = 'same')(c6)u7 = concatenate([u7, c3])u7 = Dropout(dropout)(u7)c7 = conv2d_block(u7, n_filters * 4, kernel_size = 3, batchnorm = batchnorm)u8 = Conv2DTranspose(n_filters * 2, (3, 3), strides = (2, 2), padding = 'same')(c7)u8 = concatenate([u8, c2])u8 = Dropout(dropout)(u8)c8 = conv2d_block(u8, n_filters * 2, kernel_size = 3, batchnorm = batchnorm)u9 = Conv2DTranspose(n_filters * 1, (3, 3), strides = (2, 2), padding = 'same')(c8)u9 = concatenate([u9, c1])u9 = Dropout(dropout)(u9)c9 = conv2d_block(u9, n_filters * 1, kernel_size = 3, batchnorm = batchnorm)outputs = Conv2D(1, (1, 1), activation='sigmoid')(c9)model = Model(inputs=[input_img], outputs=[outputs])return model

参考:

Understanding Semantic Segmentation with UNET

Review: U-Net (Biomedical Image Segmentation)

如若内容造成侵权/违法违规/事实不符,请联系编程学习网邮箱:809451989@qq.com进行投诉反馈,一经查实,立即删除!

相关文章

- python读取数据可能出现的故障

这里写自定义目录标题欢迎使用Markdown编辑器新的改变功能快捷键合理的创建标题,有助于目录的生成如何改变文本的样式插入链接与图片如何插入一段漂亮的代码片生成一个适合你的列表创建一个表格设定内容居中、居左、居右SmartyPants创建一个自定义列表如何创建一个注脚注释也是…...

2024/4/23 13:56:29 - Springboot集成EasyExcel实现导入导出

前言: 之前写过一篇springboot集成poi导出表格的文章,但是当数据量变大后发现,有jvm内存溢出的现象,导致服务宕机;就此现象,必定要做出相应的解决方案才行,这时发现了阿里巴巴提供的easyexcel工具类,github地址:https://github.com/alibaba/easyexcel 本篇文章只讲解e…...

2024/4/28 1:44:16 - 7909:统计数字——map

描述某次科研调查时得到了n个自然数,每个数均不超过1500000000(1.5*109)。已知不相同的数不超过10000个,现在需要统计这些自然数各自出现的次数,并按照自然数从小到大的顺序输出统计结果。输入包含n+1行: 第一行是整数n,表示自然数的个数; 第2~n+1每行一个自然数。 40%的…...

2024/5/2 19:44:20 - webgl动画纹理

动画纹理 绘制动画纹理和图片纹理的基本过程是一致的,只是以视频作为纹理数据来源; 视频的本质是由一系列的图片序列构成,因此本质上动画纹理和图片纹理并没有区别 使用图片纹理时,我们需要等待图片加载完成然后将图形信息绘制到纹理;同理,绘制动画纹理时,我们需要获取到…...

2024/5/5 6:03:47 - Leetcode--107. 二叉树的层次遍历 II

Leetcode–107. 二叉树的层次遍历 II [9/6/2020] 前言这是我做leetcode的第一题,其实比较简单,主要也是为了熟悉leetcode这个平台,以及相关的答题规范。 本题是hot 100 的第一题,是一个二叉树层次遍历问题,可以运用BFS的手段进行逐行遍历,获取隔行向量,然后自底向上的输…...

2024/4/25 16:34:06 - corejava-笔记——方法的重载&重写

方法的重载和重写1. 方法的重载(同一个类中)2. 方法的重写(子父类中) 1. 方法的重载(同一个类中) 必须在同一个类中, 要求如下:方法名必须相同方法参数列表必须不同 ① 参数类型不同 ② 参数的个数不同 ③ 参数的类型顺序不同方法的修饰符、返回类型、抛出异常无限制,…...

2024/3/16 1:20:36 - 玩转tableau动态工具提示,让地图生动起来

前言: 今天为了展示一个不同城市的月售,门店数,店均等数据分布,准备采用地图形式展示,然后突然想到之前看到的一个示例,可以在鼠标悬停在某个省份的时候,在工具提示里面会显示该省份各城市的数据分布,觉得非常好,也想学一下,因此有了这篇学习记录文章;翻了tableau的…...

2024/4/28 8:50:16 - 红黑树的左右旋

...

2024/4/25 12:01:55 - RxJava简单示例

RxJava - JVM响应式扩展Reactive Extensions 用于使用Java VM的可观察序列编写异步和基于事件的程序的库。Rxjava由于其基于事件流的链式调用、逻辑简洁 & 使用简单的特点。简单示例:首先创建一个被观察者Observable,之后创建一个观察者(订阅者),接着建立订阅关系。pu…...

2024/4/25 3:03:31 - C++ 二叉查找树的编码与解码

序列化和反序列化二叉搜索树 题目[leetcode449] 序列化是将数据结构或对象转换为一系列位的过程,以便它可以存储在文件或内存缓冲区中,或通过网络连接链路传输,以便稍后在同一个或另一个计算机环境中重建。 设计一个算法来序列化和反序列化二叉搜索树。 对序列化/反序列化算…...

2024/3/29 14:09:58 - 学习python第一天之猜数字游戏

1.请写出与 10 < cost <50等价的表达式 cost > 10 and cost < 50 2.python3中,一行可以书写多个语句吗? 可以书写,使用时用 ;隔开 3.请问python的and操作符和C语言的&&操作符有何不同? 在C中,0&&3 = 0,1&&3 = 1; 在python中,0 and…...

2024/4/22 2:39:20 - Codeforces Round #667 (Div. 3) D

Decrease the Sum of Digits题意: 将一个数加n使其各位上的数字相加之和小于s 思路: 贪心处理,从后向前依次处理,刚开始还想着转化成数组,结果想麻烦了,从后向前处理即可 对于每一位,算一下当前各位数之和是否满足条件,若不满足,加上一个数使其进位 即:n += b - n % …...

2024/3/19 23:43:16 - 实现电商首页轮播图功能

没有什么特别的功能添加枚举类package com.imooc.enums; /* * 性别 * */ public enum YesOrNo {NO(0,"否"),YES(1,"是");public final Integer type;public final String value;YesOrNo(Integer type, String value) {this.type = type;this.value = value…...

2024/4/27 5:15:47 - arthas jvm相关命令使用示例:jvm、sysprop

jvm命令sysprop命令总结...

2024/4/21 19:00:31 - node学习---模块化

模块化 1.在Node中,一个js文件就是一个模块 2. 在Node中,每一个js文件中的js代码都是独立运行在一个函数中 ***而不是全局作用域,所以一个模块的中的变量和函数在其他模块中无法访问 3.我们可以通过 exports 来向外部暴露变量和方法 只需要将需要暴露给外部的变量或方法设置…...

2024/5/2 21:35:16 - RT-Thread使用sscanf %X时,需要启用libc

目标将字符串char str[]="12345678"转成数组array,使得array[0]=0x12;array[1]=0x34;array[2]=0x56;array[3]=0x78。 因为将代码下载到单片机中太费时间,就使用了RT-Thread的QEMU在线仿真进行。 C:\RT-ThreadStudio\workspace\pdulib_test>C:/RT-ThreadStudio/r…...

2024/4/29 1:38:27 - 【Python学习3】组合数据类型

组合数据类型1 序列类型1.1 元组2集合类型3映射类型4 组合数据类型的迭代与复制 组合数据类型将数据项集中在一起,以便在程序设计时有更多的选择。 1 序列类型 python有5种内置的序列类型。bytearry、bytes、list、str、tuple,都支持成员关系操作in、大小len()、分片[]、同时…...

2024/3/19 18:06:07 - 图像识别实战——天气分类

首先来看一下题目要求①收集数据,并标注数据来源与方式: 在百度上进行搜索,发现了和鲸社区 搜索:天气图片数据集进入,点击进入@article{RSCM2017, title = {RSCM: Region Selection and Concurrency Model for Multi-class Weather Recognition}, author = {Di Lin and Ce…...

2024/3/19 22:23:46 - 破解实习僧字体反爬

首先声名一下,本人小白,只是为了做笔记,我估摸自己可能做不出来 第一 实习僧的字体反爬是静态的。第二步,调用第三方应用解析,如High-Logic FontCreator第三步,保存为XML文件查看细节 # Date: 2020/9/5 17:13 # @Software: PyCharm from fontTools.ttLib import ttFont b…...

2024/5/2 11:54:56 - 大学生书单推荐

本文首发于知乎大学生书单推荐首先推荐李笑来的《把时间当作朋友》和《财富自由之路》,这两本书写的真不错,虽然李笑来的人设倒下了,但是不影响这两本书的质量,也不要因为一次人设倒下就全盘否定一个人,其实李笑来那一波操作之后人们反倒更加崇拜他了。 季羡林的书值得…...

2024/3/19 23:36:38

最新文章

- JavaEE企业级开发中常用的Stream流

介绍 在Java编程中,Stream流是Java 8引入的一个重要概念,它提供了一种新的处理集合的方式,可以更加简洁、高效地进行数据操作。Stream流支持各种常见的操作,比如过滤、映射、排序、聚合等,同时也支持并行处理…...

2024/5/9 14:17:11 - 梯度消失和梯度爆炸的一些处理方法

在这里是记录一下梯度消失或梯度爆炸的一些处理技巧。全当学习总结了如有错误还请留言,在此感激不尽。 权重和梯度的更新公式如下: w w − η ⋅ ∇ w w w - \eta \cdot \nabla w ww−η⋅∇w 个人通俗的理解梯度消失就是网络模型在反向求导的时候出…...

2024/5/7 10:36:02 - Java深度优先搜索DFS(含面试大厂题和源码)

深度优先搜索(Depth-First Search,简称DFS)是一种用于遍历或搜索树或图的算法。DFS 通过沿着树的深度来遍历节点,尽可能深地搜索树的分支。当节点v的所在边都已被探寻过,搜索将回溯到发现节点v的那条边的起始节点。这个…...

2024/5/8 14:11:41 - 一个浮动绝对居中的tailwindcss

今天改进图片组件,遇到个SVG绝对居中的问题。想起之前大概是通过top left来实现,由于组件的宽高需要动态输入。不能定死宽高,于是想起来问GPT。刚开始老是给一些很菜的代码,不是我想要的 气不打一处来,索性给他限死框框…...

2024/5/8 7:01:32 - 416. 分割等和子集问题(动态规划)

题目 题解 class Solution:def canPartition(self, nums: List[int]) -> bool:# badcaseif not nums:return True# 不能被2整除if sum(nums) % 2 ! 0:return False# 状态定义:dp[i][j]表示当背包容量为j,用前i个物品是否正好可以将背包填满ÿ…...

2024/5/8 19:32:33 - 【Java】ExcelWriter自适应宽度工具类(支持中文)

工具类 import org.apache.poi.ss.usermodel.Cell; import org.apache.poi.ss.usermodel.CellType; import org.apache.poi.ss.usermodel.Row; import org.apache.poi.ss.usermodel.Sheet;/*** Excel工具类** author xiaoming* date 2023/11/17 10:40*/ public class ExcelUti…...

2024/5/9 7:40:42 - Spring cloud负载均衡@LoadBalanced LoadBalancerClient

LoadBalance vs Ribbon 由于Spring cloud2020之后移除了Ribbon,直接使用Spring Cloud LoadBalancer作为客户端负载均衡组件,我们讨论Spring负载均衡以Spring Cloud2020之后版本为主,学习Spring Cloud LoadBalance,暂不讨论Ribbon…...

2024/5/9 2:44:26 - TSINGSEE青犀AI智能分析+视频监控工业园区周界安全防范方案

一、背景需求分析 在工业产业园、化工园或生产制造园区中,周界防范意义重大,对园区的安全起到重要的作用。常规的安防方式是采用人员巡查,人力投入成本大而且效率低。周界一旦被破坏或入侵,会影响园区人员和资产安全,…...

2024/5/8 20:33:13 - VB.net WebBrowser网页元素抓取分析方法

在用WebBrowser编程实现网页操作自动化时,常要分析网页Html,例如网页在加载数据时,常会显示“系统处理中,请稍候..”,我们需要在数据加载完成后才能继续下一步操作,如何抓取这个信息的网页html元素变化&…...

2024/5/9 3:15:57 - 【Objective-C】Objective-C汇总

方法定义 参考:https://www.yiibai.com/objective_c/objective_c_functions.html Objective-C编程语言中方法定义的一般形式如下 - (return_type) method_name:( argumentType1 )argumentName1 joiningArgument2:( argumentType2 )argumentName2 ... joiningArgu…...

2024/5/9 5:40:03 - 【洛谷算法题】P5713-洛谷团队系统【入门2分支结构】

👨💻博客主页:花无缺 欢迎 点赞👍 收藏⭐ 留言📝 加关注✅! 本文由 花无缺 原创 收录于专栏 【洛谷算法题】 文章目录 【洛谷算法题】P5713-洛谷团队系统【入门2分支结构】🌏题目描述🌏输入格…...

2024/5/9 7:40:40 - 【ES6.0】- 扩展运算符(...)

【ES6.0】- 扩展运算符... 文章目录 【ES6.0】- 扩展运算符...一、概述二、拷贝数组对象三、合并操作四、参数传递五、数组去重六、字符串转字符数组七、NodeList转数组八、解构变量九、打印日志十、总结 一、概述 **扩展运算符(...)**允许一个表达式在期望多个参数࿰…...

2024/5/8 20:58:56 - 摩根看好的前智能硬件头部品牌双11交易数据极度异常!——是模式创新还是饮鸩止渴?

文 | 螳螂观察 作者 | 李燃 双11狂欢已落下帷幕,各大品牌纷纷晒出优异的成绩单,摩根士丹利投资的智能硬件头部品牌凯迪仕也不例外。然而有爆料称,在自媒体平台发布霸榜各大榜单喜讯的凯迪仕智能锁,多个平台数据都表现出极度异常…...

2024/5/9 1:35:21 - Go语言常用命令详解(二)

文章目录 前言常用命令go bug示例参数说明 go doc示例参数说明 go env示例 go fix示例 go fmt示例 go generate示例 总结写在最后 前言 接着上一篇继续介绍Go语言的常用命令 常用命令 以下是一些常用的Go命令,这些命令可以帮助您在Go开发中进行编译、测试、运行和…...

2024/5/9 4:12:16 - 用欧拉路径判断图同构推出reverse合法性:1116T4

http://cplusoj.com/d/senior/p/SS231116D 假设我们要把 a a a 变成 b b b,我们在 a i a_i ai 和 a i 1 a_{i1} ai1 之间连边, b b b 同理,则 a a a 能变成 b b b 的充要条件是两图 A , B A,B A,B 同构。 必要性显然࿰…...

2024/5/9 7:40:35 - 【NGINX--1】基础知识

1、在 Debian/Ubuntu 上安装 NGINX 在 Debian 或 Ubuntu 机器上安装 NGINX 开源版。 更新已配置源的软件包信息,并安装一些有助于配置官方 NGINX 软件包仓库的软件包: apt-get update apt install -y curl gnupg2 ca-certificates lsb-release debian-…...

2024/5/8 18:06:50 - Hive默认分割符、存储格式与数据压缩

目录 1、Hive默认分割符2、Hive存储格式3、Hive数据压缩 1、Hive默认分割符 Hive创建表时指定的行受限(ROW FORMAT)配置标准HQL为: ... ROW FORMAT DELIMITED FIELDS TERMINATED BY \u0001 COLLECTION ITEMS TERMINATED BY , MAP KEYS TERMI…...

2024/5/9 7:40:34 - 【论文阅读】MAG:一种用于航天器遥测数据中有效异常检测的新方法

文章目录 摘要1 引言2 问题描述3 拟议框架4 所提出方法的细节A.数据预处理B.变量相关分析C.MAG模型D.异常分数 5 实验A.数据集和性能指标B.实验设置与平台C.结果和比较 6 结论 摘要 异常检测是保证航天器稳定性的关键。在航天器运行过程中,传感器和控制器产生大量周…...

2024/5/9 1:42:21 - --max-old-space-size=8192报错

vue项目运行时,如果经常运行慢,崩溃停止服务,报如下错误 FATAL ERROR: CALL_AND_RETRY_LAST Allocation failed - JavaScript heap out of memory 因为在 Node 中,通过JavaScript使用内存时只能使用部分内存(64位系统&…...

2024/5/9 5:02:59 - 基于深度学习的恶意软件检测

恶意软件是指恶意软件犯罪者用来感染个人计算机或整个组织的网络的软件。 它利用目标系统漏洞,例如可以被劫持的合法软件(例如浏览器或 Web 应用程序插件)中的错误。 恶意软件渗透可能会造成灾难性的后果,包括数据被盗、勒索或网…...

2024/5/9 4:31:45 - JS原型对象prototype

让我简单的为大家介绍一下原型对象prototype吧! 使用原型实现方法共享 1.构造函数通过原型分配的函数是所有对象所 共享的。 2.JavaScript 规定,每一个构造函数都有一个 prototype 属性,指向另一个对象,所以我们也称为原型对象…...

2024/5/8 12:44:41 - C++中只能有一个实例的单例类

C中只能有一个实例的单例类 前面讨论的 President 类很不错,但存在一个缺陷:无法禁止通过实例化多个对象来创建多名总统: President One, Two, Three; 由于复制构造函数是私有的,其中每个对象都是不可复制的,但您的目…...

2024/5/8 9:51:44 - python django 小程序图书借阅源码

开发工具: PyCharm,mysql5.7,微信开发者工具 技术说明: python django html 小程序 功能介绍: 用户端: 登录注册(含授权登录) 首页显示搜索图书,轮播图࿰…...

2024/5/9 6:36:49 - 电子学会C/C++编程等级考试2022年03月(一级)真题解析

C/C++等级考试(1~8级)全部真题・点这里 第1题:双精度浮点数的输入输出 输入一个双精度浮点数,保留8位小数,输出这个浮点数。 时间限制:1000 内存限制:65536输入 只有一行,一个双精度浮点数。输出 一行,保留8位小数的浮点数。样例输入 3.1415926535798932样例输出 3.1…...

2024/5/9 4:33:29 - 配置失败还原请勿关闭计算机,电脑开机屏幕上面显示,配置失败还原更改 请勿关闭计算机 开不了机 这个问题怎么办...

解析如下:1、长按电脑电源键直至关机,然后再按一次电源健重启电脑,按F8健进入安全模式2、安全模式下进入Windows系统桌面后,按住“winR”打开运行窗口,输入“services.msc”打开服务设置3、在服务界面,选中…...

2022/11/19 21:17:18 - 错误使用 reshape要执行 RESHAPE,请勿更改元素数目。

%读入6幅图像(每一幅图像的大小是564*564) f1 imread(WashingtonDC_Band1_564.tif); subplot(3,2,1),imshow(f1); f2 imread(WashingtonDC_Band2_564.tif); subplot(3,2,2),imshow(f2); f3 imread(WashingtonDC_Band3_564.tif); subplot(3,2,3),imsho…...

2022/11/19 21:17:16 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机...

win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”问题的解决方法在win7系统关机时如果有升级系统的或者其他需要会直接进入一个 等待界面,在等待界面中我们需要等待操作结束才能关机,虽然这比较麻烦,但是对系统进行配置和升级…...

2022/11/19 21:17:15 - 台式电脑显示配置100%请勿关闭计算机,“准备配置windows 请勿关闭计算机”的解决方法...

有不少用户在重装Win7系统或更新系统后会遇到“准备配置windows,请勿关闭计算机”的提示,要过很久才能进入系统,有的用户甚至几个小时也无法进入,下面就教大家这个问题的解决方法。第一种方法:我们首先在左下角的“开始…...

2022/11/19 21:17:14 - win7 正在配置 请勿关闭计算机,怎么办Win7开机显示正在配置Windows Update请勿关机...

置信有很多用户都跟小编一样遇到过这样的问题,电脑时发现开机屏幕显现“正在配置Windows Update,请勿关机”(如下图所示),而且还需求等大约5分钟才干进入系统。这是怎样回事呢?一切都是正常操作的,为什么开时机呈现“正…...

2022/11/19 21:17:13 - 准备配置windows 请勿关闭计算机 蓝屏,Win7开机总是出现提示“配置Windows请勿关机”...

Win7系统开机启动时总是出现“配置Windows请勿关机”的提示,没过几秒后电脑自动重启,每次开机都这样无法进入系统,此时碰到这种现象的用户就可以使用以下5种方法解决问题。方法一:开机按下F8,在出现的Windows高级启动选…...

2022/11/19 21:17:12 - 准备windows请勿关闭计算机要多久,windows10系统提示正在准备windows请勿关闭计算机怎么办...

有不少windows10系统用户反映说碰到这样一个情况,就是电脑提示正在准备windows请勿关闭计算机,碰到这样的问题该怎么解决呢,现在小编就给大家分享一下windows10系统提示正在准备windows请勿关闭计算机的具体第一种方法:1、2、依次…...

2022/11/19 21:17:11 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”的解决方法...

今天和大家分享一下win7系统重装了Win7旗舰版系统后,每次关机的时候桌面上都会显示一个“配置Windows Update的界面,提示请勿关闭计算机”,每次停留好几分钟才能正常关机,导致什么情况引起的呢?出现配置Windows Update…...

2022/11/19 21:17:10 - 电脑桌面一直是清理请关闭计算机,windows7一直卡在清理 请勿关闭计算机-win7清理请勿关机,win7配置更新35%不动...

只能是等着,别无他法。说是卡着如果你看硬盘灯应该在读写。如果从 Win 10 无法正常回滚,只能是考虑备份数据后重装系统了。解决来方案一:管理员运行cmd:net stop WuAuServcd %windir%ren SoftwareDistribution SDoldnet start WuA…...

2022/11/19 21:17:09 - 计算机配置更新不起,电脑提示“配置Windows Update请勿关闭计算机”怎么办?

原标题:电脑提示“配置Windows Update请勿关闭计算机”怎么办?win7系统中在开机与关闭的时候总是显示“配置windows update请勿关闭计算机”相信有不少朋友都曾遇到过一次两次还能忍但经常遇到就叫人感到心烦了遇到这种问题怎么办呢?一般的方…...

2022/11/19 21:17:08 - 计算机正在配置无法关机,关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机...

关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!关机提示 windows7 正在配…...

2022/11/19 21:17:05 - 钉钉提示请勿通过开发者调试模式_钉钉请勿通过开发者调试模式是真的吗好不好用...

钉钉请勿通过开发者调试模式是真的吗好不好用 更新时间:2020-04-20 22:24:19 浏览次数:729次 区域: 南阳 > 卧龙 列举网提醒您:为保障您的权益,请不要提前支付任何费用! 虚拟位置外设器!!轨迹模拟&虚拟位置外设神器 专业用于:钉钉,外勤365,红圈通,企业微信和…...

2022/11/19 21:17:05 - 配置失败还原请勿关闭计算机怎么办,win7系统出现“配置windows update失败 还原更改 请勿关闭计算机”,长时间没反应,无法进入系统的解决方案...

前几天班里有位学生电脑(windows 7系统)出问题了,具体表现是开机时一直停留在“配置windows update失败 还原更改 请勿关闭计算机”这个界面,长时间没反应,无法进入系统。这个问题原来帮其他同学也解决过,网上搜了不少资料&#x…...

2022/11/19 21:17:04 - 一个电脑无法关闭计算机你应该怎么办,电脑显示“清理请勿关闭计算机”怎么办?...

本文为你提供了3个有效解决电脑显示“清理请勿关闭计算机”问题的方法,并在最后教给你1种保护系统安全的好方法,一起来看看!电脑出现“清理请勿关闭计算机”在Windows 7(SP1)和Windows Server 2008 R2 SP1中,添加了1个新功能在“磁…...

2022/11/19 21:17:03 - 请勿关闭计算机还原更改要多久,电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机怎么办...

许多用户在长期不使用电脑的时候,开启电脑发现电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机。。.这要怎么办呢?下面小编就带着大家一起看看吧!如果能够正常进入系统,建议您暂时移…...

2022/11/19 21:17:02 - 还原更改请勿关闭计算机 要多久,配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以...

配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!配置windows update失败 还原更改 请勿关闭计算机&#x…...

2022/11/19 21:17:01 - 电脑配置中请勿关闭计算机怎么办,准备配置windows请勿关闭计算机一直显示怎么办【图解】...

不知道大家有没有遇到过这样的一个问题,就是我们的win7系统在关机的时候,总是喜欢显示“准备配置windows,请勿关机”这样的一个页面,没有什么大碍,但是如果一直等着的话就要两个小时甚至更久都关不了机,非常…...

2022/11/19 21:17:00 - 正在准备配置请勿关闭计算机,正在准备配置windows请勿关闭计算机时间长了解决教程...

当电脑出现正在准备配置windows请勿关闭计算机时,一般是您正对windows进行升级,但是这个要是长时间没有反应,我们不能再傻等下去了。可能是电脑出了别的问题了,来看看教程的说法。正在准备配置windows请勿关闭计算机时间长了方法一…...

2022/11/19 21:16:59 - 配置失败还原请勿关闭计算机,配置Windows Update失败,还原更改请勿关闭计算机...

我们使用电脑的过程中有时会遇到这种情况,当我们打开电脑之后,发现一直停留在一个界面:“配置Windows Update失败,还原更改请勿关闭计算机”,等了许久还是无法进入系统。如果我们遇到此类问题应该如何解决呢࿰…...

2022/11/19 21:16:58 - 如何在iPhone上关闭“请勿打扰”

Apple’s “Do Not Disturb While Driving” is a potentially lifesaving iPhone feature, but it doesn’t always turn on automatically at the appropriate time. For example, you might be a passenger in a moving car, but your iPhone may think you’re the one dri…...

2022/11/19 21:16:57