强化学习算法 DQN 解决 CartPole 问题,代码逐条详解

本文内容源自百度强化学习 7 日入门课程学习整理

感谢百度 PARL 团队李科浇老师的课程讲解

强化学习算法 DQN 解决 CartPole 问题,移动小车使得车上的摆杆保持直立。

-

这个游戏环境可以说是强化学习中的 “Hello World”

-

大部分的算法都可以先利用这个环境来测试下是否可以收敛

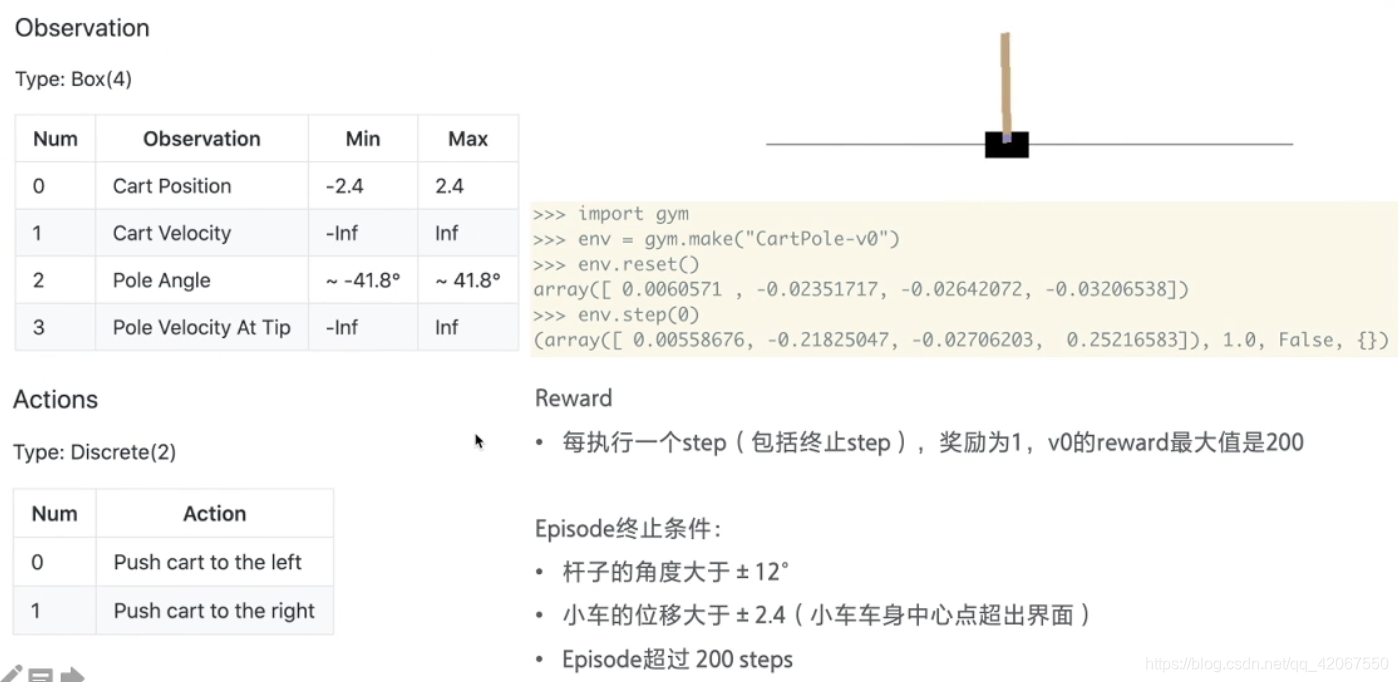

环境介绍:

小车在一个导轨上,无摩擦地来回移动,车上有一根杆子,可以绕着小车上的一个点旋转,所以我们要做的是,通过推动小车往左或者往右,来确保杆子不倒

终止条件:

- 杆子角度大于 +/-12度

- 车子位移大于 +/-2.4(车子移出了界面外)

- Episode 超出 200 steps

奖励:

- 每执行一个 step 拿到 1分

- 所以最高是 200 分

环境重置 env.reset()

- 返回状态值:[小车的位置,小车的速度,杆子的角度,杆子顶端的速度]

每走一步 env.step(0)

- 返回:[当前状态,奖励,是否结束]

文章目录

- 一、安装依赖

- 二、导入依赖

- 三、设置超参数

- 四、Model

- 五、Algorithm

- 六、Agent

- 七、ReplayMemory

- 八、Training && Test(训练&&测试)

- 九、创建环境和Agent,创建经验池,启动训练,保存模型

- 十、总结

一、安装依赖

pip install gym

pip install paddlepaddle==1.6.3

pip install parl==1.3.1

二、导入依赖

import parl

from parl import layers

# parl 封装了 paddle.fluid.layers 的 API,官网可查询使用方式

import paddle.fluid as fluid

import copy

import numpy as np

import os

import gym

from parl.utils import logger

三、设置超参数

LEARN_FREQ = 5 # 训练频率,不需要每一个step都learn,攒一些新增经验后再learn,提高效率

MEMORY_SIZE = 20000 # replay memory的大小,越大越占用内存

MEMORY_WARMUP_SIZE = 200 # replay_memory 里需要预存一些经验数据,再开启训练

BATCH_SIZE = 32 # 每次给agent learn的数据数量,从replay memory随机里sample一批数据出来

LEARNING_RATE = 0.001 # 学习率

GAMMA = 0.99 # reward 的衰减因子,一般取 0.9 到 0.999 不等

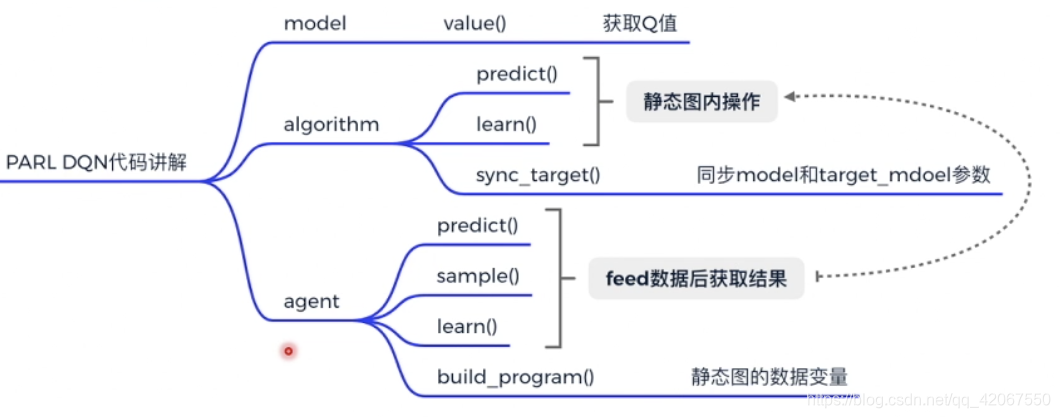

四、Model

Model用来定义前向(Forward)网络,用户可以自由的定制自己的网络结构。

class Model(parl.Model):# 这里的 model 利用 parl.Model 作为基类,后面会用到一些基类下的方法def __init__(self, act_dim):hid1_size = 128hid2_size = 128# 3层全连接网络self.fc1 = layers.fc(size=hid1_size, act='relu')self.fc2 = layers.fc(size=hid2_size, act='relu')self.fc3 = layers.fc(size=act_dim, act=None)def value(self, obs):# 定义网络# 输入state,输出所有action对应的Q,[Q(s,a1), Q(s,a2), Q(s,a3)...]h1 = self.fc1(obs)h2 = self.fc2(h1)Q = self.fc3(h2)return Q # 输出的 Q 是一个向量,维度是动作的维度

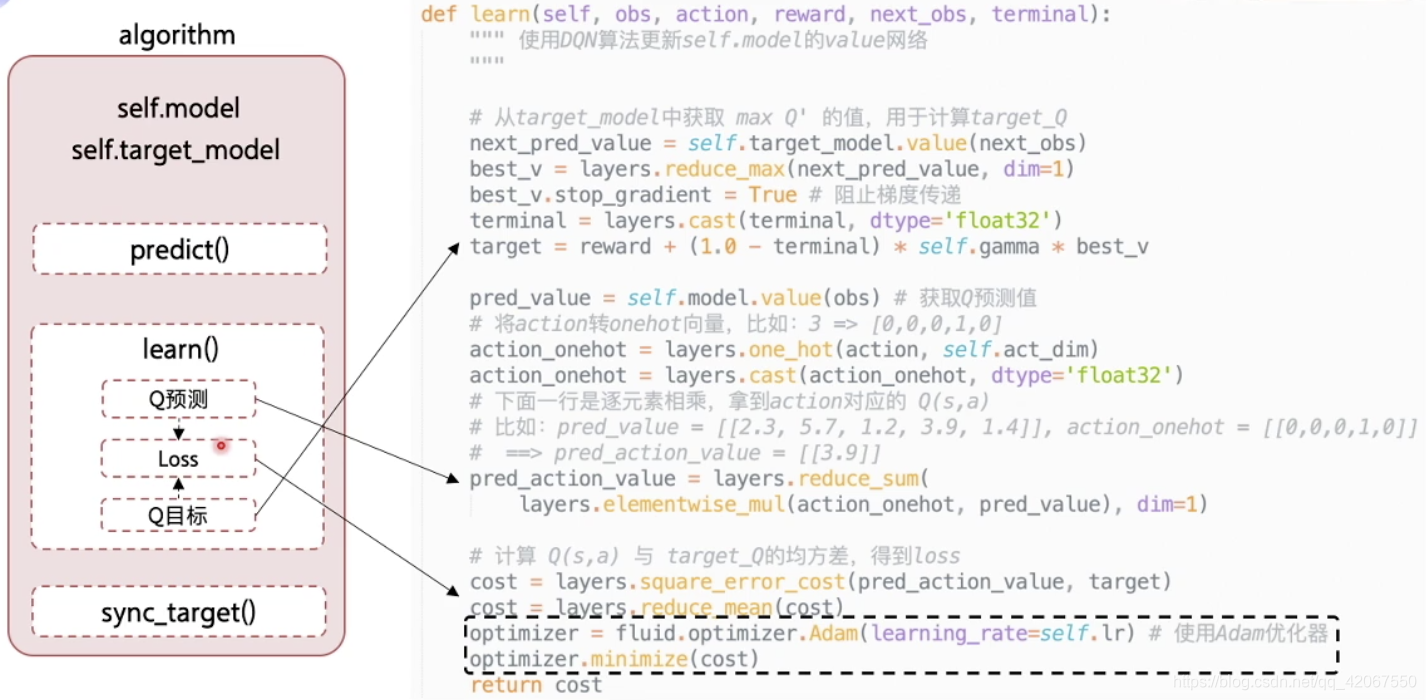

五、Algorithm

Algorithm 定义了具体的算法来更新前向网络(Model),也就是通过定义损失函数来更新Model,和算法相关的计算都放在algorithm中。

这里的核心是 learn() 函数,其中分为 3 部分:

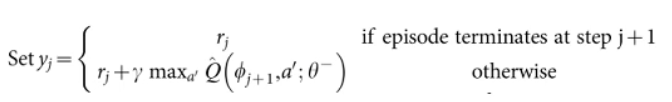

- 获取 Q 目标值

- 注意点:在 target_Q 的计算中,有个判断条件,是否游戏结束,计算公式不同

- terminal:即是否为 done,是的话为 true(1),否的话为 false(0)

- 所以用 作为系数就可以达到 “判断” 语句的效果(之前要先用 layers.cast 将 terminal 转化为浮点数)

- 注意点:best_v.stop_gradient = True 阻止梯度传递

- 我们在通过 神经网络获得 target_Q 的时候,并不希望去更新 target_model 神经网络参数,所以要阻止梯度传递

- 注意点:在 target_Q 的计算中,有个判断条件,是否游戏结束,计算公式不同

- 获取 Q 预测值

- 注意点:从 Q 值列表中取得对应 动作的 Q 值

- 首先把 action 转为 one-hot 向量

- 然后用两个向量元素相乘的方法 layers.elementwise_mul 只保留对应的值,其他变为 0

- 然后用元素累加的方法 layers.reduce_sum 就得到了最终的值 (这里是 “第 2 维” 的累加,所以 dim=1)

- 注意点:从 Q 值列表中取得对应 动作的 Q 值

- 计算 loss

这里 learn() 函数的输入 obs, action, reward, next_obs, terminal

由于每次传入一个 batch ,所以每一个参数都是一个数组

# from parl.algorithms import DQN # 也可以直接从parl库中导入DQN算法class DQN(parl.Algorithm):def __init__(self, model, act_dim=None, gamma=None, lr=None):""" DQN algorithmArgs:model (parl.Model): 定义Q函数的前向网络结构act_dim (int): action空间的维度,即有几个actiongamma (float): reward的衰减因子lr (float): learning rate 学习率."""self.model = model # 传入之前定义好的 model 结构self.target_model = copy.deepcopy(model) # 把模型硬拷贝一份,作为 target_model(固定)assert isinstance(act_dim, int) # 断言,确认动作维度,是 intassert isinstance(gamma, float) # 断言,确认衰减因子,是 floatassert isinstance(lr, float) # 断言,确定学习速率,是 floatself.act_dim = act_dim #传入self.gamma = gamma #传入self.lr = lr #传入def predict(self, obs):""" 使用self.model的value网络来获取 [Q(s,a1),Q(s,a2),...]"""return self.model.value(obs) # 把 obs 传入前向网络,得到当前状态下,所有可执行动作的 Q 值(预测值)def learn(self, obs, action, reward, next_obs, terminal):""" 使用DQN算法更新self.model的value网络"""# 1. 从target_model中获取 max Q' 的值,用于计算target_Q(目标值)next_pred_value = self.target_model.value(next_obs) # 获得下一步状态下,所以可执行动作的 Q 值best_v = layers.reduce_max(next_pred_value, dim=1)# 求最大 Q 值best_v.stop_gradient = True # 阻止梯度传递terminal = layers.cast(terminal, dtype='float32')# 把 terminal 转化为 float32 类型target = reward + (1.0 - terminal) * self.gamma * best_v# # 2. 获取 Q (预测值)pred_value = self.model.value(obs) # 正向传播,即获得了该状态下,所有动作对应的 Q 值 # 将action转onehot向量,比如:3 => [0,0,0,1,0]action_onehot = layers.one_hot(action, self.act_dim)# 输入的动作值,比如 4,根据 depth 即动作维度,转化为对应的 one-hotaction_onehot = layers.cast(action_onehot, dtype='float32')# 设定 one-hot 中的值为 float32 类型# 下面一行是逐元素相乘,拿到action对应的 Q(s,a)# 比如:pred_value = [[2.3, 5.7, 1.2, 3.9, 1.4]], action_onehot = [[0,0,0,1,0]]# ==> pred_action_value = [[3.9]]pred_action_value = layers.reduce_sum(layers.elementwise_mul(action_onehot, pred_value), dim=1)# 当前状态下,执行该 action 得到的 Q 值(预测值)# 3. 计算 Q(s,a) 与 target_Q的均方差,得到losscost = layers.square_error_cost(pred_action_value, target)# 损失函数为旧的 Q 和 目标 Q 之间的差别(均方差)cost = layers.reduce_mean(cost)# 均值optimizer = fluid.optimizer.Adam(learning_rate=self.lr) # 使用Adam优化器optimizer.minimize(cost) # 目标是最小化损失函数return costdef sync_target(self):""" 把 self.model 的模型参数值同步到 self.target_model"""self.model.sync_weights_to(self.target_model)# 这是 parl.Model 这个基类下的方法,用于定时为target_model做参数同步六、Agent

Agent 负责算法与环境的交互,在交互过程中把生成的数据提供给Algorithm来更新模型(Model),数据的预处理流程也一般定义在这里。

-

这里 learn() 函数的输入也是从经验池中拿到的一个 batch 的数据,然后进行对应的变量赋值

-

变量的定义是在 build_program() 中(计算图)完成,包括变量的 类型 dtype,结构 shape,名字 name

-

然后每执行一次 learn() 就是把数据通过 feed 传入 program,然后获取 fetch_list 中的 self.cost

-

每一次执行 run 就是完成了一次网络的更新

-

-

这里还有一个计算图 pred_program 用于获取最大的 Q 值(预测值)下的 action

- 首先通过 predict() 函数,调用 alg 中的 predict() 计算最大的 Q 值

- 然后获取对应的 action,仅需使用 np.argmax 函数

- 然后通过 sample() 函数决定是利用还是探索,选择具体执行的动作

class Agent(parl.Agent):# 继承了 parl.Agent 这个基类# 其实基类下只有一个 save 和 restore 方法# 其他的方法:build_program,learn,predict,sample 都是空的def __init__(self,algorithm, # 算法obs_dim, # 状态的维度act_dim, # 动作的维度e_greed=0.1, # 10% 的随机探索概率e_greed_decrement=0): # 概率递减为 0assert isinstance(obs_dim, int) # 断言,状态维度,为 intassert isinstance(act_dim, int) # 断言,动作维度,为 intself.obs_dim = obs_dim # 初始化赋值self.act_dim = act_dim # 初始化赋值super(Agent, self).__init__(algorithm)# self.global_step = 0 # self.update_target_steps = 200 # 每隔200个training steps再把model的参数复制到target_model中self.e_greed = e_greed # 有一定概率随机选取动作,探索self.e_greed_decrement = e_greed_decrement # 随着训练逐步收敛,探索的程度慢慢降低def build_program(self):self.pred_program = fluid.Program() # 初始化一个 paddle.fluid 框架下的程序self.learn_program = fluid.Program() # 初始化一个 paddle.fluid 框架下的程序with fluid.program_guard(self.pred_program): # 搭建计算图用于 预测动作,定义输入输出变量# 把下面的语句添加到 self.pred_program 程序中obs = layers.data(name='obs', shape=[self.obs_dim], dtype='float32')# 将 obs 设定为数据变量self.value = self.alg.predict(obs)# with fluid.program_guard(self.learn_program): # 搭建计算图用于 更新Q网络,定义输入输出变量# 把下面的语句添加到 self.learn_program 程序中obs = layers.data(name='obs', shape=[self.obs_dim], dtype='float32')# 将 obs 设定为数据变量action = layers.data(name='act', shape=[1], dtype='int32')# 将 action 设定为数据变量reward = layers.data(name='reward', shape=[], dtype='float32')# 将 reward 设定为数据变量next_obs = layers.data(name='next_obs', shape=[self.obs_dim], dtype='float32')# 将 next_obs 设定为数据变量terminal = layers.data(name='terminal', shape=[], dtype='bool')# 将 terminal 设定为数据变量self.cost = self.alg.learn(obs, action, reward, next_obs, terminal)# def sample(self, obs): # 采样动作sample = np.random.rand() # 产生0~1之间的小数if sample < self.e_greed: # 小于 0.1,即 10% 的概率act = np.random.randint(self.act_dim) # 探索:每个动作都有概率被选择else:act = self.predict(obs) # 选择最优动作self.e_greed = max(0.01, self.e_greed - self.e_greed_decrement) # 随着训练逐步收敛,探索的程度慢慢降低return actdef predict(self, obs): # 选择最优动作obs = np.expand_dims(obs, axis=0) # 将数字转化为一维向量pred_Q = self.fluid_executor.run(self.pred_program,feed={'obs': obs.astype('float32')},fetch_list=[self.value])[0]# 执行定义好的程序,获取 obs 状态下的,所有动作的 Q 值pred_Q = np.squeeze(pred_Q, axis=0)# 压缩一个维度act = np.argmax(pred_Q) # 选择Q最大的下标,即对应的动作return actdef learn(self, obs, act, reward, next_obs, terminal):# 每隔200个training steps同步一次model和target_model的参数if self.global_step % self.update_target_steps == 0:self.alg.sync_target()#self.global_step += 1# 步数+1act = np.expand_dims(act, -1) # 将数字转化为一维向量feed = {'obs': obs.astype('float32'),'act': act.astype('int32'),'reward': reward,'next_obs': next_obs.astype('float32'),'terminal': terminal}# 定义所有传入的数据cost = self.fluid_executor.run(self.learn_program, feed=feed, fetch_list=[self.cost])[0] # 训练一次网络return cost

七、ReplayMemory

经验池:用于存储多条经验,实现 经验回放。

import random

import collections

import numpy as npclass ReplayMemory(object):def __init__(self, max_size):self.buffer = collections.deque(maxlen=max_size)# 初始化一个双向列表,长度为 max_size# 增加一条经验到经验池中def append(self, exp):self.buffer.append(exp)# 在列表尾部增加一条经验# 从经验池中选取N条经验出来def sample(self, batch_size):mini_batch = random.sample(self.buffer, batch_size)# 从缓存列表中,随机去除 batch_size 条经验obs_batch, action_batch, reward_batch, next_obs_batch, done_batch = [], [], [], [], []# 初始化列表for experience in mini_batch:s, a, r, s_p, done = experience # 从 mini_batch 中去取得对应元素# 加入各自的列表中obs_batch.append(s)action_batch.append(a)reward_batch.append(r)next_obs_batch.append(s_p)done_batch.append(done)# 转化为 numpy 的数组进行返回return np.array(obs_batch).astype('float32'), \np.array(action_batch).astype('float32'), np.array(reward_batch).astype('float32'),\np.array(next_obs_batch).astype('float32'), np.array(done_batch).astype('float32')def __len__(self):return len(self.buffer) # 设定一个参数 len 是缓存的长度八、Training && Test(训练&&测试)

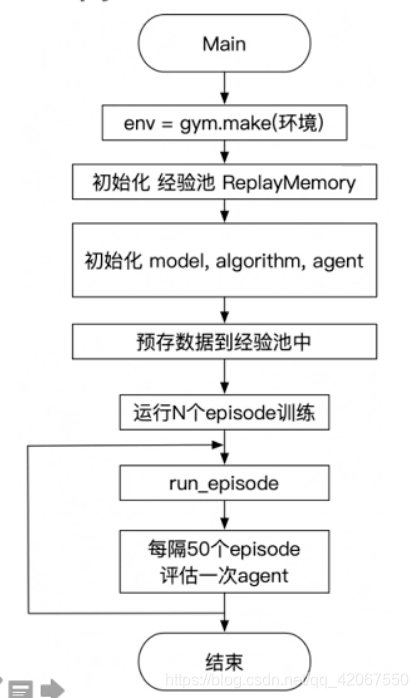

训练的时候,需要先填满经验池才开始

- 采用 sample 方式,有探索概率

评估的时候,这里设定为 5 个 episode 求平均分

- 这是因为强化学习有一定不确定性

- 环境也有随机选

- 所以哪怕是一个训练好的 agent,单次的 episode 的分数也可能特别差/特别好

- 所以多跑几组求平均这样的评估比较客观

# 训练一个episode

def run_episode(env, agent, rpm):total_reward = 0 # 累计奖励初始化obs = env.reset() # 初始化一个环境,返回值是初始状态 obsstep = 0 # 初始化步数while True:step += 1action = agent.sample(obs) # 采样动作,所有动作都有概率被尝试到next_obs, reward, done, _ = env.step(action)rpm.append((obs, action, reward, next_obs, done))# train modelif (len(rpm) > MEMORY_WARMUP_SIZE) and (step % LEARN_FREQ == 0):(batch_obs, batch_action, batch_reward, batch_next_obs,batch_done) = rpm.sample(BATCH_SIZE)train_loss = agent.learn(batch_obs, batch_action, batch_reward,batch_next_obs,batch_done) # s,a,r,s',donetotal_reward += rewardobs = next_obsif done:breakreturn total_reward# 评估 agent, 跑 5 个episode,总reward求平均

def evaluate(env, agent, render=False):eval_reward = []for i in range(5):obs = env.reset()episode_reward = 0while True:action = agent.predict(obs) # 预测动作,只选最优动作obs, reward, done, _ = env.step(action)episode_reward += rewardif render:env.render()if done:breakeval_reward.append(episode_reward)return np.mean(eval_reward)九、创建环境和Agent,创建经验池,启动训练,保存模型

env = gym.make('CartPole-v0') # CartPole-v0: 预期最后一次评估总分 > 180(最大值是200)

action_dim = env.action_space.n # CartPole-v0: 2

obs_shape = env.observation_space.shape # CartPole-v0: (4,)rpm = ReplayMemory(MEMORY_SIZE) # DQN的经验回放池实例化# 根据parl框架构建agent

model = Model(act_dim=action_dim) # 模型实例化

algorithm = DQN(model, act_dim=action_dim, gamma=GAMMA, lr=LEARNING_RATE) # 算法实例化(传入模型)

# agent 实例化(传入算法)

agent = Agent(algorithm,obs_dim=obs_shape[0],act_dim=action_dim,e_greed=0.1, # 有一定概率随机选取动作,探索e_greed_decrement=1e-6) # 随着训练逐步收敛,探索的程度慢慢降低# 加载模型

# save_path = './dqn_model.ckpt'

# agent.restore(save_path)# 先往经验池里存一些数据,避免最开始训练的时候样本丰富度不够

while len(rpm) < MEMORY_WARMUP_SIZE: # 当经验池不满的时候(这里小于 200 条)run_episode(env, agent, rpm) # 持续添加到经验池(没有开始进行训练)max_episode = 2000# 开始训练

episode = 0

while episode < max_episode: # 训练max_episode个回合,test部分不计算入episode数量# train partfor i in range(0, 50):total_reward = run_episode(env, agent, rpm)episode += 1# test parteval_reward = evaluate(env, agent, render=False) # render=True 查看显示效果logger.info('episode:{} e_greed:{} test_reward:{}'.format(episode, agent.e_greed, eval_reward))# 训练结束,保存模型

save_path = './dqn_model.ckpt'

agent.save(save_path)

十、总结

如若内容造成侵权/违法违规/事实不符,请联系编程学习网邮箱:809451989@qq.com进行投诉反馈,一经查实,立即删除!

相关文章

- 35、DOM方法

文章目录介绍Dom方法 介绍 本文是在学习JS所做的学习笔记,所有笔记内容请看:JS学习笔记 Dom方法 <!DOCTYPE html> <html lang="en"> <head><meta charset="UTF-8"><title>Title</title> </head> <body>…...

2024/5/8 15:12:02 - 6,kubernetes-存储

1 configMap1.1 configMap 描述信息ConfigMap 功能在 Kubernetes1.2 版本中引入,许多应用程序会从配置文件、命令行参数或环境变量中读取配置信息。ConfigMapAPI给我们提供了向容器中注入配置信息的机制,ConfigMap可以被用来保存单个属性,也 可以用来保存整个配置文件或者 J…...

2024/5/8 16:30:44 - HTML5调用摄像头录制视频

HTML5调用摄像头录制视频 不支持ie,ie下不支持webrtc,无法使用navigator.getUserMedia调用摄像头<!DOCTYPE html> <html><head><title>video recoder</title><script src="fileSaver.js"></script><meta http-equiv=…...

2024/5/8 20:53:37 - Python termios.ICANON

https://www.kutu66.com//Python-Module-Examples/article_63230 https://www.jb51.net/article/101640.htm https://blog.csdn.net/qq_16234613/article/details/79532050 https://www.jb51.cc/linux/393386.html...

2024/4/24 13:53:47 - T-SQL语句中前缀N的含义是什么?

本文翻译自:What is the meaning of the prefix N in T-SQL statements? I have seen prefix N in some insert T-SQL queries. 我在某些插入T-SQL查询中看到前缀N。 Many people have used N before inserting the value in a table. 在表中插入值之前,许多人都使用了N I s…...

2024/4/24 13:53:49 - Java基础--JDBC

JDBC Java语言连接数据库(java DataBase Connectivity) 本质是sun公司制定的一套接口。 JDBC前的准备工作 1.下载对应数据库的驱动(jar)//jar包里是class文件,数据库厂家对JDBC接口的实现类 2.a.在记事本中编写Java程序需要配置环境变量class path b.在工具中编写Java程序需…...

2024/4/24 13:53:45 - js insertAdjacentElement() 移动元素到指定位置

MDN文档 MDN文档 insertAdjacentElement() 移动元素到指定位置 ele.insertAdjacentElement(position,element) // element移动的元素position beforebegin //在本身之前插入 afterbegin //在第一个子节点直接插入 brforeend //在最后一个子节点直接插入 afterend //在本身之后插…...

2024/4/24 13:53:47 - 在Windows系统下安装tensorflow

window10 + tensorflow 安装在Windows系统下安装tensorflow1、安装anaconda2、安装tensorflow3、安装测试 在Windows系统下安装tensorflow 在windows系统下一般会通过Anaconda进行安装,主要的步骤如下: 1、安装anaconda 从官网下载:https://www.anaconda.com/download/ 官网…...

2024/4/24 13:53:45 - Java基础:super、this关键字的小结

【super】关键字用来访问父类内容在子类的成员方法中,访问父类的成员变量; 在子类的成员方法中,访问父类的成员方法; 在子类的构造方法中,访问父类的构造方法(构造函数中的第一条语句)。【this】关键字用来访问本类内容在本类的成员方法中,访问本类的成员变量; 在本类…...

2024/4/24 13:53:43 - spark集群实现wordcount

环境配置是:hadoop2.7.2 + zookeeper 3.4.5+ spark 2.1.1说明:这里的wordcount是使用scala书写,资源调度使用的是yarn。1.环境搭建提前搭建好hadoop集群和zookeeper。2.搭建spark集群配置使用的是yarn的集群配置。所以要在启动spark之前线启动hdfs和yarn。3.代码书写:def m…...

2024/4/24 13:53:41 - c++函数默认参数,函数占位参数,函数重载,函数重载概述,函数重载注意事项

3函数提高 3.1函数默认参数 在c++中,函数的形参列表中的形参是可以有默认值 语法:返回值类型 函数名 (参数= 默认值) {} 示例: #include <iostream> using namespace std;//如果传入数据就是用传入值,如果没有传入数据,则使用默认值 //语法: 返回值类型 函数名 (形…...

2024/4/24 13:53:40 - JVM第十五章_垃圾回收相关算法

文章目录1、垃圾标记阶段的算法之运用技术算法垃圾标记阶段 :对象存活判断方式一: 引用计数算法循环引用小结2、垃圾标记阶段的算法之可达分析性算法方式二:可达性分析(或根搜索算法、追踪性垃圾收集)GC Roots注意:3、对象的finalization机制生存还是死亡?具体过程4、垃圾标记…...

2024/4/15 3:31:46 - 洛谷 P1063 能量项链 区间DP

思路:区间DP,这道题的描述感觉还是很复杂的,不妨这样想:给定一个数列,首先扩展成两倍的长度,每三个数可以进行合并,合并之后两端的数保留,因此,f[i][j]f[i][j]f[i][j] 表示 [i,j][i,j][i,j] 区间的最大能量,e[i]e[i]e[i] 表示第 iii 个数的值,则: f[i][j]=max(f[…...

2024/4/19 13:33:27 - 《给海子》

生锈的的寒铁 腐蚀了几千年的光阴 在乱石堆中 将路伸向另一个世界 风中 狗尾巴草 折断的肢体像是两节树枝 那疼痛的记忆 像是刻在钢板上的印痕 几年前 铁轨还没有荒废 从山海关到归宿 梦在睡着的时候开始 新约与旧约 瓦尔登胡 你太高 我站着敬仰 令生 来世...

2024/4/15 3:31:43 - pandas学习-1

pandas学习 numpy能够帮助我们处理数值,但是pandas除了处理数值之外(基于numpy),还能能帮助我们处理其他类型的数据。 常用数据类型有:Series一维,带标签(索引)数组 DataFrame二维,Series容器pandas之Series创建import pandas as pdt1 = pd.Series([1, 2, 31, 12, 3, 4]…...

2024/4/15 3:31:43 - 前端算法_链表

线性数据结构之链表 什么是数据结构啊,比如我要搬家,会把杂七杂八的东西放在箱子里,这个箱子就是数据结构。算法就是我把东西通过箱子运到新家的过程。 线性数据结构?两点一线,三维空间,四维加个时间… 放到代码里,线性数据结构:数组、链表看看数组:const arr = [1,2,3…...

2024/4/15 3:31:41 - 大数据分析有什么特点

要理解大数据,我们必须首先从大数据的概念开始。与人工智能的概念不同,大数据的概念相对清晰,大数据的技术体系也已经成熟。为了解释大数据的概念,您可以从数据本身的特征开始,然后从方案,应用和行业逐步扩展。大数据本身的特点通常集中在五个方面,即数据量,数据结构多…...

2024/4/17 14:25:28 - B 1047 编程团体赛(两种方法:结构体排序+散列)

题目思路: 比较典型的考题。 我用了之前常考的结构体排序,相对而言适用性广一点。算法笔记用的是散列,相对来说更简洁一点。 AC代码 结构体排序: #include<bits/stdc++.h> using namespace std;struct race{int squad;int score;int nscore;race(){squad=0;score=0;n…...

2024/4/15 3:31:39 - ArcGIS使用(一)创建ArcGIS应用

ArcGIS官方文档:https://developers.arcgis.com/javascript/第一章、认识和使用ArcGIS1 ArcGIS for js 4.x使用的是4.15 版本,ArcGIS 每个版本之间有差别,3 和4 的差别有点大4 地图可以2D或3D显示,修改了绘图逻辑,地图和图层不在处理逻辑,而是由view处理视图专门用于可视化…...

2024/4/15 3:31:39 - connection to database zabbix failed:(zabbix连接不上数据库的解决方法)

在配置LNMP+zabbix时,发现zabbix_server服务可以启动,但是没有10051这个端口。查看日志,报错如下:发现日志链接不上:查找这个文件所在的位置:解决方法有两种: (一)创建mysql.sock链接重启数据库服务(二)修改zabbix_server.conf中的mysql.sock配置重启zabbix_server服…...

2024/4/24 13:53:39

最新文章

- react 项目中使用 iconfont

在 iconfont 上面下载喜欢的字体图标:iconfont-阿里巴巴矢量图标库 添加购物车,下载代码,解压。 将 ttf 字体文件添加到项目的某个文件夹(这里我的文件夹是 font)内 将一些样式放到项目中(此时我放入的是…...

2024/5/9 9:42:35 - 梯度消失和梯度爆炸的一些处理方法

在这里是记录一下梯度消失或梯度爆炸的一些处理技巧。全当学习总结了如有错误还请留言,在此感激不尽。 权重和梯度的更新公式如下: w w − η ⋅ ∇ w w w - \eta \cdot \nabla w ww−η⋅∇w 个人通俗的理解梯度消失就是网络模型在反向求导的时候出…...

2024/5/7 10:36:02 - 【python】Flask Web框架

文章目录 WSGI(Web服务器网关接口)示例Web应用程序Web框架Flask框架创建项目安装Flask创建一个基本的 Flask 应用程序调试模式路由添加变量构造URLHTTP方法静态文件模板—— Jinja2模板文件(Template File)<...

2024/5/8 1:34:38 - 【快捷部署】010_MySQL(5.7.27)

📣【快捷部署系列】010期信息 编号选型版本操作系统部署形式部署模式复检时间010MySQL5.7.27Ubuntu 20.04Docker单机2024-03-28 一、快捷部署 #!/bin/bash ################################################################################# # 作者:…...

2024/5/5 8:37:16 - 【外汇早评】美通胀数据走低,美元调整

原标题:【外汇早评】美通胀数据走低,美元调整昨日美国方面公布了新一期的核心PCE物价指数数据,同比增长1.6%,低于前值和预期值的1.7%,距离美联储的通胀目标2%继续走低,通胀压力较低,且此前美国一季度GDP初值中的消费部分下滑明显,因此市场对美联储后续更可能降息的政策…...

2024/5/8 6:01:22 - 【原油贵金属周评】原油多头拥挤,价格调整

原标题:【原油贵金属周评】原油多头拥挤,价格调整本周国际劳动节,我们喜迎四天假期,但是整个金融市场确实流动性充沛,大事频发,各个商品波动剧烈。美国方面,在本周四凌晨公布5月份的利率决议和新闻发布会,维持联邦基金利率在2.25%-2.50%不变,符合市场预期。同时美联储…...

2024/5/7 9:45:25 - 【外汇周评】靓丽非农不及疲软通胀影响

原标题:【外汇周评】靓丽非农不及疲软通胀影响在刚结束的周五,美国方面公布了新一期的非农就业数据,大幅好于前值和预期,新增就业重新回到20万以上。具体数据: 美国4月非农就业人口变动 26.3万人,预期 19万人,前值 19.6万人。 美国4月失业率 3.6%,预期 3.8%,前值 3…...

2024/5/4 23:54:56 - 【原油贵金属早评】库存继续增加,油价收跌

原标题:【原油贵金属早评】库存继续增加,油价收跌周三清晨公布美国当周API原油库存数据,上周原油库存增加281万桶至4.692亿桶,增幅超过预期的74.4万桶。且有消息人士称,沙特阿美据悉将于6月向亚洲炼油厂额外出售更多原油,印度炼油商预计将每日获得至多20万桶的额外原油供…...

2024/5/9 4:20:59 - 【外汇早评】日本央行会议纪要不改日元强势

原标题:【外汇早评】日本央行会议纪要不改日元强势近两日日元大幅走强与近期市场风险情绪上升,避险资金回流日元有关,也与前一段时间的美日贸易谈判给日本缓冲期,日本方面对汇率问题也避免继续贬值有关。虽然今日早间日本央行公布的利率会议纪要仍然是支持宽松政策,但这符…...

2024/5/4 23:54:56 - 【原油贵金属早评】欧佩克稳定市场,填补伊朗问题的影响

原标题:【原油贵金属早评】欧佩克稳定市场,填补伊朗问题的影响近日伊朗局势升温,导致市场担忧影响原油供给,油价试图反弹。此时OPEC表态稳定市场。据消息人士透露,沙特6月石油出口料将低于700万桶/日,沙特已经收到石油消费国提出的6月份扩大出口的“适度要求”,沙特将满…...

2024/5/4 23:55:05 - 【外汇早评】美欲与伊朗重谈协议

原标题:【外汇早评】美欲与伊朗重谈协议美国对伊朗的制裁遭到伊朗的抗议,昨日伊朗方面提出将部分退出伊核协议。而此行为又遭到欧洲方面对伊朗的谴责和警告,伊朗外长昨日回应称,欧洲国家履行它们的义务,伊核协议就能保证存续。据传闻伊朗的导弹已经对准了以色列和美国的航…...

2024/5/4 23:54:56 - 【原油贵金属早评】波动率飙升,市场情绪动荡

原标题:【原油贵金属早评】波动率飙升,市场情绪动荡因中美贸易谈判不安情绪影响,金融市场各资产品种出现明显的波动。随着美国与中方开启第十一轮谈判之际,美国按照既定计划向中国2000亿商品征收25%的关税,市场情绪有所平复,已经开始接受这一事实。虽然波动率-恐慌指数VI…...

2024/5/7 11:36:39 - 【原油贵金属周评】伊朗局势升温,黄金多头跃跃欲试

原标题:【原油贵金属周评】伊朗局势升温,黄金多头跃跃欲试美国和伊朗的局势继续升温,市场风险情绪上升,避险黄金有向上突破阻力的迹象。原油方面稍显平稳,近期美国和OPEC加大供给及市场需求回落的影响,伊朗局势并未推升油价走强。近期中美贸易谈判摩擦再度升级,美国对中…...

2024/5/4 23:54:56 - 【原油贵金属早评】市场情绪继续恶化,黄金上破

原标题:【原油贵金属早评】市场情绪继续恶化,黄金上破周初中国针对于美国加征关税的进行的反制措施引发市场情绪的大幅波动,人民币汇率出现大幅的贬值动能,金融市场受到非常明显的冲击。尤其是波动率起来之后,对于股市的表现尤其不安。隔夜美国股市出现明显的下行走势,这…...

2024/5/6 1:40:42 - 【外汇早评】美伊僵持,风险情绪继续升温

原标题:【外汇早评】美伊僵持,风险情绪继续升温昨日沙特两艘油轮再次发生爆炸事件,导致波斯湾局势进一步恶化,市场担忧美伊可能会出现摩擦生火,避险品种获得支撑,黄金和日元大幅走强。美指受中美贸易问题影响而在低位震荡。继5月12日,四艘商船在阿联酋领海附近的阿曼湾、…...

2024/5/4 23:54:56 - 【原油贵金属早评】贸易冲突导致需求低迷,油价弱势

原标题:【原油贵金属早评】贸易冲突导致需求低迷,油价弱势近日虽然伊朗局势升温,中东地区几起油船被袭击事件影响,但油价并未走高,而是出于调整结构中。由于市场预期局势失控的可能性较低,而中美贸易问题导致的全球经济衰退风险更大,需求会持续低迷,因此油价调整压力较…...

2024/5/8 20:48:49 - 氧生福地 玩美北湖(上)——为时光守候两千年

原标题:氧生福地 玩美北湖(上)——为时光守候两千年一次说走就走的旅行,只有一张高铁票的距离~ 所以,湖南郴州,我来了~ 从广州南站出发,一个半小时就到达郴州西站了。在动车上,同时改票的南风兄和我居然被分到了一个车厢,所以一路非常愉快地聊了过来。 挺好,最起…...

2024/5/7 9:26:26 - 氧生福地 玩美北湖(中)——永春梯田里的美与鲜

原标题:氧生福地 玩美北湖(中)——永春梯田里的美与鲜一觉醒来,因为大家太爱“美”照,在柳毅山庄去寻找龙女而错过了早餐时间。近十点,向导坏坏还是带着饥肠辘辘的我们去吃郴州最富有盛名的“鱼头粉”。说这是“十二分推荐”,到郴州必吃的美食之一。 哇塞!那个味美香甜…...

2024/5/4 23:54:56 - 氧生福地 玩美北湖(下)——奔跑吧骚年!

原标题:氧生福地 玩美北湖(下)——奔跑吧骚年!让我们红尘做伴 活得潇潇洒洒 策马奔腾共享人世繁华 对酒当歌唱出心中喜悦 轰轰烈烈把握青春年华 让我们红尘做伴 活得潇潇洒洒 策马奔腾共享人世繁华 对酒当歌唱出心中喜悦 轰轰烈烈把握青春年华 啊……啊……啊 两…...

2024/5/8 19:33:07 - 扒开伪装医用面膜,翻六倍价格宰客,小姐姐注意了!

原标题:扒开伪装医用面膜,翻六倍价格宰客,小姐姐注意了!扒开伪装医用面膜,翻六倍价格宰客!当行业里的某一品项火爆了,就会有很多商家蹭热度,装逼忽悠,最近火爆朋友圈的医用面膜,被沾上了污点,到底怎么回事呢? “比普通面膜安全、效果好!痘痘、痘印、敏感肌都能用…...

2024/5/5 8:13:33 - 「发现」铁皮石斛仙草之神奇功效用于医用面膜

原标题:「发现」铁皮石斛仙草之神奇功效用于医用面膜丽彦妆铁皮石斛医用面膜|石斛多糖无菌修护补水贴19大优势: 1、铁皮石斛:自唐宋以来,一直被列为皇室贡品,铁皮石斛生于海拔1600米的悬崖峭壁之上,繁殖力差,产量极低,所以古代仅供皇室、贵族享用 2、铁皮石斛自古民间…...

2024/5/8 20:38:49 - 丽彦妆\医用面膜\冷敷贴轻奢医学护肤引导者

原标题:丽彦妆\医用面膜\冷敷贴轻奢医学护肤引导者【公司简介】 广州华彬企业隶属香港华彬集团有限公司,专注美业21年,其旗下品牌: 「圣茵美」私密荷尔蒙抗衰,产后修复 「圣仪轩」私密荷尔蒙抗衰,产后修复 「花茵莳」私密荷尔蒙抗衰,产后修复 「丽彦妆」专注医学护…...

2024/5/4 23:54:58 - 广州械字号面膜生产厂家OEM/ODM4项须知!

原标题:广州械字号面膜生产厂家OEM/ODM4项须知!广州械字号面膜生产厂家OEM/ODM流程及注意事项解读: 械字号医用面膜,其实在我国并没有严格的定义,通常我们说的医美面膜指的应该是一种「医用敷料」,也就是说,医用面膜其实算作「医疗器械」的一种,又称「医用冷敷贴」。 …...

2024/5/9 7:32:17 - 械字号医用眼膜缓解用眼过度到底有无作用?

原标题:械字号医用眼膜缓解用眼过度到底有无作用?医用眼膜/械字号眼膜/医用冷敷眼贴 凝胶层为亲水高分子材料,含70%以上的水分。体表皮肤温度传导到本产品的凝胶层,热量被凝胶内水分子吸收,通过水分的蒸发带走大量的热量,可迅速地降低体表皮肤局部温度,减轻局部皮肤的灼…...

2024/5/4 23:54:56 - 配置失败还原请勿关闭计算机,电脑开机屏幕上面显示,配置失败还原更改 请勿关闭计算机 开不了机 这个问题怎么办...

解析如下:1、长按电脑电源键直至关机,然后再按一次电源健重启电脑,按F8健进入安全模式2、安全模式下进入Windows系统桌面后,按住“winR”打开运行窗口,输入“services.msc”打开服务设置3、在服务界面,选中…...

2022/11/19 21:17:18 - 错误使用 reshape要执行 RESHAPE,请勿更改元素数目。

%读入6幅图像(每一幅图像的大小是564*564) f1 imread(WashingtonDC_Band1_564.tif); subplot(3,2,1),imshow(f1); f2 imread(WashingtonDC_Band2_564.tif); subplot(3,2,2),imshow(f2); f3 imread(WashingtonDC_Band3_564.tif); subplot(3,2,3),imsho…...

2022/11/19 21:17:16 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机...

win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”问题的解决方法在win7系统关机时如果有升级系统的或者其他需要会直接进入一个 等待界面,在等待界面中我们需要等待操作结束才能关机,虽然这比较麻烦,但是对系统进行配置和升级…...

2022/11/19 21:17:15 - 台式电脑显示配置100%请勿关闭计算机,“准备配置windows 请勿关闭计算机”的解决方法...

有不少用户在重装Win7系统或更新系统后会遇到“准备配置windows,请勿关闭计算机”的提示,要过很久才能进入系统,有的用户甚至几个小时也无法进入,下面就教大家这个问题的解决方法。第一种方法:我们首先在左下角的“开始…...

2022/11/19 21:17:14 - win7 正在配置 请勿关闭计算机,怎么办Win7开机显示正在配置Windows Update请勿关机...

置信有很多用户都跟小编一样遇到过这样的问题,电脑时发现开机屏幕显现“正在配置Windows Update,请勿关机”(如下图所示),而且还需求等大约5分钟才干进入系统。这是怎样回事呢?一切都是正常操作的,为什么开时机呈现“正…...

2022/11/19 21:17:13 - 准备配置windows 请勿关闭计算机 蓝屏,Win7开机总是出现提示“配置Windows请勿关机”...

Win7系统开机启动时总是出现“配置Windows请勿关机”的提示,没过几秒后电脑自动重启,每次开机都这样无法进入系统,此时碰到这种现象的用户就可以使用以下5种方法解决问题。方法一:开机按下F8,在出现的Windows高级启动选…...

2022/11/19 21:17:12 - 准备windows请勿关闭计算机要多久,windows10系统提示正在准备windows请勿关闭计算机怎么办...

有不少windows10系统用户反映说碰到这样一个情况,就是电脑提示正在准备windows请勿关闭计算机,碰到这样的问题该怎么解决呢,现在小编就给大家分享一下windows10系统提示正在准备windows请勿关闭计算机的具体第一种方法:1、2、依次…...

2022/11/19 21:17:11 - 配置 已完成 请勿关闭计算机,win7系统关机提示“配置Windows Update已完成30%请勿关闭计算机”的解决方法...

今天和大家分享一下win7系统重装了Win7旗舰版系统后,每次关机的时候桌面上都会显示一个“配置Windows Update的界面,提示请勿关闭计算机”,每次停留好几分钟才能正常关机,导致什么情况引起的呢?出现配置Windows Update…...

2022/11/19 21:17:10 - 电脑桌面一直是清理请关闭计算机,windows7一直卡在清理 请勿关闭计算机-win7清理请勿关机,win7配置更新35%不动...

只能是等着,别无他法。说是卡着如果你看硬盘灯应该在读写。如果从 Win 10 无法正常回滚,只能是考虑备份数据后重装系统了。解决来方案一:管理员运行cmd:net stop WuAuServcd %windir%ren SoftwareDistribution SDoldnet start WuA…...

2022/11/19 21:17:09 - 计算机配置更新不起,电脑提示“配置Windows Update请勿关闭计算机”怎么办?

原标题:电脑提示“配置Windows Update请勿关闭计算机”怎么办?win7系统中在开机与关闭的时候总是显示“配置windows update请勿关闭计算机”相信有不少朋友都曾遇到过一次两次还能忍但经常遇到就叫人感到心烦了遇到这种问题怎么办呢?一般的方…...

2022/11/19 21:17:08 - 计算机正在配置无法关机,关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机...

关机提示 windows7 正在配置windows 请勿关闭计算机 ,然后等了一晚上也没有关掉。现在电脑无法正常关机以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!关机提示 windows7 正在配…...

2022/11/19 21:17:05 - 钉钉提示请勿通过开发者调试模式_钉钉请勿通过开发者调试模式是真的吗好不好用...

钉钉请勿通过开发者调试模式是真的吗好不好用 更新时间:2020-04-20 22:24:19 浏览次数:729次 区域: 南阳 > 卧龙 列举网提醒您:为保障您的权益,请不要提前支付任何费用! 虚拟位置外设器!!轨迹模拟&虚拟位置外设神器 专业用于:钉钉,外勤365,红圈通,企业微信和…...

2022/11/19 21:17:05 - 配置失败还原请勿关闭计算机怎么办,win7系统出现“配置windows update失败 还原更改 请勿关闭计算机”,长时间没反应,无法进入系统的解决方案...

前几天班里有位学生电脑(windows 7系统)出问题了,具体表现是开机时一直停留在“配置windows update失败 还原更改 请勿关闭计算机”这个界面,长时间没反应,无法进入系统。这个问题原来帮其他同学也解决过,网上搜了不少资料&#x…...

2022/11/19 21:17:04 - 一个电脑无法关闭计算机你应该怎么办,电脑显示“清理请勿关闭计算机”怎么办?...

本文为你提供了3个有效解决电脑显示“清理请勿关闭计算机”问题的方法,并在最后教给你1种保护系统安全的好方法,一起来看看!电脑出现“清理请勿关闭计算机”在Windows 7(SP1)和Windows Server 2008 R2 SP1中,添加了1个新功能在“磁…...

2022/11/19 21:17:03 - 请勿关闭计算机还原更改要多久,电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机怎么办...

许多用户在长期不使用电脑的时候,开启电脑发现电脑显示:配置windows更新失败,正在还原更改,请勿关闭计算机。。.这要怎么办呢?下面小编就带着大家一起看看吧!如果能够正常进入系统,建议您暂时移…...

2022/11/19 21:17:02 - 还原更改请勿关闭计算机 要多久,配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以...

配置windows update失败 还原更改 请勿关闭计算机,电脑开机后一直显示以以下文字资料是由(历史新知网www.lishixinzhi.com)小编为大家搜集整理后发布的内容,让我们赶快一起来看一下吧!配置windows update失败 还原更改 请勿关闭计算机&#x…...

2022/11/19 21:17:01 - 电脑配置中请勿关闭计算机怎么办,准备配置windows请勿关闭计算机一直显示怎么办【图解】...

不知道大家有没有遇到过这样的一个问题,就是我们的win7系统在关机的时候,总是喜欢显示“准备配置windows,请勿关机”这样的一个页面,没有什么大碍,但是如果一直等着的话就要两个小时甚至更久都关不了机,非常…...

2022/11/19 21:17:00 - 正在准备配置请勿关闭计算机,正在准备配置windows请勿关闭计算机时间长了解决教程...

当电脑出现正在准备配置windows请勿关闭计算机时,一般是您正对windows进行升级,但是这个要是长时间没有反应,我们不能再傻等下去了。可能是电脑出了别的问题了,来看看教程的说法。正在准备配置windows请勿关闭计算机时间长了方法一…...

2022/11/19 21:16:59 - 配置失败还原请勿关闭计算机,配置Windows Update失败,还原更改请勿关闭计算机...

我们使用电脑的过程中有时会遇到这种情况,当我们打开电脑之后,发现一直停留在一个界面:“配置Windows Update失败,还原更改请勿关闭计算机”,等了许久还是无法进入系统。如果我们遇到此类问题应该如何解决呢࿰…...

2022/11/19 21:16:58 - 如何在iPhone上关闭“请勿打扰”

Apple’s “Do Not Disturb While Driving” is a potentially lifesaving iPhone feature, but it doesn’t always turn on automatically at the appropriate time. For example, you might be a passenger in a moving car, but your iPhone may think you’re the one dri…...

2022/11/19 21:16:57